RecSys2023:Large Language Models for Generative Recommendation: A Survey and Visionary Discussions(LLM推荐系统综述)

论文链接:https://arxiv.org/abs/2309.01157

作者认为大语言模型虽然已经在nlp和cv上有不错的应用,但在推荐系统上,大语言模型还是作为一个特征提取器的辅助手段,这可能在推荐系统上根本没有释放大语言模型强大的能力。

作者调查通过检查三个问题回顾了基于LLM的生成推荐的进展、方法和未来方向:1)生成推荐是什么;2)为什么RS应该提前生成推荐;3)如何为各种RS任务实现基于LLM的生成推荐。希望调查能够提供探索这一有趣和新兴主题所需的上下文和指导。

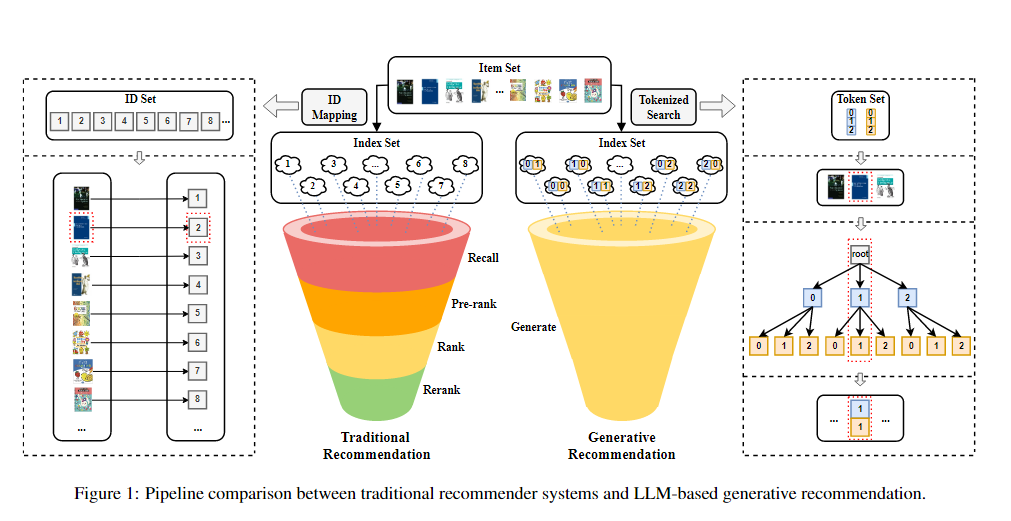

作者认为llm推荐可以作为端到端的生成,一步到位,直接吧推荐列表生成出来。

之前推荐系统的流程一般在工业上是先通过简单的模型进行召回,排序,后面缩小范围后才用较为复杂的模型进行精排,所以工业上和学术上差距比较大,主要原因是因为学术没有考虑那么全面落地成本。而大模型做推荐系统在工业上和学术上差距就没有那么大

1.使用评分推荐

作者举了个例子,用llm来评分,可以直接用自然语言描述用户和物品的关系,然后直接让llm打分,比如1-5分,然后llm输出4.12分这样。

存在问题:作者也表示用户可能不会为他们交互的每个项目留下明确的评级,因此评级预测任务对于现实世界的系统可能不太实用。

2.排序推荐

仅包含用户信息(ID 或用户元数据)的提示,并要求 LLM 直接为该用户生成推荐。

提供了提示中的用户信息和候选项目列表,并要求 LLM 从候选项目中选择项目进行推荐。

3.顺序推荐

就是预测用户 u 可能基于他/她的过去交互进行交互的下一个项目

4.可解释性推荐

可解释性推荐,就是cot的方式用于llm推荐

评估llm的推荐性能的指标还是传统推荐系统的那些指标,比如rmse,mae等等

作者认为解决llm推荐幻觉问题的方法之一是:创建项目 ID 并将所有项目的 ID 组织成前缀树结构,也称为 trie 结构。

另一种解决幻觉的方法就是rag,通过约束索引来解决问题

总的来说,作者对2023年9月份前(可能更早)llm在rs领域的研究进行总结说明,也提出了一点点自己的看法,但不多,在2023年11月份看来一些小的观点可能已经过时,比如:当时llm的上下文限制确实比较大,随着llm的发展上下文限制被逐步打开。可以作为论文索引收藏(去看他的引用文献)