From c8891d3040a0c0ef94d072f727f6034db08e5a84 Mon Sep 17 00:00:00 2001

From: Victor Manoel <117121760+VictorMPicoli@users.noreply.github.com>

Date: Sat, 14 Oct 2023 05:46:59 -0300

Subject: [PATCH] Docs: Rewrite Chapter 0 - Foundations (#11)

* docs: copied project structure for english translation

* Translation of folders 00 and 01

* Update of the translation proccess, please review item 06-unit.md for correct use of "Unit" terminology and all items for image sources integrity

---

docs/en/00-foundation/00-intro.md | 62 ++++

.../00-foundation/01-tradicional-vs-agile.md | 32 ++

docs/en/00-foundation/02-interaction.md | 18 ++

docs/en/00-foundation/03-tools.md | 39 +++

docs/en/00-foundation/04-artifacts.md | 36 +++

docs/en/00-foundation/05-identify.md | 41 +++

.../00-foundation/06-cases-report-incident.md | 47 +++

docs/en/00-foundation/07-questions.md | 306 ++++++++++++++++++

docs/en/01-approachs/00-intro.md | 32 ++

docs/en/01-approachs/01-white-box.md | 111 +++++++

docs/en/01-approachs/02-black-box.md | 41 +++

docs/en/01-approachs/03-gray-box.md | 61 ++++

docs/en/02-types/00-intro.md | 7 +

docs/en/02-types/01-functional.md | 92 ++++++

docs/en/02-types/02-uat.md | 98 ++++++

docs/en/02-types/03-exploratory.md | 59 ++++

docs/en/02-types/04-sanity.md | 60 ++++

docs/en/02-types/05-regression.md | 98 ++++++

docs/en/02-types/06-unit.md | 98 ++++++

docs/en/02-types/07-smoke.md | 46 +++

docs/en/02-types/08-integration.md | 160 +++++++++

docs/en/02-types/09-non-functional.md | 41 +++

docs/en/02-types/10-load.md | 60 ++++

docs/en/02-types/11-performance.md | 116 +++++++

docs/en/02-types/12-stress.md | 96 ++++++

docs/en/02-types/13-pentest.md | 78 +++++

docs/en/02-types/14-accessibility.md | 90 ++++++

docs/en/02-types/15-compatibility.md | 32 ++

docs/en/03-admin/00-intro.md | 9 +

docs/en/03-admin/01-plan.md | 266 +++++++++++++++

docs/en/03-admin/01-priorizacao.md | 105 ++++++

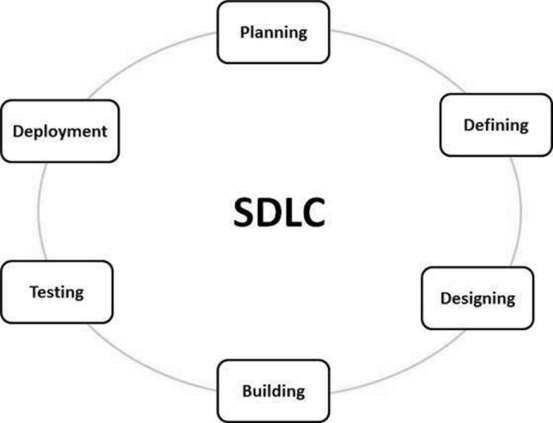

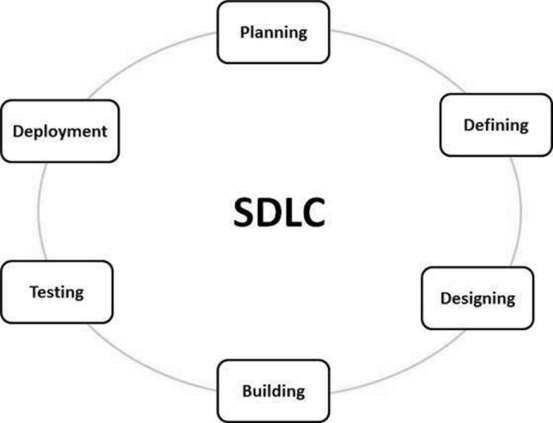

docs/en/03-admin/02-sldc.md | 105 ++++++

docs/en/03-admin/03-agile.md | 46 +++

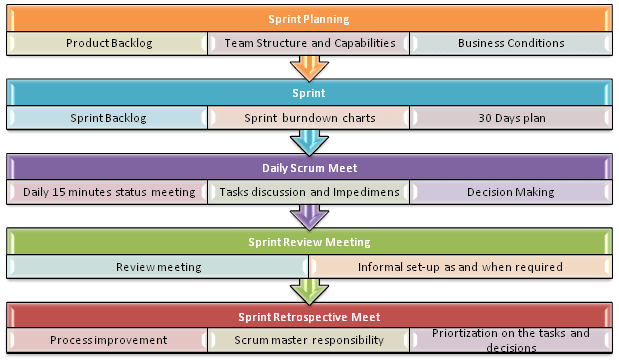

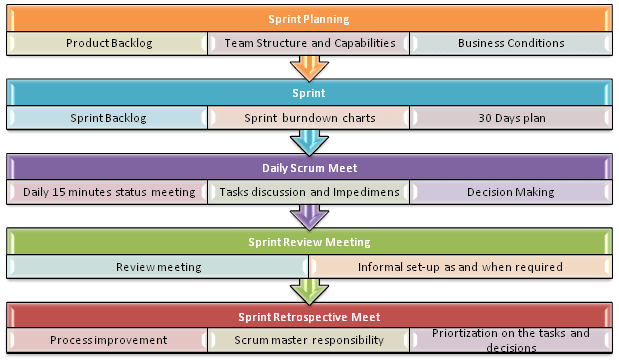

docs/en/03-admin/04-scrum.md | 108 +++++++

docs/en/03-admin/05-kanban.md | 101 ++++++

docs/en/03-admin/06-waterfall.md | 51 +++

docs/en/03-admin/07-v-model.md | 41 +++

docs/en/03-admin/08-report.md | 110 +++++++

docs/en/03-admin/09-verificacao.md | 129 ++++++++

docs/en/04-execucao/00-intro.md | 232 +++++++++++++

docs/en/04-execucao/01-manual.md | 65 ++++

docs/en/04-execucao/02-automatizado.md | 213 ++++++++++++

42 files changed, 3638 insertions(+)

create mode 100644 docs/en/00-foundation/00-intro.md

create mode 100644 docs/en/00-foundation/01-tradicional-vs-agile.md

create mode 100644 docs/en/00-foundation/02-interaction.md

create mode 100644 docs/en/00-foundation/03-tools.md

create mode 100644 docs/en/00-foundation/04-artifacts.md

create mode 100644 docs/en/00-foundation/05-identify.md

create mode 100644 docs/en/00-foundation/06-cases-report-incident.md

create mode 100644 docs/en/00-foundation/07-questions.md

create mode 100644 docs/en/01-approachs/00-intro.md

create mode 100644 docs/en/01-approachs/01-white-box.md

create mode 100644 docs/en/01-approachs/02-black-box.md

create mode 100644 docs/en/01-approachs/03-gray-box.md

create mode 100644 docs/en/02-types/00-intro.md

create mode 100644 docs/en/02-types/01-functional.md

create mode 100644 docs/en/02-types/02-uat.md

create mode 100644 docs/en/02-types/03-exploratory.md

create mode 100644 docs/en/02-types/04-sanity.md

create mode 100644 docs/en/02-types/05-regression.md

create mode 100644 docs/en/02-types/06-unit.md

create mode 100644 docs/en/02-types/07-smoke.md

create mode 100644 docs/en/02-types/08-integration.md

create mode 100644 docs/en/02-types/09-non-functional.md

create mode 100644 docs/en/02-types/10-load.md

create mode 100644 docs/en/02-types/11-performance.md

create mode 100644 docs/en/02-types/12-stress.md

create mode 100644 docs/en/02-types/13-pentest.md

create mode 100644 docs/en/02-types/14-accessibility.md

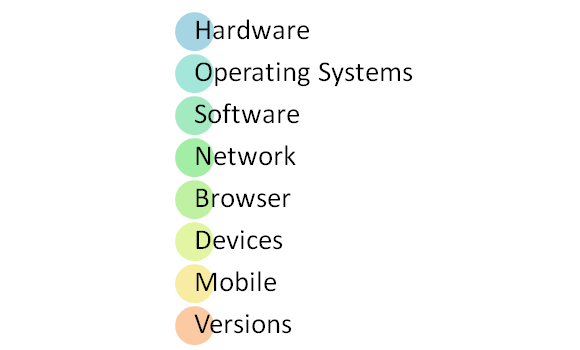

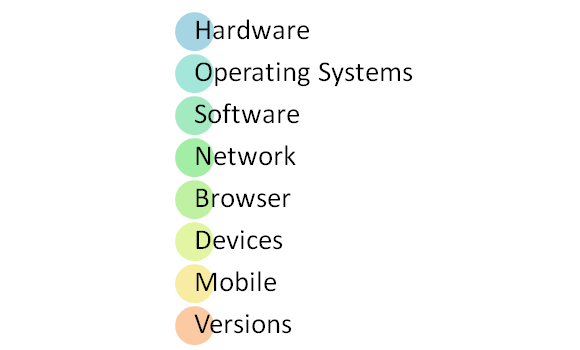

create mode 100644 docs/en/02-types/15-compatibility.md

create mode 100644 docs/en/03-admin/00-intro.md

create mode 100644 docs/en/03-admin/01-plan.md

create mode 100644 docs/en/03-admin/01-priorizacao.md

create mode 100644 docs/en/03-admin/02-sldc.md

create mode 100644 docs/en/03-admin/03-agile.md

create mode 100644 docs/en/03-admin/04-scrum.md

create mode 100644 docs/en/03-admin/05-kanban.md

create mode 100644 docs/en/03-admin/06-waterfall.md

create mode 100644 docs/en/03-admin/07-v-model.md

create mode 100644 docs/en/03-admin/08-report.md

create mode 100644 docs/en/03-admin/09-verificacao.md

create mode 100644 docs/en/04-execucao/00-intro.md

create mode 100644 docs/en/04-execucao/01-manual.md

create mode 100644 docs/en/04-execucao/02-automatizado.md

diff --git a/docs/en/00-foundation/00-intro.md b/docs/en/00-foundation/00-intro.md

new file mode 100644

index 0000000..e331d8c

--- /dev/null

+++ b/docs/en/00-foundation/00-intro.md

@@ -0,0 +1,62 @@

+# **Fundamentos do Teste de Software**

+

+Quality Assurance (QA) also known as QA Tests is an activity that guarantees the best possible quality for the product provided by a company to the final consumer

+

+The QA test in a software involves the testing of:

+

+- Performance

+- Adaptability

+- Functionality

+

+However, software quality assurance extends beyond the quality of the software itself. The activity also encompasses the quality of the **process**:

+

+

+- Development

+- Testing

+- Deployment

+

+# Quality Assurance (QA) in Software Development

+

+**Quality Assurance (QA)** focuses on the development cycle, which includes software requirements management, design, coding, testing, and release.

+

+Let's understand the fundamentals of software testing and how to apply them in our daily lives.

+

+## What is Quality?

+

+Quality can be simply defined as *"fit for use or function"*. The idea is to meet customers' needs and expectations regarding functionality, design, reliability, durability, and product price.

+

+## What is Assurance?

+

+Assurance is nothing more than a positive statement about a product or service that conveys confidence. It is the assurance that a product or service provides, indicating that it will function exactly as intended.

+

+Assurance ensures that it will work without any problems according to expectations and requirements.

+

+## Quality Assurance in Software Testing

+

+**Quality Assurance in testing** is defined as a procedure to ensure the quality of software products or services provided to customers by a company.

+

+QA focuses on improving the **software development process**, making it efficient and effective according to the defined quality parameters for software products.

+

+## *Error, Defect, and Failure*

+

+- **Error:** Human action that produces incorrect results.

+- **Defect:** Manifestation of the error in the software, also known as a *bug*.

+- **Failure:** Undesirable difference between observed and expected behavior (defect found).

+

+A person makes an **error**, which creates a **defect in the software**, which may or may not cause a **failure** in operation.

+

+## Testing Mindset

+

+As a QA engineer, your job is to look for failure points in a product, whatever it may be, and report them so they can be fixed, ensuring the highest quality product.

+

+To perform your function successfully, it's necessary to have the right mindset:

+

+- **Think as destructively and creatively as possible**

+

+**Important points:**

+

+1. Know the product you are testing.

+2. Don't be afraid to think outside the box while testing it.

+3. Don't be afraid to use it in the most incorrect way possible.

+4. The software is guilty until proven innocent.

+5. QA is responsible for proving the software is guilty.

\ No newline at end of file

diff --git a/docs/en/00-foundation/01-tradicional-vs-agile.md b/docs/en/00-foundation/01-tradicional-vs-agile.md

new file mode 100644

index 0000000..f22064f

--- /dev/null

+++ b/docs/en/00-foundation/01-tradicional-vs-agile.md

@@ -0,0 +1,32 @@

+# **Traditional and Agile Testing**

+

+In testing techniques, there are two types of tests: traditional and agile.

+

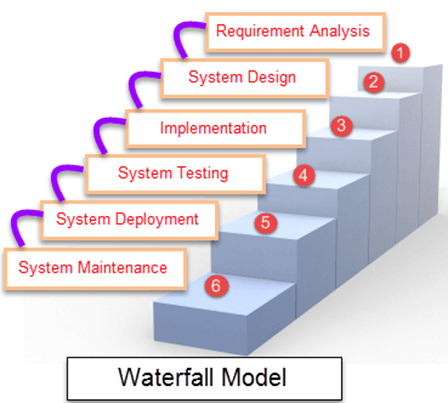

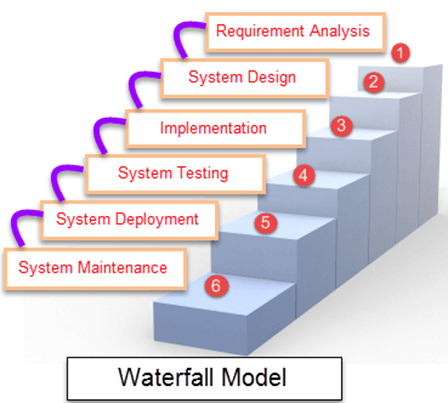

+Traditional tests are based on a waterfall model lifecycle, where testing is conducted after software construction, with a focus on finding defects.

+

+On the other hand, agile tests are based on an iterative and incremental lifecycle model, where testing occurs during software construction, focusing on defect prevention.

+

+## *7 Principles of Traditional Testing*

+

+1. Testing demonstrates the presence of defects; however, it does not guarantee their absence.

+2. Exhaustive testing is impossible: Consider application risks and priorities, selecting possible values to provide maximum test coverage.

+3. Testing should start as early as possible; errors found later cost more to fix.

+4. Clustering of defects.

+5. Pesticide Paradox.

+6. Testing is context-dependent.

+7. The fallacy of absence of errors.

+

+## *Testing in Agile Methodology*

+

+The focus of Agile QA is on:

+

+- Bug prevention, identifying issues early to reduce costs and efforts.

+- Ensuring clear customer expectations.

+- Embracing new ideas.

+- The Tester is part of a team.

+- Quality is the team's responsibility.

+- Testing is an integral part of the software development process.

+

+Traditional QA focuses on finding defects, figuring out ways to break the software.

+

+Agile QA aims to prevent errors, identifying bugs in the early stages to optimize application construction, avoiding rework, and minimizing risks.

diff --git a/docs/en/00-foundation/02-interaction.md b/docs/en/00-foundation/02-interaction.md

new file mode 100644

index 0000000..ae3e697

--- /dev/null

+++ b/docs/en/00-foundation/02-interaction.md

@@ -0,0 +1,18 @@

+# **Interaction with the Team**

+

+- Agile Principles

+

+1. Face-to-face Communication: The most effective communication method is in person. Unlike the traditional model where the tester had limited access to other team members, here, developers and testers work side by side.

+2. Continuous Feedback: Working in sprints involves constant testing, providing immediate and progressive feedback to the team.

+3. Continuous Improvement: Both in processes and people, values of transparency, professional development.

+4. Have Courage

+5. Deliver Value to the Customer: Testers need to be close to the customer, understand their needs, and translate them into business-focused test scenarios.

+6. Keep it Simple: The nature of testing is to validate various aspects, but simplification and prioritization based on customer needs are necessary. Use lighter tools to optimize the development process.

+7. Respond to Changes: Adaptability to new scenarios and conditions that may occur during sprints, learning new skills and attitudes to become adaptable.

+8. Self-Organization: Agile teams self-organize to solve a problem in the best way, considering each team member's skills. This dynamic emerges from the team itself, requiring autonomy and collaboration with the team's purpose.

+9. People Focus: Agile methodology is more about people, the human factor, than methodological and bureaucratic factors. Apply all other principles and stay close to other team members for collaboration.

+10. Have Fun

+

+In this context, the tester plays an active and fundamental role in the product development process, from understanding business rules to delivering the complete product.

+

+They must add value by being a quality reference, serving the team and the customer, using their critical and analytical skills to find solutions to the team's problems.

diff --git a/docs/en/00-foundation/03-tools.md b/docs/en/00-foundation/03-tools.md

new file mode 100644

index 0000000..7751eff

--- /dev/null

+++ b/docs/en/00-foundation/03-tools.md

@@ -0,0 +1,39 @@

+# **Tools and Their Objectives**

+

+The main tools used in the process are subdivided into categories, according to the objective of each one.

+

+## **Categories of Tools**

+

+- **Project Management and Version Control Tools:**

+

+Used throughout the development process, from defining requirements and versioning them for staging, to project versioning for secure and risk-free implementation.

+

+Version control is applied to create stable releases for client delivery, while unvalidated development is restricted to test branches. This ensures there is always a stable, bug-free, and validated version in case an implemented feature breaks the code.

+

+### **Test and Defect Management Tools**

+

+- **Test Management:**

+ TestLink allows the creation of test cases and manages their execution, helping identify failed or successful tests. It also assists in assigning tests among team members and supervising the execution.

+

+- **Defect Management:**

+ Enables describing the found flaw, assigning severity, work allocation among team members, development tracking, separation by status, inclusion of test evidence, etc.

+

+### **Test Automation Tools**

+

+Test automation tools are used for executing repetitive tests that do not require human intervention, such as interface tests, integration tests, performance tests, security tests, regression tests, etc. It is a broad concept, varying between programming languages and different methodologies for automating manual tests.

+

+### **Performance Testing**

+

+Some performance testing tools include:

+

+- **JMeter:** Allows the creation of test scripts and simulation of various users, monitoring response time, service errors, and providing multiple reports.

+

+- **Gatling:** Monitors the application continuously and alerts upon detecting errors and slowdowns.

+

+- **LoadComplete:** Combines both functions by allowing script creation and continuous performance monitoring.

+

+- **BlazeMeter:** Enables the creation of test scripts and user simulation from various servers worldwide.

+

+### **Supporting Tools**

+

+May or may not be used; they formalize the process, performing similar functions as management tools.

diff --git a/docs/en/00-foundation/04-artifacts.md b/docs/en/00-foundation/04-artifacts.md

new file mode 100644

index 0000000..89710ac

--- /dev/null

+++ b/docs/en/00-foundation/04-artifacts.md

@@ -0,0 +1,36 @@

+# **Artifact Review**

+

+*Artifacts*: Types of tangible subproducts produced during software development. All the involved documentation such as use cases, requirements, and documentation describing the design and architecture.

+

+The inspection process involves planning, individuals reviewing each artifact, meetings for discussions and record-keeping, passing defects back to the author, and an overall assessment regarding the need for a new inspection based on changes during the process.

+

+## *Definition of Concepts*

+

+The term defect is often used generically, but it's essential to understand that the interpretation depends on the usage context. Defects found through inspection relate to deficiencies in the reviewed artifact, software faults described in IEEE 830, 1998.

+

+IEEE defines quality attributes that a requirements document must have; the lack of any of these attributes characterizes a defect:

+

+- Omissions 1-5:

+ - 1: Important requirement related to functionality, performance, external interface.

+ - 2: Software response to all possible input data situations.

+ - 3: Lack of sections in requirement specifications.

+ - 4: Absence of references like figures, tables, or diagrams; visual representation is common when describing a use case or software specification.

+ - 5: Lack of definition of unit measurement terms; in a field, we need to know how many characters it supports, input of text, and a series of components that need unit measurement definition, like a numeral.

+

+- Ambiguity: A requirement with multiple meanings in a term for a specific context, making it challenging to understand functionality, leaving room for defects.

+

+- Inconsistency: More than one conflicting requirement, conflicting instructions for the same context.

+

+- Incorrect Fact: Requirement describing a fact not true considering established system conditions. Asks for A, returns B.

+

+- Extraneous Information: Information provided in the requirement that is unnecessary or won't be used; inefficient description, increasing documentation and opening room for conflicting interpretations.

+

+- Others: Various, like placing a requirement in the wrong section of the document, applying a rule in the wrong place, for example.

+

+These classes can be further subdivided into more specific classifications depending on the need.

+

+## *Benefits of Applying Software Inspections*

+

+Inspections find errors early in the process, aiming to prevent rework in subsequent cycles, as costs and time exponentially increase throughout the development cycle.

+

+This promotes increased productivity in the team, generating more understandable artifacts, facilitating inspection, and benefiting subsequent phases of the cycle, such as the maintenance phase of the documentation.

diff --git a/docs/en/00-foundation/05-identify.md b/docs/en/00-foundation/05-identify.md

new file mode 100644

index 0000000..a758c22

--- /dev/null

+++ b/docs/en/00-foundation/05-identify.md

@@ -0,0 +1,41 @@

+# How to Identify What to Test

+

+During the testing process, it's necessary to identify what needs to be tested. To do this, understanding what a test is and how it's conducted is crucial.

+

+## The 3 Main Ways to Document a Test

+

+Let's understand the 3 ways to document a test so that we can identify what needs to be tested.

+

+### Test Scripts

+

+The most detailed way to document a test, scripts typically detail step-by-step actions and necessary data to run the test. It often includes steps to understand how the user interacts, what actions to perform, and in what order, including specific outcomes for each step, such as verifying changes.

+For example, the action might be clicking button X, and the result is a window closing. At the start of a project, the tester might not have an in-depth understanding of the function. Scripts assist in the smooth development of the process and understanding the system. However, projects often undergo changes, with pages redesigned, new features added, etc., so scripts must be regularly updated. The drawback here is that time spent updating the script could be invested in executing more tests. Moreover, scripts are designed to test very specific and repetitive actions, leaving room for bugs outside these predefined paths to go undetected, requiring constant evolution.

+

+### Test Cases

+

+The second most detailed way, test cases describe a specific idea to be tested without detailing the exact steps to be executed. For example, testing if a discount code can be applied to a discounted product. This doesn't describe which codes will be used, allowing different approaches to find the result. It provides greater decision flexibility to the tester to complete the test, benefiting experienced testers with a good understanding of the system's nature and functions. However, the absence of this familiarity and experience allows bugs to go unnoticed.

+

+### Test Scenarios

+

+The least detailed documentation, describing the goal the user might achieve when using the program. For instance, testing if the user can log out of the program when closing it. Various techniques are needed to properly validate and test the function, as scenarios provide minimal specification. Testers have ample flexibility in developing the test. This flexibility offers the same pros and cons as seen in test cases, being liberating for experienced testers and nearly impossible for novices.

+

+A combination of these modalities, often used simultaneously, can be employed, divided among the team based on their different skills and competencies within the project's specific context.

+

+## How to Identify What to Test

+

+Let's understand the different ways to test.

+

+### Documentation-Based Testing

+

+When conducting any test, the most up-to-date documentation should be requested, such as use cases, business rules, and any relevant documentation.

+

+It's crucial to start, finish, and report test cases continuously once the documentation is available, preventing forgetfulness and future rework.

+

+### Testing Techniques

+

+Testing everything is impossible, so applying techniques is essential to cover as much of the system as possible in the shortest time.

+

+- **Soft Skills**

+- **Exploratory Curiosity**

+- **Active Listening:** Not all information is in documents; sometimes, it's in people.

+- **Team Player:** Actively contribute to the group to complete tasks, achieve goals, and collaborate for the common objective.

diff --git a/docs/en/00-foundation/06-cases-report-incident.md b/docs/en/00-foundation/06-cases-report-incident.md

new file mode 100644

index 0000000..e3418e9

--- /dev/null

+++ b/docs/en/00-foundation/06-cases-report-incident.md

@@ -0,0 +1,47 @@

+# Test Cases, Incident Reports, and Priorities

+

+When conducting tests, it's necessary to write test cases for organized and standardized testing. Incident reports should be documented to fix issues and ensure software quality. Additionally, prioritizing incidents is essential to fix them according to their importance.

+

+## How to Write Test Cases from a User Story

+

+- **What Are User Stories**

+

+An informal and general explanation of a software feature written from the perspective of the end user. Its purpose is to articulate how a software feature can deliver value to the customer. They are not system requirements but are key components in development that emphasize end users, using non-technical language to provide context to the development team, instructing them on what they are building and what value it will generate for the user.

+

+They enable a user-centered structure, promoting collaboration, creativity, and product quality. They articulate how a single task can offer specific value to the customer.

+

+They are written in a few sentences with simple language that outlines the desired result. Requirements are added later once the team agrees on the user stories.

+

+### Example of a User Story

+

+**As a** customer

+**I want** various payment methods to be available

+**So that** I can pay for my order.

+

+## Specification of Test Cases

+

+How is a test case written?

+

+- **Title:** It should be concise, simple, and self-explanatory, providing information so the analyst knows the validation the test aims for (Validate User Registration, Order Placement, etc.).

+- **Detailed Objective:** Describe what will be executed, providing an overview of the test to be performed. For example, "Check if file upload with allowed extensions is possible," "Verify if the purchase order is sent with information on asset, quantity, price, etc."

+- **Preconditions Necessary for Execution:** Prevents necessary information from being missing, such as not specifying that the user must be registered to perform the test. These are fundamental elements for the test to be executed correctly, such as the need for the user to have registered a note previously to test the query. The absence of preconditions will result in a flawed and inefficient test.

+- **Defined Steps:** Describe all actions the analyst must follow during execution until reaching the expected result. "Access X functionality," "Click on Y button," "Fill out the presented form," "Check if a blank form is displayed."

+- **Expected Results:** Describes the expected system behavior after executing the steps. "Valid," "Displays," "Recovers," "Returns." It should be direct and clear to avoid false positives. "System displays an editing screen with filled fields," "The order is sent and results in the informed price," "Registration is saved in the database."

+

+The case should be self-sufficient, including all necessary information for execution within its body. It should be concise, optimizing execution time, and should have as few steps as possible, facilitating the understanding of the required stages.

+

+It's also necessary to include both valid and unexpected inputs, as well as valid and expected inputs.

+

+## Bug Classification: Severity and Priority

+

+- **Severity:** Defines the degree or intensity of a defect concerning its impact on the software and its operation.

+ - **S1 - Critical/Showstopper:** Testing blockage or functionality that causes the application to crash or affects major use cases of key functionalities, security issues, severe data loss. Blockages that prevent testing other functions.

+ - **S2 - Major:** Problems related to unexpected information, unwanted defects, unusual input that causes irreversible effects, etc. Navigation is possible but generates significant errors in function.

+ - **S3 - Moderate:** Functionality does not meet certain acceptance criteria, such as error and success messages not displayed.

+ - **S4 - Minor:** Has little impact, interface errors, typos, misordered columns, design flaws.

+

+- **Priority:** Bugs viewed from a business perspective, indicating which ones should be fixed first based on demand and current context.

+ - **P1 - Critical:** Must be fixed immediately. Severity 1, performance errors, graphical interface affecting the user.

+ - **P2 - High:** Functionality is not usable as it should be due to code errors.

+ - **P3 - Medium:** Problems that can be evaluated by the developer and the tester for a later cycle depending on available resources.

+ - **P4 - Low:** Text errors, minor user experience and interface improvements.

diff --git a/docs/en/00-foundation/07-questions.md b/docs/en/00-foundation/07-questions.md

new file mode 100644

index 0000000..bc9ff8e

--- /dev/null

+++ b/docs/en/00-foundation/07-questions.md

@@ -0,0 +1,306 @@

+# Questions and Answers

+

+Let's review the concepts learned so far and answer some questions.

+

+## *1) What are the phases involved in the software testing life cycle?*

+

+- Test Planning: Strategy to be applied in testing.

+- Test Case Development: Defining and developing test cases.

+- Environment Setup: Configuring the necessary software and hardware for testing.

+- Execution: Running the code and comparing expected results with actual results.

+- Closure: Evaluation of completion criteria based on test coverage, quality, critical business objectives, etc.

+

+## *2) What are the different types of testing?*

+

+- Black Box Testing: Based on requirements and specifications, without an internal view of software functionality, from a user perspective.

+- White Box Testing: Based on internal structure, architecture, and source code, used to test system units.

+- Gray Box Testing: Software debugging, tester has limited knowledge of internal functioning, mixed approach.

+

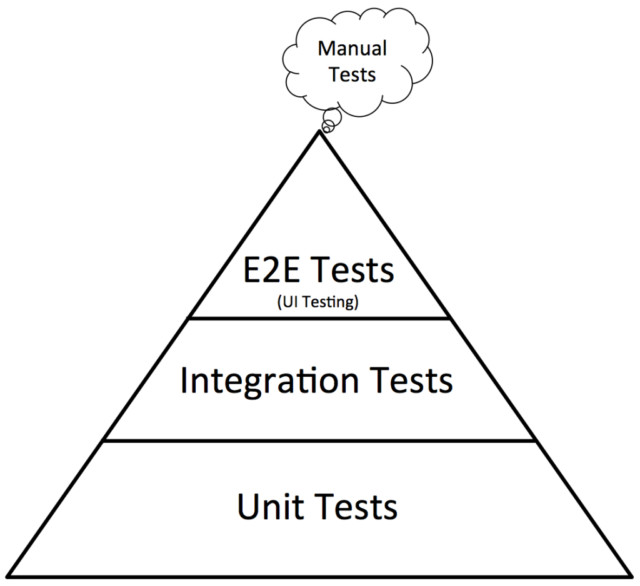

+## *3) What are the different levels of testing?*

+

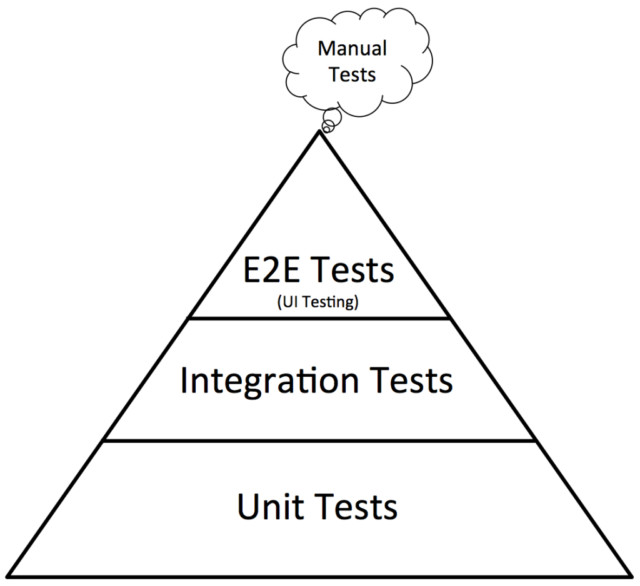

+- Unit Testing: Validates individual parts of the code.

+- Integration Testing: Validates the interaction of individual project parts and their interaction with external interfaces.

+- System Testing: Functional, actually uses the system.

+- Acceptance Testing: With the user, system acceptance.

+

+## *4) Explain the bug life cycle or defect life cycle*

+

+- Defect Found (NEW)

+- Assign: Assign to a developer for correction.

+- Activity: Resolving the bug itself, reject or accept, return for further explanations, etc.

+- Testing: The fixed bug is tested again for validation. If it's not fixed, it returns to the activity phase.

+- Closed: Fixed, validated, closed.

+

+## *5) What is a test case?*

+

+It is a set of conditions and variables under which a tester will determine if a system under test meets the functional requirements correctly.

+

+## *6) What is the difference between functional and non-functional tests?*

+

+- Functional: **Performed before non-functional tests**, based on client requirements, describes what the product does.

+- Non-Functional: **Performed after functional tests**, based on client expectations, describes how the product works.

+

+## *7) What is Verification and Validation in Software Testing?*

+

+Verification - Static analysis technique, checks documentation, testing is done without code execution (review, inspection, step-by-step testing).

+

+Validation - Dynamic analysis technique where testing is done by executing the code (non-functional and functional testing techniques).

+

+## *8) What is usability testing?*

+

+Testing methodology where the end user is asked to use the software to check ease of use, perception, system performance, etc. A precise way to understand the customer's perspective, using prototypes, mocks, etc.

+

+## *9) What is coverage, and what are the different coverage techniques?*

+

+A parameter to describe how much source code is tested.

+

+- Statement Coverage: Ensures that each line of code was executed and tested.

+- Decision Coverage: Ensures that all true and false paths were executed and tested.

+- Path Coverage: Ensures that all possible routes through a specific part of the code were executed and tested.

+

+## *10) A defect that could have been removed during the initial stage is removed at a later stage. How does this affect cost?*

+

+Defects should be removed as early as possible because postponing removal increases costs exponentially. Early-phase removal is cheaper and simpler.

+

+## *11) What is regression and confirmation testing?*

+

+- Regression: Confirms that a recent code change does not adversely affect existing features.

+- Confirmation: When a test fails due to a defect, it is reported, a new version of the corrected software is sent, and the test is re-run. This is confirmation of the correction.

+

+## *12) What is the basis for estimating your project?*

+

+To estimate a project, you should:

+

+- Break down the entire project into smaller tasks.

+- Assign each task to team members.

+- Estimate the effort required to complete each task.

+- Validate the estimation.

+

+## *13) Which test cases are written first: white box or black box?*

+

+Usually, **black box test cases** are written first.

+

+Since these only require requirements and design documents or a project plan, these documents are readily available at the beginning of the project.

+

+White box tests cannot be executed in the initial project phase because they require a clearer understanding of the architecture, which is not available in the early stages. Therefore, they are generally written **after** black box tests.

+

+## *14) Mention the basic components of the defect report format*

+

+- Project Name

+- Module Name (if applicable)

+- Defect Detected In

+- Defect Detected By

+- Where the Defect Was Found

+- Defect ID and Name

+- Defect Snapshot (bug evidence)

+- Priority/Severity Status

+- Defect Resolved By

+- Defect Resolved On (date)

+

+## *15) What does the Cascade of Defects mean?*

+

+Cascading defects occur when one defect is caused by another defect, one defect adds to another.

+

+When a defect is present in any stage but goes unnoticed and unaddressed, it results in a significant increase in the number of defects.

+

+They are mostly detected during regression testing.

+

+## *16) What are the defect categories?*

+

+- Wrong: Indicates that requirements were implemented incorrectly, a deviation from the provided specification.

+- Missing: A variation from the specifications, an indication that a specification was not implemented, or a customer requirement was not noted correctly.

+- Extra: An attribute desired by the product's end user, not provided by the final customer. It is always a deviation from the specification but may be a desired attribute by the product's user.

+

+## *17) On what basis is the acceptance plan prepared?*

+

+- Requirement Document: Specifies what is required in the project from the customer's perspective.

+- Customer Input: May include discussions, informal conversations, emails, etc.

+- Project Plan: The project plan prepared by the project manager also serves as good input to finalize acceptance testing.

+

+## *18) Why is Selenium the preferred tool for automation testing?*

+

+Selenium is an open-source tool designed to automate web browser testing. Since Selenium is open source, there is no licensing cost, which is a significant advantage over other testing tools. Other reasons include:

+

+- Test scripts can be written in various programming languages: Java, Python, C#, PHP, Ruby, Perl, and more.

+- Tests can be conducted in various web browsers: Mozilla, IE, Chrome, Safari, or Opera.

+- It can be integrated with tools like TestNG and JUnit for test case management and report generation.

+- Integration with Maven, Jenkins, and Docker for continuous testing.

+

+## *19) What are the various components of Selenium?*

+

+- Selenium Integrated Development Environment (IDE)

+- Selenium Remote Control (RC)

+- Selenium WebDriver

+- Selenium Grid

+

+## *20) What are the different types of locators in Selenium?*

+

+A locator is an address that uniquely identifies a web element within a web page. To identify web elements accurately, Selenium offers different types of locators, including:

+

+- ID

+- Class Name

+- Name

+- Tag Name

+- Link Text

+- Partial Link Text

+- XPath

+- CSS Selector

+- DOM

+

+

+## *21) What is XPath?*

+

+XPath, also known as XML Path, is a language for querying XML documents. It is a crucial strategy for locating elements in Selenium automation. XPath comprises a path expression along with certain conditions. Here, you can easily write an XPath script/query to locate any element on a web page. XPath is designed to enable navigation of XML documents with the aim of selecting individual elements, attributes, or specific parts of an XML document for processing. It also produces reliable locators.

+

+

+## *22) What is the Difference Between Absolute and Relative Path?*

+

+- Absolute XPath:

+

+It is the direct way to locate an element, but the disadvantage of absolute XPath is that if there is any change made to the element's path, the XPath will fail. For example:

+

+ /html/body/div[1]/section/div[1]/div

+

+- Relative XPath:

+

+For relative XPath, the path starts in the middle of the HTML DOM structure. It begins with a double forward slash (//), which means it can search for the element anywhere on the web page. For example:

+

+ // input [@ id = 'ap_email']

+

+## *23) When Should I Use Selenium Grid?*

+

+Selenium Grid can be used to execute identical or different test scripts on multiple platforms and browsers simultaneously, enabling distributed test execution, testing across different environments, and saving execution time.

+

+## *24) How Do I Launch the Browser Using WebDriver?*

+

+The following syntax can be used to launch the browser:

+

+WebDriver driver = new FirefoxDriver()

+

+Driver WebDriver = new ChromeDriver()

+

+Driver WebDriver = new InternetExplorerDriver()

+

+## *25) Should Testing Be Done Only After the Completion of Development and Execution Phases?*

+

+Testing is always done after the development and execution phases. The earlier a defect is detected, the more cost-effective it is. For example, fixing a defect during maintenance is ten times more expensive than fixing it during execution.

+

+## *26) What Is the Relationship Between the Reality of the Environment and Testing Phases?*

+

+As testing phases progress, the reality of the environment becomes more crucial. For instance, during unit testing, you need the environment to be partially real, but in the acceptance phase, you must have a 100% real environment, or we can say it should be **the** real environment.

+

+## *27) What Is Random Testing?*

+

+Usually, in random testing, data is generated randomly, often using a tool. For example, the figure below demonstrates how randomly generated data is fed into the system.

+

+This data is generated using an automated tool or mechanism. With this random input, the system is then tested, and the results are observed.

+

+## *28) Which Test Cases Can Be Automated?*

+

+- Smoke Testing

+- Regression Testing

+- Complex Calculation Testing

+- Data-Driven Testing

+- Non-functional Testing

+

+## *29) Based on What Can You Measure the Success of Automation Tests?*

+

+- Defect Detection Rate

+- Automation Execution Time and Time Savings for Product Launch

+- Reduction in Labor and Other Costs

+

+## *30) How to Click on a Hyperlink Using linkText()?*

+ driver.findElement(By.linkText("Google")).click();

+

+This command locates the element using the link text and then clicks on it. This way, the user would be redirected to the corresponding page.

+

+## *31) What Is TestNG?*

+

+It is an advanced framework designed to leverage the benefits of developers and testers. It also has a built-in exception handling mechanism that allows the program to run without unexpectedly terminating.

+

+## *32) How to Set the Test Case Priority in TestNG*

+

+The code below helps you understand how to set the test case priority in TestNG:

+

+ ```java

+ package TestNG;

+ import org.testing.annotation.*;

+

+ public class SettingPriority {

+ @Test(priority=0)

+ public void method1() {}

+

+ @Test(priority=1)

+ public void method2() {}

+

+ @Test(priority=2)

+ public void method3() {}

+ }

+ ```

+

+Test execution sequence:

+

+ 1. Method1

+ 2. Method2

+ 3. Method3

+

+## *33) What Is Object Repository? How Can We Create an Object Repository in Selenium?*

+

+Object repository refers to the collection of web elements belonging to the Application Under Test (AUT) along with their locator values. In the context of Selenium, objects can be stored in an Excel spreadsheet that can be filled within the script whenever needed.

+

+## *40) How to Enter Text in a Text Box Using Selenium WebDriver?*

+

+Using the **sendKeys()** method, we can enter text into the text box.

+

+## *41) What Are the Different Deployment Strategies for End Users?*

+

+- Pilot

+- Gradual Rollout

+- Phased Implementation

+- Parallel Implementation

+

+## *42) Explain How You Can Find Broken Links on a Page Using Selenium WebDriver*

+

+Let's assume the interviewer presents 20 links on a web page, and we need to check which of these 20 links are working and which ones are broken.

+

+The solution is to send HTTP requests to all the links on the web page and analyze the response. Whenever you use the **driver.get()** method to navigate to a URL, it will respond with a status of 200-OK. This indicates that the link is working and was successfully retrieved. Any other status indicates that the link is broken.

+

+First, we have to use the anchor tags `` to identify the different hyperlinks on the web page.

+

+For each `` tag, we can use the 'href' attribute value to get the hyperlinks and then analyze the response received when used in the **driver.get()** method.

+

+## *43) Which Technique Should Be Considered in the Script If There Is No ID or Name of the Frame?*

+

+If the frame's name and ID are not available, we can use **frame by index**. For example, if there are 3 frames on a web page, and none of them have a frame name or ID, we can select them using a frame index attribute (zero-based).

+

+Each frame will have an index number, with the first one being "0", the second one "1", and the third one "2".

+

+ driver.switchTo().frame(int arg0);

+

+## *44) How to Take Screenshots in Selenium WebDriver?*

+

+You can capture screenshots using the **TakeScreenshot** function. With the help of the **getScreenshotAs()** method, you can save the captured screenshot.

+

+Example:

+

+ scrFile = ((TakeScreenshot)driver).getScreenshotAs(outputtype.FILE)

+

+## *45) Explain How You Would Log into Any Site if It Shows an Authentication Pop-Up for Username and Password?*

+

+If there is a login pop-up, we need to use the explicit command and check if the alert is actually present. The following code helps understand the use of the explicit command.

+

+ WebDriverWait wait = new WebDriverWait(driver, 10);

+ Alert alert = wait.until(ExpectedConditions.alertIsPresent());

+ alert.authenticateUsing(new UserAndPassword(**username**, **password**));

+

+## *46) How to Skip a Method or Code Block in TestNG?*

+

+To skip a specific test method or code, you can set the 'enabled' parameter in the test annotation to *false*.

+

+ @Test(enabled=false)

+

+## *47) Explain Briefly What the Below Code Snippet Indicates?*

+

+ WebElement sample = driver.findElement(By.xpath("//[contains(text(), 'data')]"));

+

+It defines a *sample* variable of type WebElement and uses an Xpath search to initialize it with a reference to an element containing the text value "data".

diff --git a/docs/en/01-approachs/00-intro.md b/docs/en/01-approachs/00-intro.md

new file mode 100644

index 0000000..4b29de5

--- /dev/null

+++ b/docs/en/01-approachs/00-intro.md

@@ -0,0 +1,32 @@

+# Testing Approaches

+

+Testing an application is a process that must be done with great care because it ensures that the software is working correctly and there are no defects that could harm the user. However, creating tests is not an easy task. There are two approaches that can be used to create tests, each with its advantages and disadvantages. They are:

+

+- Proactive: where the test design process starts as early as possible to find and fix errors before the build is created.

+- Reactive: an approach where testing does not start until after the design and development are complete.

+

+Given these two approaches, we can say that the proactive approach is the most recommended because it allows tests to be created before the code, enabling the developer to fix errors before the code is implemented. On the other hand, the reactive approach is more commonly used in projects with tight schedules as it allows development to be done first, followed by testing.

+

+## Black Box vs. White Box

+

+Testing approaches can be divided into two categories, **black-box** and **white-box**. The difference between them is that black-box focuses on the system's behavior, while white-box focuses on the internal structure of the code.

+

+### Black Box

+

+Black-box tests are the most commonly used because they are easier to implement and do not require knowledge of the programming language used. Moreover, they are easier to understand for non-technical individuals and can be implemented in different programming languages.

+

+Key aspects of black-box tests include:

+

+- Primary focus on validating **functional** business rules.

+- Provides abstraction to the code and focuses on the system's behavior.

+- Facilitates test communication between modules.

+

+### White Box

+

+White-box tests are more challenging to implement as they require knowledge of the programming language used. They are also harder to understand for a layman and are more difficult to implement in different programming languages.

+

+Some key aspects of white-box tests include:

+

+- Validates **internal** structure and functionality of code.

+- Knowledge of the programming language used is essential.

+- Does not facilitate test communication between modules.

diff --git a/docs/en/01-approachs/01-white-box.md b/docs/en/01-approachs/01-white-box.md

new file mode 100644

index 0000000..ff2cd88

--- /dev/null

+++ b/docs/en/01-approachs/01-white-box.md

@@ -0,0 +1,111 @@

+# **White Box Testing**

+

+Some of the key concepts defining white box testing are:

+

+- Involves testing the internal mechanisms of an application; the tester must be familiar with the programming language used in the application being tested.

+

+- Code is visible to testers.

+

+- Identifies areas of a program that have not been exercised by a set of tests.

+

+A technique where the internal structure, design, and code are tested to verify the input-output flow and improve design, usability, and security.

+

+Here, the code is visible to testers, also referred to as Transparent Box Testing, Open Box Testing, Glass Box Testing, etc.

+

+## Test Targets

+

+Some of the main targets of white box testing are:

+

+- Internal security vulnerabilities

+- Broken or poorly structured paths in the coding process

+- Flow of inputs specified by the code

+- Expected output

+- Functionality of conditional loops

+- Testing of each statement, object, and function individually

+

+## How to Perform White Box Testing?

+

+Let's go through the step-by-step process of performing white box testing:

+

+### 1. Understand the Code

+

+The first thing a tester will typically do is learn and understand the application's source code.

+Since White Box Testing involves testing the internal mechanisms of an application, the tester must be familiar with the programming language used in the application being tested.

+Additionally, the tester must be aware of coding best practices.

+Security is often a primary goal of software testing; the tester must locate security breaches and prevent attacks from hackers and users who can inject malicious code into the application.

+

+### 2. Create Test Cases and Execute Them

+

+The second basic step for white box testing involves testing the source code for proper flow and structure.

+

+One way to do this is by writing additional code to test the source code.

+

+The tester will develop small tests for each process or series of processes in the application; this method requires the tester to have an intimate knowledge of the code and is often done by the developer.

+

+Other methods include manual testing, trial and error, and the use of testing tools.

+

+#### Example of White Box Testing

+

+Consider a simple code example for white box testing:

+

+```c

+void printme(int a, int b) { // Printme is a function

+ int result = a + b;

+

+ if (result > 0)

+ print("Positive", result)

+ else

+ print("Negative", result)

+} // End of the source code

+```

+

+The goal of White Box Testing in software engineering is to verify all decision branches, loops, and statements in the code.

+

+### White Box Testing Techniques

+

+Most techniques involve Code Coverage analysis, which fills gaps in a Test Case.

+

+This identifies areas of a program that have not been exercised by a set of tests.

+

+Once gaps are identified, you create test cases to verify the untested parts of the code, enhancing the product's quality.

+

+Automated tools are available to apply Code Coverage analysis.

+

+### Forms of Test Coverage

+

+Below are some code coverage analysis techniques a tester can use:

+

+1. **Statement Coverage:** This technique requires that all possible code statements are tested at least once during the testing process.

+

+2. **Branch Coverage:** This technique checks all possible paths (if/else and other conditional loops) in an application.

+

+### Types of White Box Testing

+

+Let's look at how white box tests are categorized:

+

+#### **Unit Testing**

+

+Often the first type of test applied to a program.

+

+Unit testing is performed on each unit or block of the code during its development. It is essentially done by the developer, who develops a few lines of code, a single function, or an object and tests to ensure it works before moving forward.

+

+This type helps identify most bugs in the early stages of software development, being cheaper and faster to fix.

+

+#### **Memory Leak Testing**

+

+Memory leaks are the main causes of slow applications. A QA specialist experienced in detecting them is essential for applications running slowly.

+

+#### **Penetration Testing**

+

+In this test, the tester/dev has complete information about the source code, network details, IP addresses involved, and all server information where the application runs.

+The goal is to attack the code from various angles to expose security threats.

+

+### White Box Testing Tools

+

+Here are some white box testing tools:

+

+- [EclEmma](https://www.eclemma.org/download.html)

+- [NUnit](http://nunit.org/)

+- [PyUnit](https://www.guru99.com/python-unit-testing-guide.html)

+- [HTMLUnit](http://htmlunit.sourceforge.net/)

+- [CppUnit](https://sourceforge.net/projects/cppunit/)

diff --git a/docs/en/01-approachs/02-black-box.md b/docs/en/01-approachs/02-black-box.md

new file mode 100644

index 0000000..3110e75

--- /dev/null

+++ b/docs/en/01-approachs/02-black-box.md

@@ -0,0 +1,41 @@

+# Black Box Testing

+

+Black box testing aims to verify whether the system under scrutiny is functioning correctly, meaning it adheres to business rules and system specifications.

+

+Black box tests have the following characteristics:

+

+- Testing where the internal functionalities of the code are not accessible to the tester.

+- Done from the user's perspective.

+- Entirely focused on business rules and application specifications, also known as Behavioral Testing.

+

+## How to Apply Black Box Testing

+

+To apply black box testing, the tester must follow these steps:

+

+1. Initially, business rules and specifications are examined.

+2. The tester selects valid inputs (positive scenario testing) to check if the system processes them correctly. Invalid inputs (negative scenario testing) are also tested to verify if the system detects them.

+3. The tester determines the expected outputs for each of the selected inputs.

+4. The tester constructs test cases with the selected inputs.

+5. Test cases are executed.

+6. The tester compares actual outputs with ideal outputs.

+7. Defects, if any, are corrected and retested.

+

+### Types of Black Box Testing

+

+Black box tests can be classified as:

+

+- **Functional Testing:** Related to the business rules of a system; conducted by testers.

+

+- **Non-Functional Testing:** **Not related** to testing any specific feature but rather non-functional business rules like performance, scalability, and usability.

+

+- **Regression Testing:** This mode is applied after any fixes, upgrades, or maintenance in the code to verify if these changes have not affected features previously tested successfully.

+

+## Black Box Testing Techniques

+

+The following techniques are used to test a system:

+

+- **Equivalence Class Testing:** Used to minimize the number of possible test cases to an optimized level while maintaining reasonable coverage.

+

+- **Boundary Value Analysis:** Focuses on values at boundaries. This technique determines if a certain range of values is acceptable by the system or not, very useful for reducing the number of test cases. It is more appropriate for systems where an input falls within certain scopes.

+

+- **Decision Table Testing:** A decision table inserts causes and their effects into a matrix, with a unique combination in each column.

diff --git a/docs/en/01-approachs/03-gray-box.md b/docs/en/01-approachs/03-gray-box.md

new file mode 100644

index 0000000..7e7828f

--- /dev/null

+++ b/docs/en/01-approachs/03-gray-box.md

@@ -0,0 +1,61 @@

+# Gray Box Testing

+

+Gray box tests are a combination of white-box and black-box testing methods. They are used to test a product or application with partial knowledge of the application's internal structure. The purpose of this testing is to search for and identify defects caused due to improper application structure or usage.

+

+Some of the key characteristics of gray box testing are:

+

+- It is a combination of white-box methods (with complete code knowledge) and black-box methods (with no code knowledge).

+- System defects can be reduced or prevented by applying gray box testing.

+- It is more suitable for GUI, functional, security, web applications, etc.

+

+In this process, context-specific errors related to web systems are commonly identified. This improves test coverage by focusing on all layers of any complex system.

+

+In QA, gray box testing provides an opportunity to test both the front-end and back-end of an application.

+

+## Why Apply Gray Box Testing?

+

+Some of the benefits of applying gray box testing include:

+

+1. It provides the combined benefits of both other modalities.

+2. It combines input from developers and testers, enhancing the overall product quality.

+3. It reduces the overall cost throughout the functional and non-functional testing process.

+4. It provides developers enough time to fix defects.

+5. Testing is done from a user's perspective rather than a designer's viewpoint.

+

+## Gray Box Testing Strategy

+

+To perform gray box testing, the tester does not need access to the source code.

+

+A test is designed based on knowledge of algorithms, structures, architectures, internal states, or other high-level descriptions of program behavior.

+

+### Techniques Used for Testing

+

+The primary techniques used for gray box testing are:

+

+- **Matrix Testing:** This testing technique involves defining **all variables** that exist in a program.

+- **Regression Testing:** To check if the change in the **previous version** has regressed other aspects of the program in the **new version**. This will be done by testing strategies like retest everything, retest risky features, and retest within a firewall.

+- **Matrix or Action-Oriented Testing (OAT):** Provides maximum code coverage with a minimum number of test cases.

+- **Pattern Testing:** This technique is performed on historical data from the previous version's defects in the system. Unlike black-box testing, gray box testing operates by digging into the code and determining why the failure occurred.

+

+### Steps to Apply Gray Box Testing

+

+Let's look at the steps to apply gray box testing:

+

+1. Identify the **inputs**.

+2. Identify the **outputs**.

+3. Identify the main **paths**.

+4. Identify the **sub-functions**.

+5. Develop **inputs** for the **sub-functions**.

+6. Develop **outputs** for the **sub-functions**.

+7. Execute test cases for the **sub-functions**.

+8. Verify the **correct result** for the **sub-functions**.

+9. Repeat steps 4 & 8 for other **sub-functions**.

+10. Repeat steps 7 & 8 for other **sub-functions**.

+

+Note that gray box test cases may include:

+

+- GUI-related.

+- Security-related.

+- Database-related.

+- Browser-related.

+- Operating System-related.

diff --git a/docs/en/02-types/00-intro.md b/docs/en/02-types/00-intro.md

new file mode 100644

index 0000000..ce06cf6

--- /dev/null

+++ b/docs/en/02-types/00-intro.md

@@ -0,0 +1,7 @@

+# Testing Techniques

+

+Testing techniques are the methods applied to evaluate a system or component with the purpose of determining if it satisfies the business rules.

+

+This helps identify gaps, errors, or any elements that deviate from the acceptance criteria.

+

+These techniques ensure overall quality for the product or software, including performance, security, user experience, etc.

diff --git a/docs/en/02-types/01-functional.md b/docs/en/02-types/01-functional.md

new file mode 100644

index 0000000..c39c067

--- /dev/null

+++ b/docs/en/02-types/01-functional.md

@@ -0,0 +1,92 @@

+# Functional Testing Techniques

+

+Functional testing is a type of testing that validates the system against specifications and acceptance criteria. The purpose of this type of testing is to test each function of the software by providing appropriate input and verifying the output according to the functional requirements.

+

+Let's explore some of the key functional testing techniques.

+

+## Equivalence Partitioning (BVA)

+

+Equivalence partitioning is a testing technique based on requirements in the documentation.

+

+Executed through the black-box approach, it provides the tester with a clear understanding of test coverage based on requirements and specifications.

+

+It does not require knowledge of internal paths, structure, and implementation of the software under test and reduces the number of test cases to a manageable level. It is intuitively used by most testers.

+

+Partitioning divides user inputs into partitions or classes of equivalence, and then subdivides them into ranges of possible values, so that one of these values is elected as the basis for the tests. There are partitions for:

+

+- Valid values, which should be accepted by the system.

+- Invalid values, which should be rejected by the system.

+

+Consider a human resources system in a company that processes employee requests based on age. We have a business rule related to age stating that individuals under 16 years old cannot work, individuals between 16-60 years old are eligible for hire, and those who are 60 years old or older are not suitable for the job.

+

+Dividing these rules, we have:

+

+- Invalid partition: 0-15

+- Valid partition: 16-60

+- Invalid partition: 60-

+

+Equivalence partitioning guides us to choose a subset of tests that will find more defects than a randomly chosen set.

+

+When working with partitions, we observe a maxim that states:

+

+ "Any value within a partition is as good as any other."

+

+Therefore, values belonging to the same partition must be treated equally by the system, meaning they will produce the same result. Thus, any value within the equivalence class, in terms of testing, is equivalent to any other.

+

+To achieve satisfactory test coverage when implementing this technique, test cases must cover all existing partitions. In the example under analysis, we have identified 3 partitions.

+

+A test script for age validation in the hiring module would have 3 test cases:

+

+C1: Age = 5

+

+According to the rule, it should not work; the expected value is "Should not hire."

+

+C2: Age = 33

+

+According to the rule, it can work; the expected value is "Can hire."

+

+C3: Age = 65

+

+According to the rule, it should not work; the expected value is "Should not hire."

+

+It is understood that within the range of values 0-15, regardless of which one is selected within the invalid partition, it should not be accepted by the system. The same applies to the range of 16-60, multiple possibilities that result in acceptance in the system.

+

+It is not necessary to test all possible values; the coverage is sufficient when choosing one within each partition.

+

+## Boundary Value Analysis

+

+It assumes that the behavior at the edge of a partition is more likely to cause errors.

+

+In the example, with the boundary value technique, we would select the value 15, invalid according to the system, then we select 16, borderline, but it should yield a positive result.

+

+A good practice of combining techniques is to select a random value for each partition, test it, and then validate the boundary values within each partition.

+

+- Decision Table:

+

+A relevant method for documenting business rules to be followed by the system, created from the analysis of functional specifications and identification of business rules.

+

+The table contains trigger conditions, combinations of true or false for data entry, and results for each of the combinations. It is a way to express in a tabular form which set of actions should occur to arrive at an expected result.

+

+The main point of the table is the business rule, which defines the set of actions to be taken based on a set of conditions.

+

+In the example, if we know that from 0-15 should not work, in the table, we establish that

+

+0-15 Cannot

+

+16-60 Can

+

+This combination can/cannot, is a visual representation to assist in documenting the rules the system follows.

+

+## Transition between States

+

+It is based on the idea that a system can exhibit different behaviors depending on its current state or previous events. Creating a diagram allows the test to visualize the statuses, i.e., the transitions, data entry, and events that trigger actions.

+

+The technique helps identify possible invalid transactions because knowing what the system expects, when testing the combinations, we can discover faulty transactions.

+

+A person can be eligible to work and then become ineligible, invalid.

+

+### Techniques Based on Experience

+

+These are techniques where tests are derived from the skills and experience of the tester, the individual visualization capability of the professional, based on their past work, enabling them to find errors and faults that others may not discover.

+

+This topic is better explored in the article on [exploratory testing](test).

diff --git a/docs/en/02-types/02-uat.md b/docs/en/02-types/02-uat.md

new file mode 100644

index 0000000..172ec98

--- /dev/null

+++ b/docs/en/02-types/02-uat.md

@@ -0,0 +1,98 @@

+# User Acceptance Testing (UAT)

+

+User Acceptance Testing (UAT), often simply called acceptance testing, is a type of testing applied by the end user or the client to verify and accept the system before progressing the application to the production environment.

+

+User Acceptance Testing is performed at the end of the testing phase, after functional, integration, and system testing.

+

+## Purpose of UAT

+

+The primary purpose of UAT is to validate the flow from start to finish.

+

+It does not focus on cosmetic errors, typos, or system testing, and is conducted in a separate test environment with a setup similar to the production environment.

+

+**It is similar to black-box testing where two or more end-users are involved**.

+

+## Why is UAT Necessary?

+

+The need for this test arises once the software has passed integration, system, and unit testing, as developers might have built the software based on documented business rules under their own understanding, **leaving a chance that any further necessary changes during this phase might not have been efficiently communicated to them**.

+

+Therefore, to verify if the final product is acceptable to the customer/user, this test becomes necessary.

+

+### Prerequisites for UAT

+

+- Acceptance criteria must be available.

+- Application code must be completely developed.

+- Unit, integration, and system testing must have been completed.

+- No major issues in integration testing.

+- Only cosmetic errors are acceptable before UAT.

+- Regression testing must have been completed without major issues.

+- All reported bugs must have been fixed and retested before UAT.

+- Traceability matrix for all testing must be complete.

+- The UAT environment must be ready.

+- Testing Team must give the go-ahead for UAT.

+

+## How to Perform UAT

+

+UAT is done by the target audience of the system or software.

+

+It is usually done at the client's location, which is commonly known as **Beta Testing**.

+

+Once the entry criteria for UAT are satisfied, the following tasks need to be performed by the testers:

+

+1. Analysis of Business Rules.

+2. Creation of UAT Test Plan.

+3. Creation of UAT Test Cases.

+4. Preparation of Test Data (as it would be in Production).

+5. Execution of Test Cases.

+6. Cataloging the results.

+7. Confirming acceptance criteria.

+

+### 1. Analysis of Acceptance Rules

+

+One of the most crucial activities in UAT is to identify and develop test scenarios. These scenarios are derived from the following documents:

+

+- Project Plan

+- Use Cases

+- Process Flow Diagrams

+- Necessary Business Documentation

+- System Requirements Specifications

+

+### 2. Creation of UAT Test Plan

+

+The test plan defines the strategy that will be applied to verify and ensure that the application meets the acceptance conditions. It documents entry and exit criteria for UAT, the approach for scenarios and test cases, as well as the testing timeline.

+

+### 3. Identification of Test Cases

+

+Identification of scenarios will respect the business process and create clear test cases. The cases should sufficiently cover most of the UAT scenarios. Business use cases are inputs for creating test cases.

+

+### 4. Preparation of Test Data

+

+Using real-time data for UAT is recommended. The data should be scrambled for security and privacy reasons. Testers should be familiar with the database flow.

+

+### 5. Execute and Document Results

+

+Execute the tests and report any bugs, retest the bugs once they are fixed.

+

+### 6. Confirm Business Rules

+

+Business Analysts or UAT Testers need to provide a statement after testing. With this confirmation, the product is ready to proceed to Production. Deliverables for UAT are the Test Plan, UAT scenarios and test cases, results, and defect log.

+

+## UAT Exit Criteria

+

+Before proceeding to the production environment, the following must be considered:

+

+- No critical defects without fixes.

+- Business processes function satisfactorily.

+- Meeting for positive UAT declaration with stakeholders.

+

+## Best Practices

+

+- Prepare the UAT plan early in the project life cycle.

+- Prepare the checklist before UAT starts.

+- Conduct pre-UAT sessions during the system testing phase itself.

+- Clearly define UAT expectations and scope.

+- Test the business flow from start to end and avoid system tests.

+- Test the system or application with real-life applicable scenarios and data.

+- Think like a user unfamiliar with the system.

+- Perform Usability testing.

+- Conduct feedback sessions and meetings before proceeding to Production.

diff --git a/docs/en/02-types/03-exploratory.md b/docs/en/02-types/03-exploratory.md

new file mode 100644

index 0000000..d964bea

--- /dev/null

+++ b/docs/en/02-types/03-exploratory.md

@@ -0,0 +1,59 @@

+# Exploratory Testing

+

+Exploratory testing involves evaluating a product by learning about it through exploration and experimentation, including:

+

+- Questioning;

+- Study;

+- Modeling;

+- Observation;

+- Inference;

+

+Often described as simultaneous learning, test design, and execution, it focuses on discovery and relies on the individual tester's guidance to uncover potential defects not easily covered within the scope of other tests.

+

+## Why Use Exploratory Testing?

+

+Most software quality tests use a **structured** approach, with test cases defined based on metrics such as user history and software engineering parameters, ensuring adequate coverage from a technical perspective.

+

+What's lacking is coverage for extreme cases, which are checked during UAT and tested based on user personas. Exploratory Testing, on the other hand, is **random**, or unstructured by nature, and can reveal bugs that wouldn't be discovered in structured testing modes.

+

+Test execution is implemented without creating formal steps, making it a precursor to automation.

+

+It helps formalize discoveries and automate documentation. With the aid of visual feedback and collaborative testing tools, the entire team can participate in exploratory testing, enabling quick adaptation to changes and promoting an agile workflow.

+

+Moreover, testers can convert exploratory test sequences into functional test scripts, automating the process.

+

+Hence, exploratory testing speeds up documentation, facilitates unit tests, and helps create an instant feedback loop.

+

+## When Should You Use Exploratory Testing?

+

+It is suitable for specific scenarios, such as when someone needs to learn about a product or application quickly and provide rapid feedback. Exploratory testing helps assess quality from the user's perspective.

+

+In many software cycles, an initial iteration is necessary when teams don't have much time to structure tests; exploratory tests are quite useful in this scenario.

+

+Exploratory testing ensures no critical failure case goes unnoticed, guaranteeing quality. It also assists in the unit testing process, with testers documenting steps and using this information to test more broadly in subsequent sprints.

+

+It is especially useful when finding new test scenarios to enhance coverage.

+

+## When **Not** to Perform Exploratory Testing?

+

+Organizations should be able to strike a balance between exploratory and scripted testing. Exploratory tests alone cannot offer sufficient coverage; they are thus complementary to scripted tests in some cases.

+

+Especially in regulated or compliance-based testing, which requires scripted testing. In these cases, specific checklists and mandates need to be followed for legal reasons, making scripted testing preferable.

+

+An example is accessibility tests that follow legal protocols with defined standards needing approval.

+

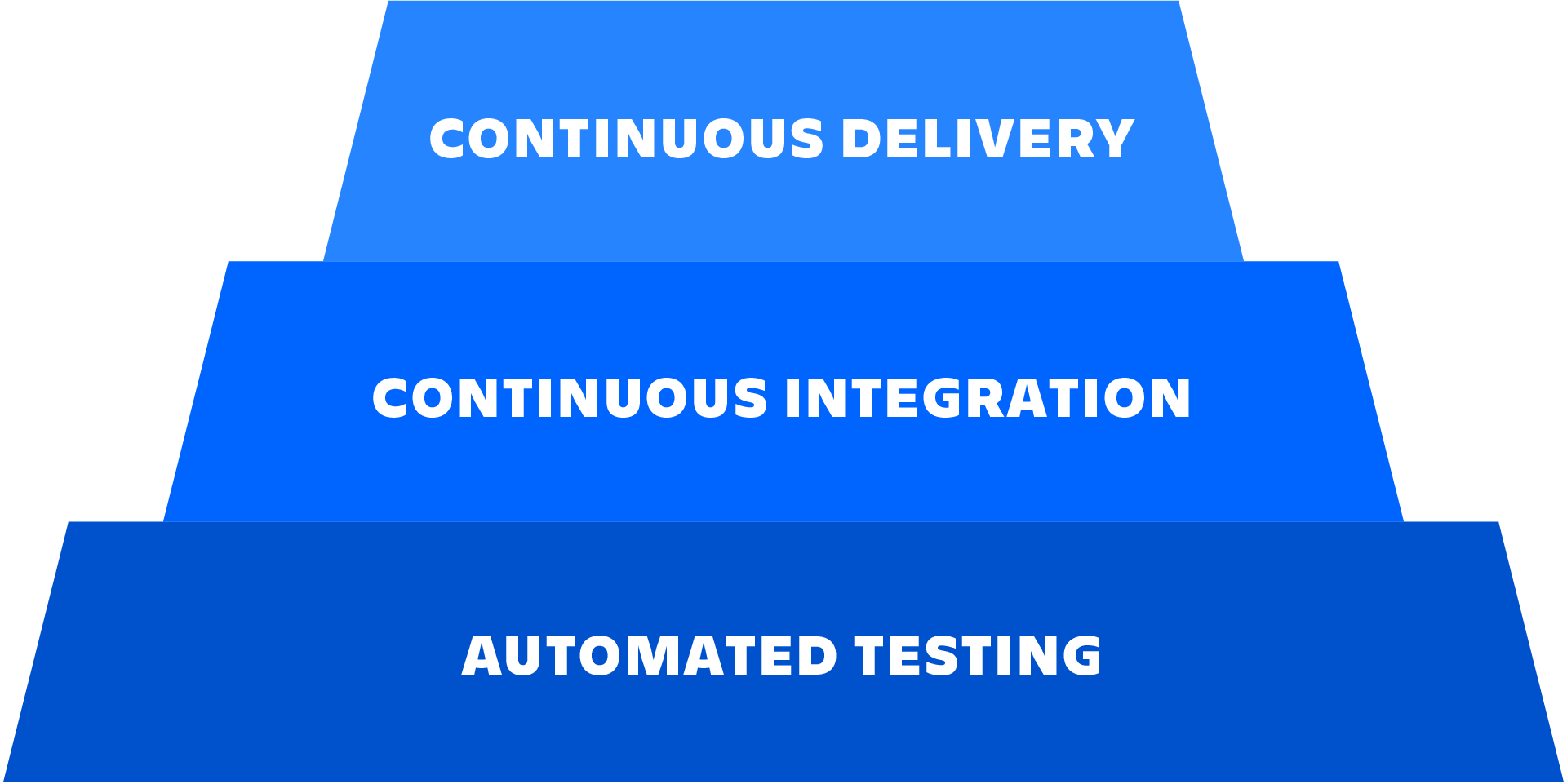

+## Importance of Exploratory Testing for CI/CD

+

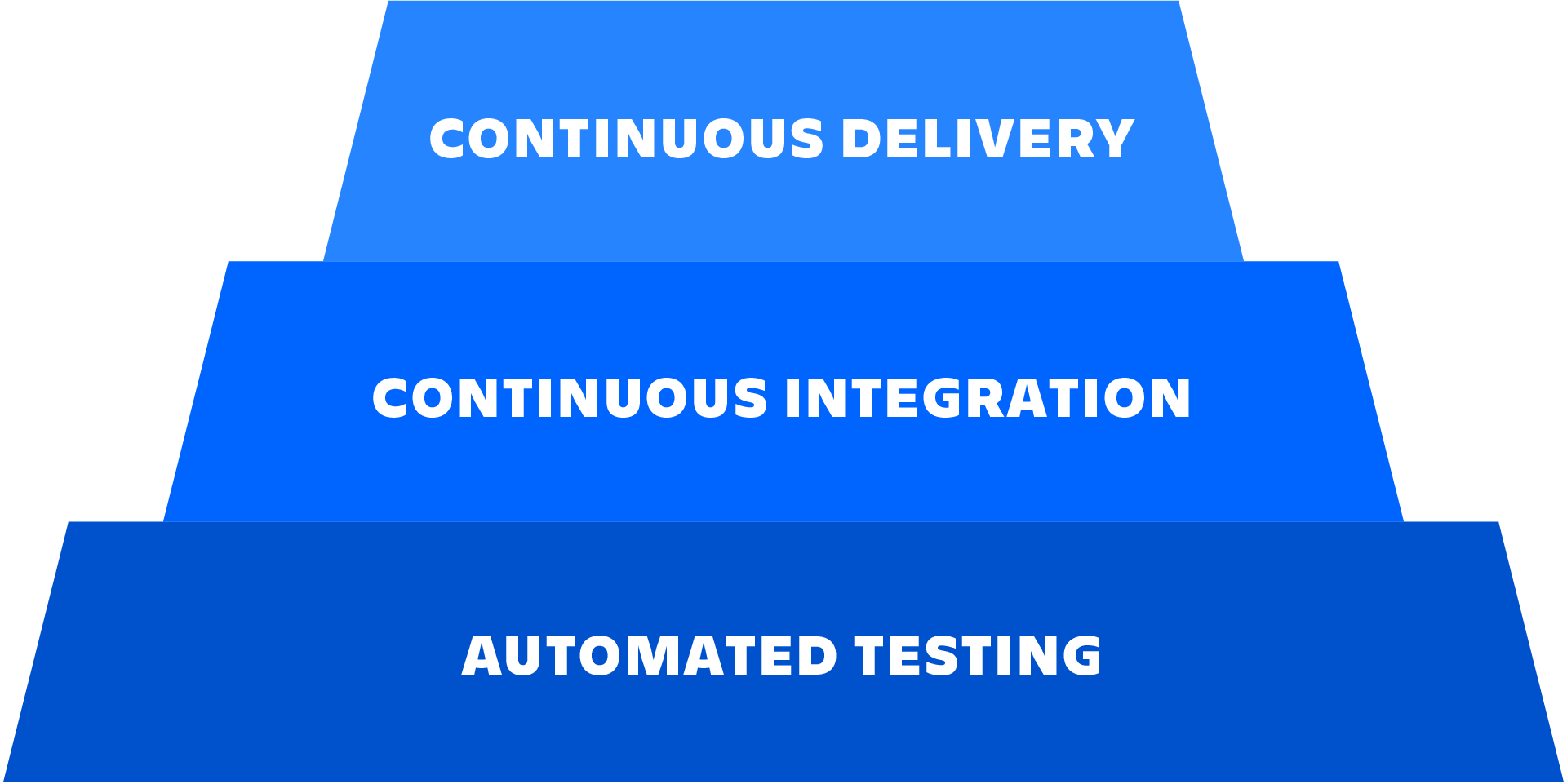

+*// CI/CD: Continuous Integration/Continuous Delivery, a method to deliver applications frequently to customers. //*

+

+Exploratory tests open testing to everyone, not just trained testers, making review faster and more efficient and allowing people beyond the traditional tester to participate.

+

+Exploratory tests **complement** QA team testing strategies, including a series of undocumented test sessions to find yet-to-be-discovered bugs.

+

+When combined with *automated tests* and other practices, they increase test coverage, discover extreme cases, and potentially add new features and improvements to the product.

+

+**Without structural rigidity, they encourage experimentation, creativity, and discovery within teams.**

+

+The almost instant nature of feedback helps bridge gaps between testers and developers, but most importantly, the results provide a user-oriented perspective and feedback for development teams.

+

+**The goal is to complement traditional tests and uncover hidden defects behind the traditional workflow.**

diff --git a/docs/en/02-types/04-sanity.md b/docs/en/02-types/04-sanity.md

new file mode 100644

index 0000000..157b39c

--- /dev/null

+++ b/docs/en/02-types/04-sanity.md

@@ -0,0 +1,60 @@

+# Sanity Testing

+

+Sanity testing is a type of testing performed after receiving a software build with minor changes in the code or functionality, **to ensure that bugs have been fixed and no new issues have been introduced.**

+

+The goal is to ensure that the proposed functionality works rudimentarily as expected.

+

+If it fails, the build is rejected to avoid the expenditure of time and resources involved in more rigorous testing.

+

+Sanity testing is a subset of regression testing and is applied to ensure that changes in the code work appropriately. It is a step to check whether the build can proceed to further testing or not.

+

+The focus of the team during sanity testing is to validate the application's functionality, not detailed testing.

+

+It is usually applied to a build where the production implementation is needed immediately, such as a critical bug fix.

+

+## Functionality of Sanity Testing

+

+The main objective is to determine that the changes or proposed functionality work as expected.

+

+If quality testing fails, the product is rejected by the QA team to save time and money.

+

+It is only applied after the product has passed the Smoke Test and the QA team has accepted it for further testing.

+

+## Examples of Sanity Testing

+

+In an e-commerce project, the main modules are the login page, the home page, and the user profile page.

+

+There is a defect in the login page where the password field accepts fewer than 4 alphanumeric characters, while the business rules state that this field should not be less than eight characters. Therefore, the defect is reported by QA for the developer to fix.

+

+The developer then fixes the issue and sends it back to the testing team for approval.

+

+QA checks whether the changes made are working or not.

+

+It is also determined whether this has an impact on other related functionalities. Assuming there is now a feature to update the password on the user profile screen, as part of the sanity test, the login page is also validated, as well as the profile page to ensure both work well with the addition of the new function.

+

+### Aspects of Sanity Testing

+

+Below are some aspects to consider when conducting sanity testing:

+

+1. Subset of Regression Testing: focuses on smaller sections of the application.

+2. May not have a script (occasionally).

+3. Not documented (occasionally).

+4. Specific and In-Depth: limited functionalities are thoroughly checked.

+5. Performed by testers;

+

+### Advantages of Sanity Testing

+

+- Helps quickly identify defects in the core functionality.

+- If defects are found during sanity testing, the project is rejected, saving time in running regression tests.

+- The testing technique is not as costly compared to other modalities.

+- Helps identify missing necessary objects.

+- Used to validate a small functionality of the application, whether it's working or not after a minor change.

+- Assists in scenarios where time to test the product, or perform the test, is limited.

+