New issue

Have a question about this project? Sign up for a free GitHub account to open an issue and contact its maintainers and the community.

By clicking “Sign up for GitHub”, you agree to our terms of service and privacy statement. We’ll occasionally send you account related emails.

Already on GitHub? Sign in to your account

[FR & EN] YouTube subtitles #796

Conversation

|

@Atcold I have made most of the changes. There are still 6 where I need your opinion. |

|

Awesome, thanks! |

|

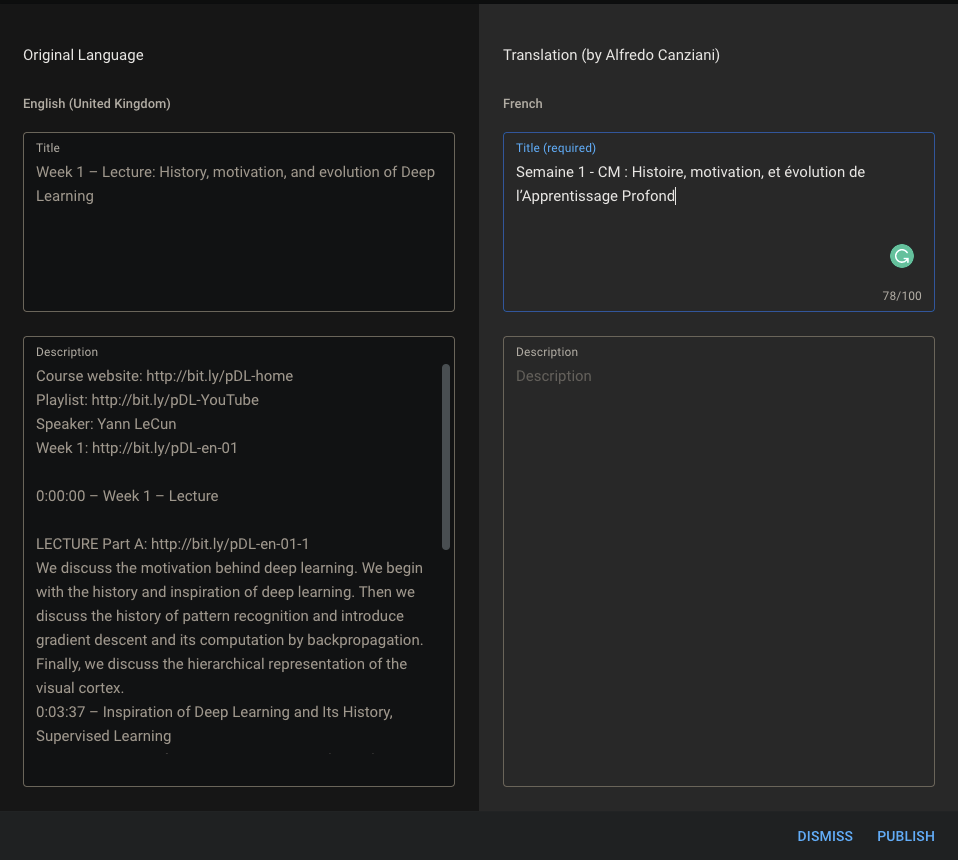

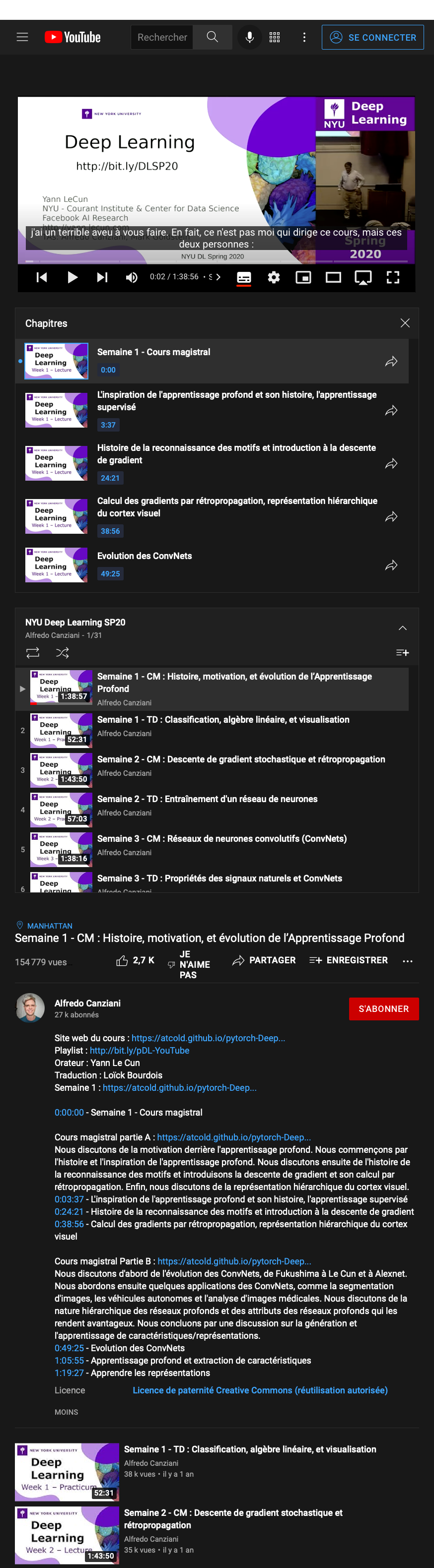

@Atcold If you merge the PR #797, it should be good for the subtitles. And I just thought that the titles of the videos were not translated into French. I'm not sure where to put this translation, so here it is: Semaine 1 - CM : Histoire, motivation, et évolution de l’Apprentissage Profond You can add them on YouTube but it would be nice to wait for the next PR adding the French V2 part 2 to promote it (I'd like to avoid having to answer a lot of basic questions while the FAQ we talked about on Discord will be added with the ultimate PR of the V2). |

|

@Atcold Here is the translation of the descriptions. Semaine 1 - CM : Histoire, motivation, et évolution de l’Apprentissage Profond Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 1 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week01/01-1/ Cours magistral Partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week01/01-2/ Semaine 1 - TD : Classification, algèbre linéaire, et visualisation Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 1 - Travaux dirigés Semaine 2 - CM : Descente de gradient stochastique et rétropropagation Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 2 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week02/02-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week02/02-2/ Semaine 2 - TD : Entraînement d'un réseau de neurones Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 2 - Travaux dirigés Travaux dirigés: https://atcold.github.io/pytorch-Deep-Learning/fr/week02/02-3/ Semaine 3 - CM : Réseaux de neurones convolutifs (ConvNets) Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 3 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week03/03-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week03/03-2/ Semaine 3 - TD : Propriétés des signaux naturels et ConvNets Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 3 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week03/03-3/ Semaine 4 - TD : Ecouter les convolutions Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 4 - Travaux dirigés Travaux dirigés: https://atcold.github.io/pytorch-Deep-Learning/fr/week04/04-1/ Semaine 5 – CM : Optimisation Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 5 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week05/05-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week05/05-2/ Semaine 5 – TD : Convolution multi-canaux 1D et autograd Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 5 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week05/05-3/ Semaine 6 – CM : Applications des ConvNets, RNNs et attention Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 6 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week06/06-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week06/06-2/ Semaine 6 – TD : Architectures des RNNs et des LSTMs Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 6 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week06/06-3/ Semaine 7 – CM : Modèles à base d’énergie (EBMs) et apprentissage autosupervisé Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 7 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week07/07-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week07/07-2/ Semaine 7 – TD : Auto-encodeurs sous/sur-complets Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 7 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week07/07-3/ Semaine 8 – CM : Méthodes constratives et modèles à variable latente régularisée Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 8 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week08/08-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week08/08-2/ Semaine 8 – TD : Auto-encodeurs variationnels (VAEs) Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 8 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week08/08-3/ Semaine 9 – CM : Eparsité de groupe, modèle du monde et GANs Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 9 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week09/09-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week09/09-2/ Semaine 9 – TD : GANs vus à travers les EBMs Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 – Semaine 9 – Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week09/09-3/ Semaine 10 – CM : Apprentissage autosupervisé en vision par ordinateur Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 10 – Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week10/10-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week10/10-2/ Semaine 10 – TD : Le « Truck Backer-Upper » Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 10 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week10/10-3/ Semaine 11 – CM : Fonctions d’activation et de perte sur PyTorch Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 11 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week11/11-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week11/11-2/ Semaine 11 – TD : La prédiction et l’apprentissage de politique sous contrainte (PPUU) Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 11 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week11/11-3/ Semaine 12 – CM : Apprentissage profond pour le traitement du langage naturel No translation for this video. Semaine 12 – TD : L’attention et le Transformer Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 12 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week12/12-3/ Semaine 13 – CM : Les réseaux de neurones convolutifs pour graphes (GCNs) Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 13 – Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week13/13-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week13/13-2/ Semaine 13 – TD : Les réseaux de neurones pour graphes (GNNs) Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 13 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week13/13-3/ Semaine 14 – CM : Prédiction utilisant la structure avec les EBMs Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 14 - Cours magistral Cours magistral partie A : https://atcold.github.io/pytorch-Deep-Learning/fr/week14/14-1/ Cours magistral partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week14/14-2/ Semaine 14 – TD : Surapprentissage et régularisation, et réseaux de neurones bayésiens Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 14 - Travaux dirigés Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week14/14-3/ Semaine 15 – TD partie A : Inférence pour les EBMs à variable latente Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 15 - Travaux dirigés partie A Travaux dirigés : https://atcold.github.io/pytorch-Deep-Learning/fr/week15/15-1/ Semaine 15 – TD partie B : Entraînement des EBMs à variable latente Site web du cours : https://atcold.github.io/pytorch-Deep-Learning/fr/ 0:00:00 - Semaine 15 – Travaux dirigés partie B Travaux dirigés partie B : https://atcold.github.io/pytorch-Deep-Learning/fr/week15/15-2/ |

|

I'll have to do a tiny PR to correct a few things on the website. Let me know if there is anything that needs to be fixed regarding the translation of the videos. |

|

I'm pushing now a cumulative update for all broken French captions. Also, I've just finished uploading all the captions and filling in the translations. It took “some” time, LOL. |

|

I'm manually writing down the website corrections I should make, let me know when you're done so I can make a fork once everything is done to avoid conflicts. As a video not mentioned on the site, there is also this one. |

|

I think I can tweet this image. |

|

I'm finishing the mini PR and I'm writing you a little text in french to put with the pictures. I had created a twitter account just in case (https://twitter.com/BdsLoick) which I don't use for the moment. |

Hi Alf 👋,

As indicated in my last email, I can't afford to wait for Yann's return without a big delay on my side.

So here are the subtitle files:

The list of files not modified during this review of the unicode: practinum1 (didn't need unicode), practinum4 (the file contains blocks of 3 instead of 2 for the others), for lecture 12 (the only file I didn't translate into French)

The list of finished files (full English review + unicode) : lecture 6 & 9

The list of about clean files (partial English review + unicode) : lecture 1-3,10,11 + practinum 1-3, 7-8, 10

The list of not clean files (no English review + unicode): lecture 5-9,12-15 + practinum 5-6,9,11-15

I also added a disclamer for the V2 of the French translation of the website which should arrive this month. It should be my next and last PR closing the French translation work 💥

Loïck