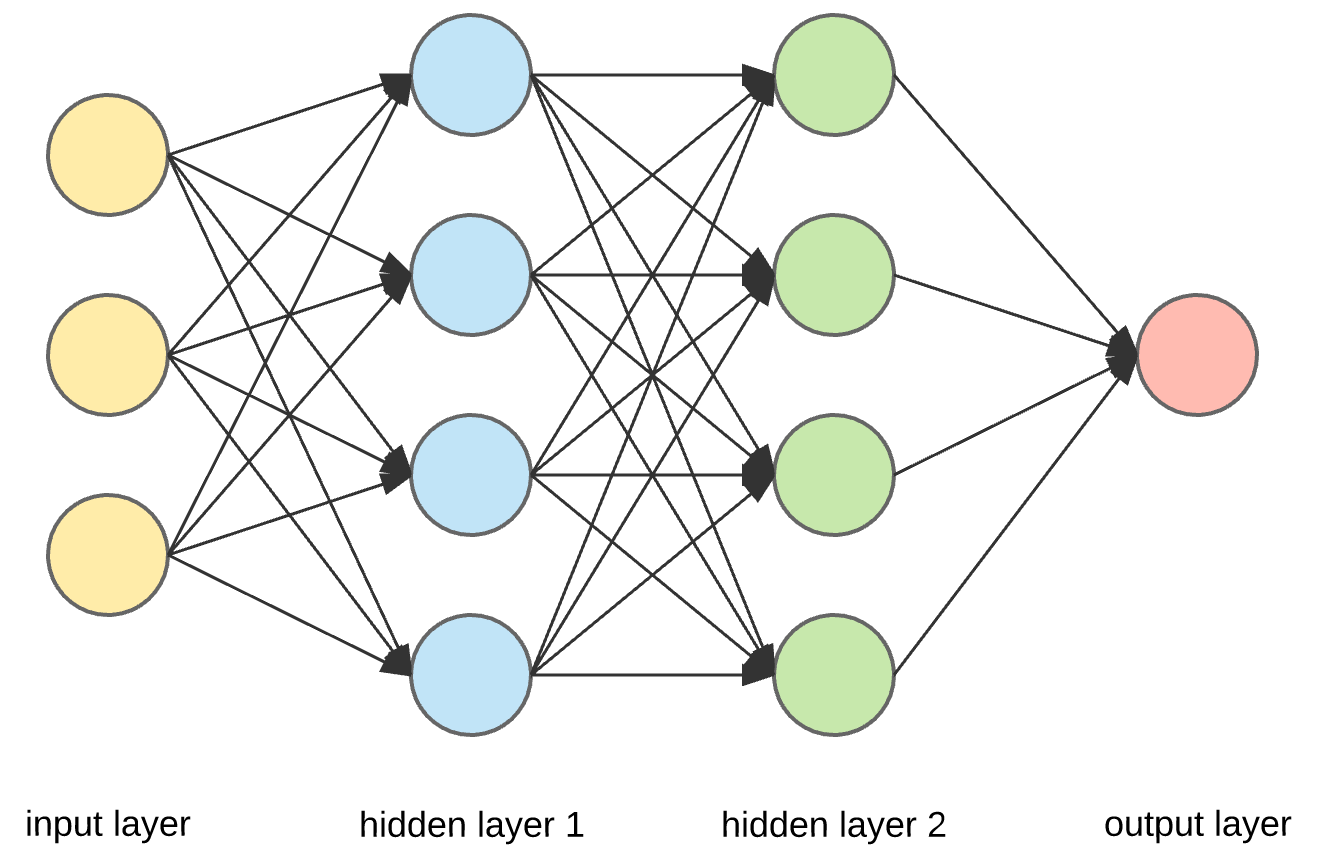

Feed Forward Neural Network (FFNN)

[cited from https://towardsdatascience.com/build-up-a-neural-network-with-python-7faea4561b31]

- layer-approach implementation for expanding to Deep Learning

- Affine

- ReLU

- Affine

- Softmax with Loss

- Xavier (for sigmoid/tanh)

- He (for ReLU)

- numerical differantial

- back propagation (based on chain-rule)

- SGD

- Momentum

- AdaGrad

- Adam

- sum squared error

- cross entropy error

- Relu layer

- Sigmoid layer

- Affine layer

- Softmax with Loss Layer

- 斎藤康毅, “ゼロから作るDeep Learning ーPythonで学ぶディープラーニングの理論と実装”, 初版第10刷, オーム社(オライリージャパン), 2016.

- 岡谷貴之, “深層学習”, 初版第12刷, 講談社, 2015, 機械学習プロフェッショナルシリーズ.

- Sebastian Raschka, Vahid Mirjalili, “[第2版]Python機械学習プログラミング 達人データサイエンティストによる理論と実装”, 第1版第3刷, インプレス, 2019.

- Diederik Kingma, Jimmy Ba, “Adam : A Method for Stochastic Optimization”, ICLR2015, https://arxiv.org/pdf/1412.6980v8.pdf, 2014.