You signed in with another tab or window. Reload to refresh your session.You signed out in another tab or window. Reload to refresh your session.You switched accounts on another tab or window. Reload to refresh your session.Dismiss alert

Taylor, Ross, Marcin Kardas, Guillem Cucurull, Thomas Scialom, Anthony Hartshorn, Elvis Saravia, Andrew Poulton, Viktor Kerkez, and Robert Stojnic. 2022. “Galactica: A Large Language Model for Science.” arXiv [cs.CL]. arXiv. http://arxiv.org/abs/2211.09085.

Information overload is a major obstacle to scientific progress. The explosive growth in scientific literature and data has made it ever harder to discover useful insights in a large mass of information. Today scientific knowledge is accessed through search engines, but they are unable to organize scientific knowledge alone. In this paper we introduce Galactica: a large language model that can store, combine and reason about scientific knowledge. We train on a large scientific corpus of papers, reference material, knowledge bases and many other sources. We outperform existing models on a range of scientific tasks. On technical knowledge probes such as LaTeX equations, Galactica outperforms the latest GPT-3 by 68.2% versus 49.0%. Galactica also performs well on reasoning, outperforming Chinchilla on mathematical MMLU by 41.3% to 35.7%, and PaLM 540B on MATH with a score of 20.4% versus 8.8%. It also sets a new state-of-the-art on downstream tasks such as PubMedQA and MedMCQA dev of 77.6% and 52.9%. And despite not being trained on a general corpus, Galactica outperforms BLOOM and OPT-175B on BIG-bench. We believe these results demonstrate the potential for language models as a new interface for science. We open source the model for the benefit of the scientific community1.

2 Related Work の項目で、本論文でGalacticaが取り組んだ各タスクでどのようなアプローチがこれまで取られてきたかが列挙されている。

「計算機による科学的知識の集積のサポート」というアイデアを出した古い記事

Bush, Vannevar. 1945. “As We May Think.” Atlantic Monthly 176 (July): 101–8.

Licklider, J. C. R. 1960. “Man-Computer Symbiosis.” IRE Transactions on Human Factors in Electronics HFE-1 (1): 4–11.

プロンプトを事前学習に含めるというアイデアの由来

Wei, Jason, Maarten Bosma, Vincent Y. Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan Du, Andrew M. Dai, and Quoc V. Le. 2021. “Finetuned Language Models Are Zero-Shot Learners.” arXiv [cs.CL]. arXiv. http://arxiv.org/abs/2109.01652.

Sanh, Victor, Albert Webson, Colin Raffel, Stephen H. Bach, Lintang Sutawika, Zaid Alyafeai, Antoine Chaffin, et al. 2021. “Multitask Prompted Training Enables Zero-Shot Task Generalization.” arXiv [cs.LG]. arXiv. http://arxiv.org/abs/2110.08207.

Chung, Hyung Won, Le Hou, Shayne Longpre, Barret Zoph, Yi Tay, William Fedus, Yunxuan Li, et al. 2022. “Scaling Instruction-Finetuned Language Models.” arXiv [cs.LG]. arXiv. http://arxiv.org/abs/2210.11416.

Khashabi, Daniel, Sewon Min, Tushar Khot, Ashish Sabharwal, Oyvind Tafjord, Peter Clark, and Hannaneh Hajishirzi. 2020. “UnifiedQA: Crossing Format Boundaries With a Single QA System.” arXiv [cs.CL]. arXiv. http://arxiv.org/abs/2005.00700.

Zhang, Susan, Stephen Roller, Naman Goyal, Mikel Artetxe, Moya Chen, Shuohui Chen, Christopher Dewan, et al. 2022. “OPT: Open Pre-Trained Transformer Language Models.” arXiv [cs.CL]. arXiv. http://arxiv.org/abs/2205.01068.

Chinchilla

Hoffmann, Jordan, Sebastian Borgeaud, Arthur Mensch, Elena Buchatskaya, Trevor Cai, Eliza Rutherford, Diego de Las Casas, et al. 2022. “Training Compute-Optimal Large Language Models.” arXiv [cs.CL]. arXiv. http://arxiv.org/abs/2203.15556.

PaLM 540B

Chowdhery, Aakanksha, Sharan Narang, Jacob Devlin, Maarten Bosma, Gaurav Mishra, Adam Roberts, Paul Barham, et al. 2022. “PaLM: Scaling Language Modeling with Pathways.” arXiv [cs.CL]. arXiv. http://arxiv.org/abs/2204.02311.

Taylor, Ross, Marcin Kardas, Guillem Cucurull, Thomas Scialom, Anthony Hartshorn, Elvis Saravia, Andrew Poulton, Viktor Kerkez, and Robert Stojnic. 2022. “Galactica: A Large Language Model for Science.” arXiv [cs.CL]. arXiv. http://arxiv.org/abs/2211.09085.

言語モデルが方程式や化学反応などの専門知識をある程度吸収できているのが個人的には一番の驚き。精度が上がれば知識の集積に加えてその活用部分でもGalacticaによる貢献は大きいと考えられ、科学者の仕事の仕方は大きく変わりそう。

一方、多くの指標でSoTA達成といえど、アウトプットされた内容には多くの間違いを含み、実用に耐えうる精度ではない。この点を理解した上で本論文の貢献を議論し、モデルを使う・出力を見る必要がある。

Abstract

(DeepL翻訳)

情報の過多は、科学の進歩の大きな障害となっている。科学文献やデータの爆発的な増加により、大量の情報の中から有用な知見を発見することがますます困難になっている。今日、科学的知識は検索エンジンによってアクセスされるが、検索エンジンだけでは科学的知識を整理することはできない。本論文では、Galacticaを紹介する:科学的知識を保存、結合、推論することができる大規模言語モデルである。我々は、論文、参考資料、知識ベース、その他多くのソースからなる大規模な科学コーパスで学習を行う。我々は、様々な科学的タスクにおいて、既存のモデルを凌駕する性能を発揮する。LaTeX方程式などの技術的な知識に関するプローブでは、最新のGPT-3に対して68.2%対49.0%という高い性能を示しました。推論についても、数学的MMLUでChinchillaを41.3%対35.7%、MATHでPaLM 540Bを20.4%対8.8%と上回り、高い性能を発揮しました。また、PubMedQAやMedMCQAなどの下流タスクにおいても、それぞれ77.6%、52.9%のスコアを獲得し、最新鋭の技術を確立しています。また、Galacticaは一般的なコーパスで学習していないにもかかわらず、BIG-benchにおいてBLOOMやOPT-175Bを上回る性能を発揮しています。これらの結果は、科学の新しいインターフェースとしての言語モデルの可能性を示していると考えています。我々は、科学コミュニティの利益のために、このモデルをオープンソース化します1。

コード

解決した課題/先行研究との比較

技術・手法のポイント

モデルのアーキテクチャはデコーダのみのTransformerをベースにしている。 (本文4.1 Architecture項参照)

モデルのパラメータ数は最大のもので1200億

4800万件の論文、コード、教科書、講義ノート、数百万件の化合物・タンパク質データ、科学ウェブサイト、百科事典などといった「科学的知識データ」で学習

こうしたデータにタスク固有のトークンと引用を示すトークンをつける

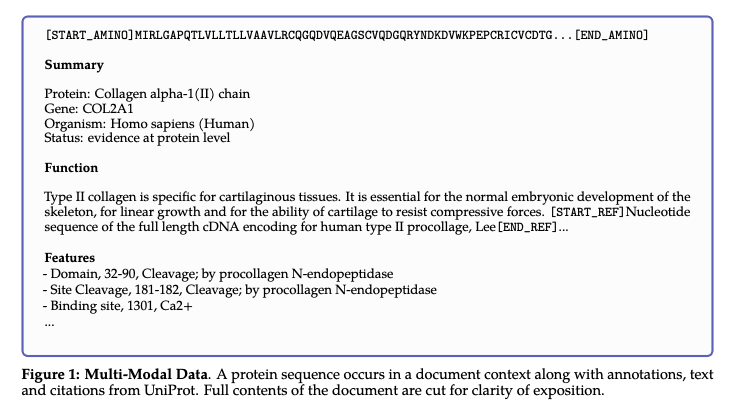

例えばタンパク質については Fig.1

1行1行計算を進めていくような課題は、ワーキングメモリを意味するトークンで包む。例が Fig.3

また、事前学習の段階でデータにプロンプト (指示文) も含めて学習させた

評価指標

上記はSoTAレベルに到達したものの話。他にも様々な課題に取り組まれており、例えばチェスをしたりもしている。

残された課題・議論

技術的には、こうした実装でこれだけの知識を集約でき、これだけのものが生成できる事実がとてもおもしろく、意義深いものであるのは間違いない。

一方で、非常にキャッチーな技術であるだけに、デモの一般公開 + 今回の喧伝の仕方は少し勇み足だったのかもしれない。

重要な引用

関連する仕事

などのML使った論文検索サービスと組み合わさると、(それぞれの強みが異なるので) 知識の整理がより簡単にできるようになりそう。

2022年11月30日にOpenAIよりChatGPTというサービスが公開された。これはGPT-3をベースとしているらしく、テキストで投げかけた話題に会話形式で応答してくれる。日本語にも対応。

驚くような質の高い会話ができることもある一方で、頓珍漢な回答をしてくることもある。この課題はGalacticaと共通。

GPT-4が2022年12月〜2023年2月頃に公開予定という情報がある。

The text was updated successfully, but these errors were encountered: