New issue

Have a question about this project? Sign up for a free GitHub account to open an issue and contact its maintainers and the community.

By clicking “Sign up for GitHub”, you agree to our terms of service and privacy statement. We’ll occasionally send you account related emails.

Already on GitHub? Sign in to your account

关于TRANS Ⅲ中的注意事项 #16

Comments

|

补:我又重新计算了一遍这个卷积过程中的值,似乎结果是一致的,我没有想清楚您这个不成立的原因在哪里,可能是我的理解问题,还烦请您解惑,多有叨扰,谢谢! |

|

您好,

可以写一段代码试一下,就会发现问题了。注意把conv1x1的bias初始化为非0。

***@***.***

发件人: CC

发送时间: 2021-05-23 22:01

收件人: DingXiaoH/DiverseBranchBlock

抄送: Subscribed

主题: Re: [DingXiaoH/DiverseBranchBlock] 关于TRANS Ⅲ中的注意事项 (#16)

补:我又重新计算了一遍这个卷积过程中的值,似乎结果是一致的,我没有想清楚您这个不成立的原因在哪里,可能是我的理解问题,还烦请您解惑,多有叨扰,谢谢!

—

You are receiving this because you are subscribed to this thread.

Reply to this email directly, view it on GitHub, or unsubscribe.

|

|

如果k*k卷积核的padding=1,是不是等式8成立?是不是可以把BNAndPadLayer换成普通的BatchNorm2d? |

|

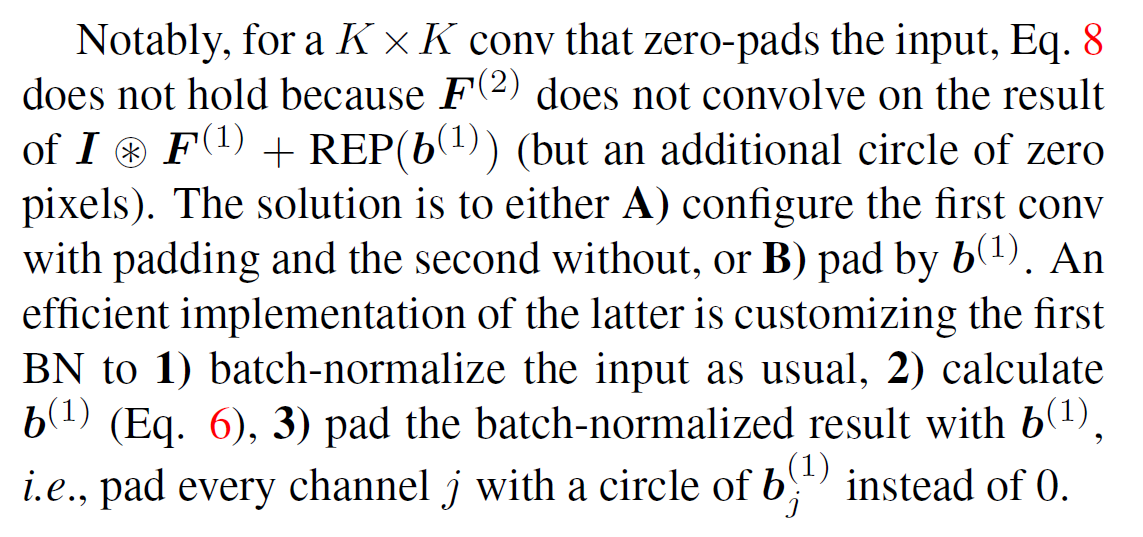

公式8成立的前提是,KxK的输入等于1x1-BN的输出。在KxK有padding的情况下,KxK的输入不等于1x1-BN的输出(多了一圈0)。在这种情况下让Trans Ⅲ成立的方法是用1x1的等效bias去pad。 |

不是。padding=0才可以把BNAndPadLayer换成普通的BatchNorm2d。请参考上面的解释 |

|

谢谢你的回复!我有点明白了。 |

|

这是padding的问题。 |

謝謝 |

大大,你給的方法在我的情況work 了。 |

您好!不好意思打扰您!!我最近拜读您的论文,看到了TRANS Ⅲ,不得不说这种变换确实很是新颖,但看到其中您提到的注意点,即如果第二层K*K 如果对输入做了0填充,那么公式8是不成立的,解决方案是用第一次等价过来的卷积的偏置 REP(b1) 作为填充,对这一点我有点不太理解,您能给详细解释一下不成立的原因以及解决方案的原因么?谢谢您!

The text was updated successfully, but these errors were encountered: