.optimization モジュールは以下を提供します。

- モデルの微調整に使用できる重み減衰が修正されたオプティマイザー、および

_LRScheduleから継承するスケジュール オブジェクトの形式のいくつかのスケジュール:- 複数のバッチの勾配を累積するための勾配累積クラス

[[autodoc]] AdamW

[[autodoc]] Adafactor

[[autodoc]] AdamWeightDecay

[[autodoc]] create_optimizer

[[autodoc]] SchedulerType

[[autodoc]] get_scheduler

[[autodoc]] get_constant_schedule

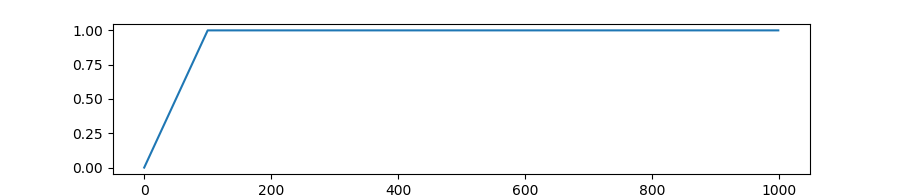

[[autodoc]] get_constant_schedule_with_warmup

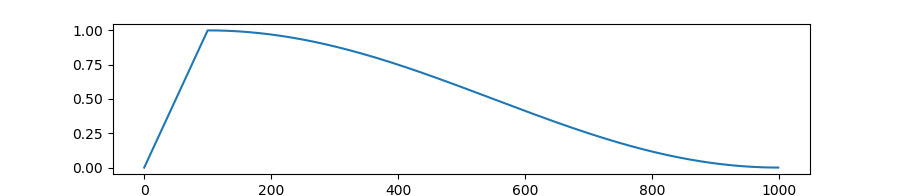

[[autodoc]] get_cosine_schedule_with_warmup

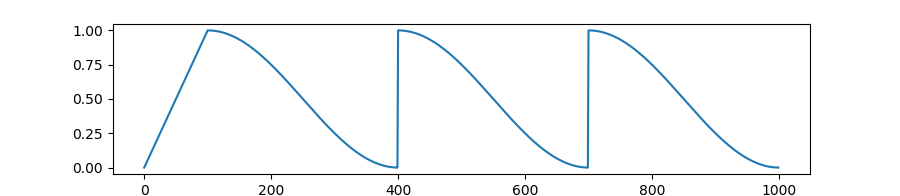

[[autodoc]] get_cosine_with_hard_restarts_schedule_with_warmup

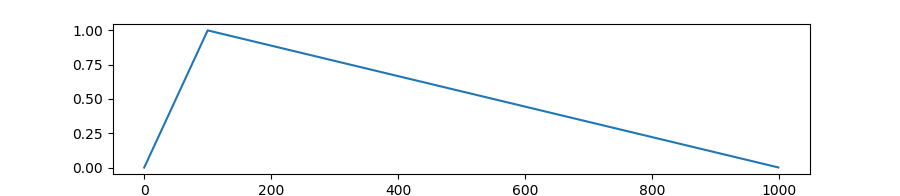

[[autodoc]] get_linear_schedule_with_warmup

[[autodoc]] get_polynomial_decay_schedule_with_warmup

[[autodoc]] get_inverse_sqrt_schedule

[[autodoc]] WarmUp

[[autodoc]] GradientAccumulator