-

Notifications

You must be signed in to change notification settings - Fork 3

New issue

Have a question about this project? Sign up for a free GitHub account to open an issue and contact its maintainers and the community.

By clicking “Sign up for GitHub”, you agree to our terms of service and privacy statement. We’ll occasionally send you account related emails.

Already on GitHub? Sign in to your account

redis调研与实践 #88

Comments

Redis连接池设置其实就是用来保持长连接, 因为redis-client和redis-server建立链接,要通过 tcp 和 自身的协议, 但是我们经常使用redis,并不希望频繁的去建立链接和释放链接 maxTotal用来表示最大的连接数,受以下情况影响

maxIdle or minIdle建议 maxIdle = maxTotal

建议预热minIdle |

对于RedisTimeOut可以进行的监控 |

Redis持久化数据异步保存在disk中 RDB内存快照,可以理解为redis的键值序列化,也可以用于网络传输(主从复制)。 触发机制

AOF命令的备份写到文件中, redis -> 写命令缓冲区 -> disk AOF策略

rewrite由于每条命令都会append到disk里,disk占用较大,而命令中多会出现这样的结果 其实,只需要最后的 RDB 和 AOF抉择最佳实践

fork 信息查询

|

内存相关

内存分布内存主要分为redis自身运行占用内存,缓冲区(客户端缓冲区, 复制缓冲区(slave复制时使用), AOF缓冲区), 对象(kv)占用内存,fork占用内存 客户端缓冲区

内存回收策略删除过期键值

内存溢出策略用

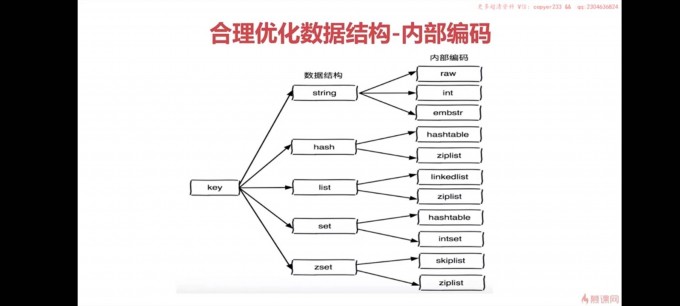

内存优化合理选择数据结构也就是键的类型, string, hash, set, zset, hyperloglog, geo等 合理优化数据结构-内部编码给一个场景

|

slowlogslowlog是一个队列,先入先出,记录大于slowlog时间阈值的命令以及执行时间

自己还未解决的坑

|

redis-link

apply

Redis可以做

由于redis是单核的,所以尽量部署多个redis,然后进行loadblance

The text was updated successfully, but these errors were encountered: