-

Chapter 01 나의 첫 머신러닝

▶️ 이 생선의 이름은 무엇인가요?-

01-1 인공지능과 머신러닝, 딥러닝

▶️ 인공지능과 머신러닝, 딥러닝은 무엇일까요?- 인공지능이란

- 머신러닝이란

- 딥러닝이란

-

01-2 코랩과 주피터 노트북

▶️ 코랩과 주피터 노트북으로 손코딩 준비하기- 구글 코랩

- 텍스트 셀

- 코드 셀

- 노트북

-

01-3 마켓과 머신러닝

▶️ 마켓을 예로 들어 머신러닝을 설명합니다.- 생선 분류 문제

- 첫 번째 머신러닝 프로그램

-

-

Chapter 02 데이터 다루기

▶️ 수상한 생선을 조심하라!-

02-1 훈련 세트와 테스트 세트

▶️ 모델을 훈련 시키는 훈련 세트와 검증하는 테스트 세트로 나누어 학습하기- 지도 학습과 비지도 학습

- 훈련 세트와 테스트 세트

- 샘플링 편향

- 넘파이

- 두 번째 머신러닝 프로그램

-

02-2 데이터 전처리

▶️ 정교한 결과 도출을 위한 데이터 전처리 알아보기- 넘파이로 데이터 준비하기

- 사이킷런으로 훈련 세트와 테스트 세트 나누기

- 수상한 도미 한 마리

- 기준을 맞춰라

- 전처리 데이터로 모델 훈련하기

-

-

Chapter 03 회귀 알고리즘과 모델 규제

▶️ 농어의 무게를 예측하라!-

03-1 k-최근접 이웃 회귀

▶️ 회귀 문제를 이해하고 k-최근접 이웃 알고리즘으로 풀어 보기- k-최근접 이웃 회귀

- 데이터 준비

- 결정계수(R2)

- 과대적합 vs 과소적합

-

03-2 선형 회귀

▶️ 사이킷런으로 선형 회귀 모델 만들어 보기- k-최근접 이웃의 한계

- 선형 회귀

- 다항 회귀

-

03-3 특성 공학과 규제

▶️ 특성 공학과 규제 알아보기- 다중 회귀

- 데이터 준비

- 사이킷런의 변환기

- 다중 회귀 모델 훈련하기

- 규제

- 릿지 회귀

- 라쏘 회귀

-

-

Chapter 04 다양한 분류 알고리즘

▶️ 럭키백의 확률을 계산하라!-

04-1 로지스틱 회귀

▶️ 로지스틱 회귀 알고리즘을 배우고 이진 분류 문제에서 클래스 확률 예측하기- 럭키백의 확률

- 로지스틱 회귀

-

04-2 확률적 경사 하강법

▶️ 경사 하강법 알고리즘을 이해하고 대량의 데이터에서 분류 모델을 훈련하기- 점진적인 학습

- SGDClassifier

- 에포크와 과대/과소적합

-

-

Chapter 05 트리 알고리즘

▶️ 화이트 와인을 찾아라!-

05-1 결정 트리

▶️ 결정 트리 알고리즘을 사용해 새로운 분류 문제 다루기- 로지스틱 회귀로 와인 분류하기

- 결정 트리

-

05-2 교차 검증과 그리드 서치

▶️ 검증 세트가 필요한 이유를 이해하고 교차 검증해 보기- 검증 세트

- 교차 검증

- 하이퍼파라미터 튜닝

-

05-3 트리의 앙상블

▶️ 앙상블 학습을 알고 실습해 보기- 정형 데이터와 비정형 데이터

- 랜덤 포레스트

- 엑스트라 트리

- 그레이디언트 부스팅

- 히스토그램 기반 그레이디언트 부스팅

-

-

Chapter 06 비지도 학습

▶️ 비슷한 과일끼리 모으자!-

06-1 군집 알고리즘

▶️ 흑백 이미지 분류 방법과 비지도 학습, 군집 알고리즘 이해하기- 과일 사진 데이터 준비하기

- 픽셀값 분석하기

- 평균값과 가까운 사진 고르기

-

06-2 k-평균

▶️ k-평균 알고리즘 작동 방식을 이해하고 비지도 학습 모델 만들기- k-평균 알고리즘 소개

- KMeans 클래스

- 클러스터 중심

- 최적의 k 찾기

-

06-3 주성분 분석

▶️ 차원을 알고 차원 축소 알고리즘 PC 모델 만들기- 차원과 차원 축소

- 주성분 분석 소개

- PCA 클래스

- 원본 데이터 재구성

- 설명된 분산

- 다른 알고리즘과 함께 사용하기

-

-

Chapter 07 딥러닝을 시작합니다

▶️ 패션 럭키백을 판매합니다!-

07-1 인공 신경망

▶️ 텐서플로로 간단한 인공 신경망 모델 만들기- 패션 MNIST

- 로지스틱 회귀로 패션 아이템 분류하기

- 인공 신경망

- 인공 신경망으로 모델 만들기

- 인공 신경망으로 패션 아이템 분류하기

-

07-2 심층 신경망

▶️ 인공 신경망에 층을 추가하여 심층 신경망 만들어 보기- 2개의 층

- 심층 신경망 만들기

- 층을 추가하는 다른 방법

- 렐루 활성화 함수

- 옵티마이저

-

07-3 신경망 모델 훈련

▶️ 인경 신경망 모델 훈련의 모범 사례 학습하기- 손실 곡선

- 검증 손실

- 드롭아웃

- 모델 저장과 복원

- 콜백

-

-

Chapter 08 이미지를 위한 인공 신경망

▶️ 패션 럭키백의 정확도를 높입니다!-

08-1 합성곱 신경망의 구성 요소

▶️ 합성곱 신경망의 개념과 동작 원리를 배우고 간단한 실습하기- 합성곱

- 케라스 합성곱 층

- 합성곱 신경망의 전체 구조

-

08-2 합성곱 신경망을 사용한 이미지 분류

▶️ 케라스 API로 합성곱 신경망 모델 만들기- 패션 MNIST 데이터 불러오기

- 합성곱 신경망 만들기

- 모델 컴파일과 훈련

-

08-3 합성곱 신경망의 시각화

▶️ 신경망이 이미지에서 학습하는 게 무엇인지 이해하기- 가중치 시각화

- 함수형 API

- 특성 맵 시각화

-

-

Chapter 09 텍스트를 위한 인공 신경망

▶️ 한빛 마켓의 댓글을 분석하라!-

09-1 순차 데이터와 순환 신경망

▶️ 순차 데이터의 특징과 개념 이해하기- 순차 데이터

- 순환 신경망

- 셀의 가중치와 입출력

-

09-2 순환 신경망으로 IMDB 리뷰 분류하기

▶️ 텐서플로 순환 신경망으로 영화 리뷰 분류하기- IMDB 리뷰 데이터셋

- 순환 신경망 만들기

- 순환 신경망 훈련하기

- 단어 임베딩을 사용하기

-

09-3 LSTM과 GRU 셀

▶️ 순환 신경망의 중요 기술을 사용해 모델 만들어 보기- LSTM 구조

- LSTM 신경망 훈련하기

- 순환층에 드롭아웃 적용하기

- 2개의 층을 연결하기

- GRU 구조

- GRU 신경망 훈련하기

-

-

Notifications

You must be signed in to change notification settings - Fork 0

Dohy-Lee/ML_DL.Basic

Folders and files

| Name | Name | Last commit message | Last commit date | |

|---|---|---|---|---|

Repository files navigation

About

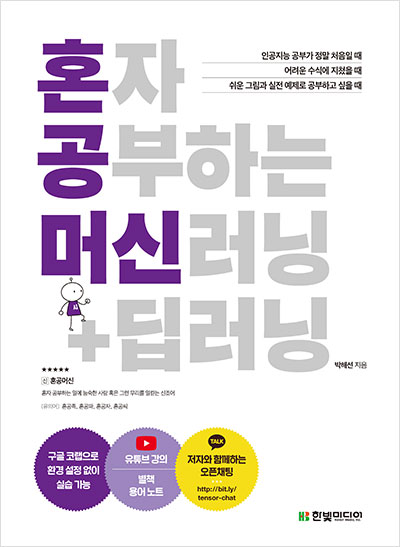

혼자 공부하는 머신러닝+딥러닝에 있는 실습내용들을 이해하면서 실습해보자

Resources

Stars

Watchers

Forks

Releases

No releases published

Packages 0

No packages published