- Versão v1.0.3

- Friday 2024-11-22 07:00:02 -04 verifique os logs aqui.

O CNPq por meio do currículo Lattes agrega dados do registro da vida profissional de estudantes, professores, e pesquisadores do país, e tornando-se padrão nacional no meio científico para consulta sobre a produção científica dos referidos profissionais.

Contudo, após a criação do captcha para o acesso aos currículos Lattes, extrair dados dos currículos se tornou uma tarefa árdua, pois todas vez que pretende-se acessar um currículo, torna-se necessário passar pelo captcha. Com o intuito de auxiliar na obtenção destes dados, o lucyLattes foi desenvolvido.

Com o intuito de melhorar a extração dos dados, e reduzir a possibilidade de erros de execução, a versão v1.0.0 foi desenvolvida. As principais mudanças estão na lógica de extração dos dados, organização dos arquivos e novos relatórios.

Extração, compilação, e organização dos dados dos currículos da plataforma Lattes em arquivos de texto, e geração de um relátório simplificado, que proporcionam agilidade para a geração de informação.

Veja algumas informações geradas:

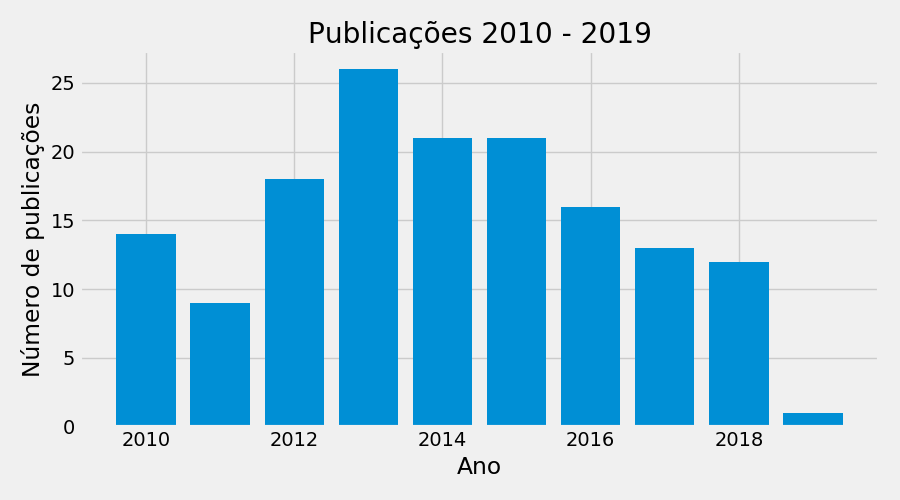

Publicações de periódicos por anoO lucyLattes não tem vínculo com o CNPq. Este programa computacional é fruto de um esforço (independente) realizado com o objetivo de dar suporte às rotinas de análise de dados cadastradas nos Currículos Lattes (publicamente disponíveis).

Este programa é um software livre; você pode redistribui-lo e/ou modificá-lo dentro dos termos da Licença Pública Geral GNU. Verifique o arquivo LICENSE.txt .

Este programa é distribuído na esperança que possa ser útil, mas SEM NENHUMA GARANTIA; sem uma garantia implicita de ADEQUAÇÂO a qualquer MERCADO ou APLICAÇÃO EM PARTICULAR. Verifique o arquivo LICENSE.txt .

Espero que o lucyLattes seja útil de alguma forma, dentro do possível estarei melhorando o script na sua funcionalidade.

-

Nos de uma estrela clicando na estrela no topo da página (lado direito)

-

Caso queira, sinta-se livre para me pagar um cafézinho. Tudo que faço aqui é uma maneira de retribuir e compartilhar o conhecimento que adquiri ao longo da minha carreira, mas quem sou eu para negar um café, certo? Sua ajuda vai ser convertida para manter os scripts (pagando o provedor, por exemplo). O excedente, será utilizado para comprar café mesmo.

-

via Paypal

- via Pix

Inicialmente recomenda-se a leitura dos próximos tópicos (Instalação e Como executar o programa).

- Sistema operacional Linux ou com base Unix (preferencialmente), ou ainda Windows;

- Python 3.8 ou superior;

- Navegador (Firefox ou Chromium) para visualizar relatório.

Python

- Se não possuir Python3 ou superior instalado no DEBIAN, UBUNTU ou derivados:

sudo apt-get install python3

sudo apt-get install python3-pip

sudo apt-get install python3-tk

Ambiente virtual python (virtual environments) no Linux

Para saber mais sobre ambiente virtual em Python, clique aqui https://docs.python.org/3/library/venv.html. Também fiz um post resumido sobre o assunto AQUI.

- De modo simplista:

- Crie uma pasta (diretório) e o ambiente virtual:

mkdir teste_venv

python3 -m venv ./teste_venv

- Para ativar o ambiente virtual:

rt@rt-av52a:~/.virtualenvs$ source ./teste_venv/bin/activate

(teste_venv) rafatieppo@rt-av52a:~/.virtualenvs$

- Para DEsativar o ambiente virtual:

(teste_venv) rafatieppo@rt-av52a:~/.virtualenvs$ deactivate

rafatieppo@rt-av52a:~/.virtualenvs$

Pacotes Python

Para todos os sistemas operacionais (Linux, MacOS, Windows, Solaris, etc) são necesssários as mesmas bibliotecas. Para instalar as bibliotecas em ambientes Linux acesse o Terminal, ative o seu ambiente Python e instale os pacotes.

Posteriormente, com o ambiente virtual ATIVADO, instale os pacotes necessários. No arquivo requirements_lucyLattes.txt está listado os pacotes necessários. Com o pip é possível executar o comando pip install -r requirements_lucyLattes,txt , e possivelmente os pacotes serão instalados. Ou ainda, vc pode instalar um pacote por vez.

(teste_venv) rt@rt-av52a:~/.virtualenvs$ pip3 install numpy

Collecting numpy

Cache entry deserialization failed, entry ignored

Downloading https://files.pythonhosted.org/packages/b8/46/40729c784/numpyx86_64.whl (14.1MB)

100% |████████████████████████████████| 14.1MB 128kB/s

Installing collected packages: numpy

Successfully installed numpy-1.21.1

(teste_venv) rafatieppo@rt-av52a:~/.virtualenvs$

- Se não possuir Python3 ou superior instalado no Windows

Acesse https://python.org.br/instalacao-windows/ e instale a versão do Python 3 (versão 3.8 ou superior), basta seguir as instruções. Não esqueça de instalar o PIP.

Recomenda-se criar um ambiente virtual para instalar os pacotes e executar o lucyLattes.

Ambiente virtual python (virtual environments) no Windows

- De modo simplista:

- Acesse o Power Shell como Administrador (botão direito) e libere a execução de Scripts. Se quiser saber mais Microsot

No Power Shell digite:

Set-ExecutionPolicy Unrestricted

pressione S ou Y.

- Crie uma pasta (diretório) que neste exemplo é denominada

teste_venv:

C:\Users\Joao\> mkdir teste_venv

- Crie o ambiente virtual na pasta que foi criada:

C:\Users\Joao\> python3 -m venv ./teste_venv

- Ative seu ambiente virtual.

C:\Users\Joao\> \teste_venv\Scripts\activate

Pronto, agora é só instalar as bibliotecas com o pip e posteriormente executar o LucyLattes.

- Para desativar o ambiente virtual.

(teste_venv) C:\Users\Joao\> deactivate

C:\Users\Joao\>

Pacotes Python

Para todos os sistemas operacionais (Linux, MacOS, Windows, Solaris, etc) são necesssários as mesmas bibliotecas. Para instalar as bibliotecas em ambientes Linux acesse o Terminal, ative o seu ambiente Python e instale os pacotes.

Posteriormente, com o ambiente virtual ATIVADO, instale os pacotes necessários. No arquivo requirements_lucyLattes.txt está listado os pacotes necessários. Com o pip é possível executar o comando pip install -r requirements_lucyLattes,txt , e possivelmente os pacotes serão instalados. Ou ainda, vc pode instalar um pacote por vez.

(teste_venv) C:\Users\Joao\> pip install numpy

Collecting numpy

Cache entry deserialization failed, entry ignored

Downloading https://files.pythonhosted.org/packages/b8/46/40729c784/numpyx86_64.whl (14.1MB)

100% |████████████████████████████████| 14.1MB 128kB/s

Installing collected packages: numpy

Successfully installed numpy-1.21.1

(teste_venv) C:\Users\Joao\>

Fiz um vídeo explicando como instalar e excutar o programa no Windows: https://youtu.be/L8TFyqXlemM

-

Faça o Download do arquivo

.zipque contém olucyLattes. Download aqui: https://rafatieppo.github.io/lucylattes/. Escolha a opção.zipou.tarpara fazer o download dos aquivos. -

Descompacte o arquivo

.zipque em um diretório de sua preferência. -

Faça o dowload dos curriculos Lattes desejados e copie todos no diretório

xml_zip. Para realizar o download dos currículos Lattes, acesse o currículo Lattes do pesquisador, e no canto superior direito clique sobre um botãoXML, salve o arquivo e NÃO altere o nome e nem o formato, e NÃO DESCOMPACTE OS ARQUIVOS. O nome do arquivo é composto por 16 caracteres e a extensão.zip, e.g.3275865819287843.zip. -

Pelo terminal (ou power shell), e com o ambiente virtual ATIVADO, acesse o diretório descompactado, e digite:

- Se for em ambiente

Linux:

python3 app_lucyLattes.py

- Se for em ambiente

Windows

python.exe app_lucyLattes.py (ou algo similar)

- Se tudo ocorreu corretamente, uma

interfaceaparecerá:

Agora selecione as opções disponíveis, clique em Gravar configurações, e execute (Run lucyLattes). Se tudo ocorreu normalmente, há um relatório disponível na pasta ./relatorio . Abra o arquivo relatorio_producao.html com o Firefox ou com o navegador da sua preferência.

-

DONE DANGER create a exceptio for NO papers found for reseacher.

-

DONE read

zipand return axml; -

DONE create a minidom from

.xml; -

DONE a function to return

.xmlencoding and version; -

DONE get dados-gerais and create a

csvfile for each researcher; -

DONE get research and extension projects with their respective participants, classification of the type of project (research or extension) by organizing the data into a

DataFrameand export in acsvfile for each researcher; -

DONE get published papers in journal by organizing the data into a

DataFrameand export in acsvfile for each researcher; -

DONE get published BOOKS organizing the data into a

DataFrameand export in acsvfile for each researcher; -

DONE get published CHAPTERS organizing the data into a

DataFrameand export in acsvfile for each researcher; -

DONE get advising for master, doc, pos-doc and others

-

DONE get teaching courses for each institution

-

DONE get short courses from others types of technical production

-

DONE assign qualis and jcr for each paper;

-

DONE Tidy data [100%]

- create algorithm to drop Titles by means cosine similarity

- tidy script data to join data from all researchers;

- tidy script to drop NaN, delete broked registers, etc

-

DONE Running and config [100%]

- conditional to run or not index-h

getindex_hwebsci() - work on a GUI

- conditional to run or not index-h

-

TODO Grapho for interactions among researchers [80%]

- interactions among researchers for papers;

- researchers with out interaction are listed;

- plot interaction

- Calcular o peso das interações dos membros no grafo;

- Verificar as interações nos projetos de pesquisa e extensão;

-

TODO Gerar índices utilizados pela CAPES para avaliação de PPG [0%]

- Índice de Orientação (IndOri)

- Índice de discentes autores (IndAut)

- Índice de produtos com autoria discente (IndDis)

- Índice de Produtividade referente a artigos científicos do Programa (IndProdArt)

- Validação

-

TODO Analyze H-index from WOS

-

TODO Report

.html[93%]- setup file (

report_setup.py) to report.py; - list of researcher with city, state, linl lattes, update, orcid;

- list of research and extension projects;

- list of books and chapters;

- summary (by year) of the papers, books, chapters for researchers group;

- summary (by qualis) of the papers, books, chapters for researchers group;

- plot (year and qualis) of the papers, books, chapters for researchers group;

- summary of teaching, books, chapters by each researcher;

- summary of finished advising

- summary of running advising

- summary of papers by year and qualis

- summary for each researcher (papers, projects, advising)

- summary WOS

- improve the name files output for

hindex_websci_papers.csvhindex_websci_allgroup.csvetc ... it is confuse. - create a

support_report.pyfile to decrease number of lines and improve the quality, maybe I should work with Classes. - create a function to fit yaxis in all plots

- setup file (

-

DONE Remove files

csvfiles in foldercsv_producao;csvfiles in foldercsv_report;

config.txt: minimal configurations to run lucylattes, it is possible to assign period (year), qualis group, etc.lucyLattes.py: run all;lucyLattes.py: funciona como o executável;./resources/read_set_config.py: is a class to assing configurations;./resources/getadv_minidom.py: write a.csvwith advising data from each.xml;./resources/getadvrunning_minidom.py: write a.csvwith running advising data from each.xml;./resources/getbooks_minidom.py: write a.csvwith books data from each.xml;./resources/getchapters_minidom.py: write a.csvwith chapters data from each.xml;./resources/getencoding_minidom.py: return enconding and version from.xml;./resources/getgeneraldata_minidom.py: write a.csvwith dados-gerais from each.xml;./resources/getgeneraldata_grad_minidom.py: write a.csvwith formacao-academica graduacao from each.xml;./resources/getgeneraldata_mest_minidom.py: with formacao-academica mestrado from each.xml;./resources/getgeneraldata_dout_minidom.py: with formacao-academica doutorado from each.xml;./resources/getminidom_xmlfile.py: return a minidom from each.xml;./resources/getpapers_minidom.py: write a.csvwith papers data from each.xml;./resources/getresearchextproj_minidom.py: write a.csvwith research and extension projects from each.xml;./resources/getshortcourses_minidom.py: write a.csvwith short courses from each.xml;./resources/getteaching_minidom.py: write a.csvwith teaching courses from each.xml;./resources/getworksevents.py: to get all TRABALHOS-EM-EVENTOS;./resources/grapho.py: make a plot for interections among researchers;./resources/index_capes.py: calcula os indicadores CAPES;./resources/paper_jcr.py: assign jcr score for each paper;./resources/paper_qualispy: assign qualis score for each paper;./resources/read_list_from_txt.py: read lines from atxtfiles and returns alist../resources/removefiles_csvproducao.py: removecsvfiles in folders./csv_producao/./csv_producao_hindex/./relatorio/csv_report/;./resources/report.py: Write a report with plots and summaries;./resources/report_class_filteryear.py: a class to improve report_setup function, a filter for productions;./resources/report_setup.py: Analize procuctions file, create setup file, csv to generat report../resourcer/report_setup_dict: create a dictionaru to aid inreport_setup.py;./resources/support_report_indexh.py: functions to aid in index-h calculation;./resources/support_report.py: functions to aid inreport.py./resources/tidydata_csv.py:- this script tidy all csv into folder

csv_producao; - there are several functions, each one for a kind of data (papers, ppe, ...);

- it creates a file

xxxxxx_all.csvwith the same kind of data for all researchers (e.g. fullname_all.csv, papers_all.csv); it creates a fileSeexxxxxx_uniq.csvwith the same kind of data for all researchers, HOWEVER in this file there is NO duplicates. Thus a specific paper or project, etc, belongs for am unique reseacher. To assign the owner of the paper or project, etc, the authorship order is used../resources/tidydata_uniq_titles.py:- from lucyLattes version 1.0, the script

verify.pywas emboided intotidydata_csv.py, it drops rows with NaN values on field YEAR- function for general data;

- function for research and extension projects;

- functions for papers, books, chapters, advising, teaching.

- this script tidy all csv into folder

./resources/tidydata_uniq_titles.py:- working on file from

tidydata_csv.py, it creates a filexxxxxx_uniq.csvwith NOTITLESduplicates. Thus a specific paper or project, etc, belongs for am unique reseacher. To assign the owner of the paper or project, etc, the authorship order is used. The duplicatesTITLESare dropped by mean cosine similarity.

- working on file from

./resources/unzip_xml.py: - unzipidlattes.zipand return a.xml;

- Improvement in the speed to get unique titles in papers, projects, ... around 10x faster

- A variable to controle processing time, it is printed on terminal.

- New types of QUALIS CAPES to classify the papers

- Fix the years to filter in report

- Other minor fixes

- new function to get FORMACAO-ACADEMICA-TITULACAO (graduacao mestrado doutorado) were implemented, the output is in

csv_producao.

- On

relatorio_producao.htmlthe initial and final period to evaluate the data (projects, papers, ...) was not working. It was because a date fitering function had not been implemented. It was solved and the report period is the same of year (initial / end) input.

- On

report.pyhad an error to filter projetcts, paper, etc. It was because thereport.pywas readingconfig.txtinsteadconfig_tk.txt.The issues has been solved with a new functions insupport_functions.py:yearlimit_forfilter_tk(), and some changes inread_set_config.pyclass:configSetup. The next step is to fix filter inreport.py.

- On Windows OS there ware a error from

report_resch_advi_runn_eachfunction and others functions that generates tables from advising data. The error was innp.select. For some reason,np.selectcould not find a math betweencondandchoicelists in those functions. I guess the error was a character error, becausecondlist has character like:ç ã í. To solve it, innp.selectthe default exit was replaced by-99

- From

DADOS-GERAIS$->$ FORMACAO-ACADEMICA-TITULACAOdata fromDOUTORADOwas add inxxx_fullname.csv

- A simple

GUIwas implemented in the fileapp_lucyLattes.py. ThisGUIgenerates the file./config_tk.txtwith the settings to runlucyLattes.py; Some changes were implemented in theclass configSetup(read_set_config.py); It was necessary to read the settings in./config_tk.txt. The fileconfig.txtremains, but it is useless for now; The functionpg_name()was changed as well, for now it gets PG's name from./config_tk.txt;

- A new method to drop the duplicate

TITLEShas been implemented. This method is based on cosine similarity and this algorithm is in the file./resources/tidydata_uniq_titles.py:

- It was fixed a type error in

report_setup_dict.py, in grapho_papernoint production, the function was change for columngrapho_noint. Intidydata_csv.pywas created a new function to tidy worksevents. It was created a new filegetworksevents.pyto get all TRABALHOS-EM-EVENTOS.

- The file

config.txtis being read inlucylattes.py, and variables are assigned from the classconfigSetup(). It is done for run indice capes, qualis file, wos, removefiles. The frame.append method is deprecated and was replaced by pandas.concat.

- a new function was implemented in

support_functions_indexh.py, it makes a report of paper's citations for a specific year. Notice that this papers was published in this same year.

- it was create a new function (

repot_setup_dict.py) to create a dictionary with basic information toreport_setup.py.

- the class

report_class_filteryear.pyhas been implemented. For a specific production, it finds a function to filter by years and generate acsvreport file. This class is used intoreport_setup.py, which is cleaner than before.

- in

report_setup.pyreplaceifbycase, it is a better approach, for now its running. inrepor_setup.pyfor running advising was implemented a fast lazy solution to solve the issue. It was because in running advising is not necessary to filter by year. The next steps are: to improve report layout, advisor and student interaction in papers.

- report was improved, advising has been implemented (it was missing). Report aesthetics has been improved for a better visualization.

- report is done. the output names for h index file has been improved. in the future, i should improve the code for report.py, for now its ok.

- individual summaries are done. minor fix in the code was implemented as follow: a new folder for hindex production; report for index h (unique) and group is NOT done.

- report group is done, individual summaries is incomplete.

report.pyhas been started. a improvement was implemented to filter the projetcts. it is because may belong partially for a period.

- report_setup.py was created. in this versions has been created a sub-folder in

relatorioto store csv files used inreport.py.

- grapho is working well. the calculation weights by interactions among researchers is done.

- new functions to improve tidy data; it was implemented into

tidydata_csv.py; the main feature is to drop rows with empty values in YEAR field.

- the script (

tidydata_csv) for tidy and join all data in only onecsvfor each production is done. There are two kinds of joinnedcsv,xxxxx_all.csvandxxxxx_uniq.csv.

- the papers were classified by qualis and jcr

- Short courses was collected from xml file, and a

csvis created. For allcsvfiles a column with ID (id lattes) was add. It makes easir to manipulate data in the future. Otherwise, thecsvfile will be a little bit greater.

- Advising for master, doc, pos-doc and other were collected from xml file, and a

csvis created.

- From papers published were add a new feature: from each author if there is the idCNPQ it is extracted. Data from books and chapters are alredy done.

- Papers published in journal were collected from a xml file, and a

csvis created. It is necessary add QUALIS and JCR

- Extraction of the projects in the same year has been solved.

- Research and extension projects were collected from xml file, and a

csvis created. It is necessary to review a some extension projetcs wich start in the same year.

- DADOS-GERAIS were collected from xml file, and a

csvis created; A git repo has been created.

- Version 2.0 has been started

J. P. Mena-Chalco e R. M. Cesar-Jr. scriptLattes: An open-source knowledge extraction system from the Lattes platform. Journal of the Brazilian Computer Society, vol. 15, n. 4, páginas 31--39, 2009.

Rossum, G. van ( C. voor W. en I. (CWI)). (1995). Python tutorial. Python (Vol. 206). Amsterdam.

https://docs.python.org/pt-br/3/library/venv.html

https://docs.python.org/pt-br/3/tutorial/venv.html

- Rafael Tieppo

- rafaeltieppo@yahoo.com.br

- https://rafatieppo.github.io/

- general data

<CURRICULO-VITAE

<DADOS-GERAIS

<RESUMO-CV

<ENDERECO

<ENDERECO-PROFISSIONAL

</ENDERECO>

</DADOS-GERAIS>

- ppe

<CURRICULO-VITAE

<ATUACOES-PROFISSIONAIS>

<ATUACAO-PROFISSIONAL

<ATIVIDADES-DE-PARTICIPACAO-EM-PROJETO>

<PARTICIPACAO-EM-PROJETO

<PROJETO-DE-PESQUISA

<EQUIPE-DO-PROJETO>

</EQUIPE-DO-PROJETO>

</PROJETO-DE-PESQUISA>

</PARTICIPACAO-EM-PROJETO>

</ATIVIDADES-DE-PARTICIPACAO-EM-PROJETO>

</ATUACAO-PROFISSIONAL>

</ATUACOES-PROFISSIONAIS>

- books

<CURRICULO-VITAE

<PRODUCAO-BIBLIOGRAFICA>

<LIVROS-E-CAPITULOS>

<LIVROS-PUBLICADOS-OU-ORGANIZADOS>

<LIVRO-PUBLICADO-OU-ORGANIZADO>

<DADOS-BASICOS-DO-LIVRO />

<AUTORES />

</LIVRO-PUBLICADO-OU-ORGANIZADO

</LIVROS-PUBLICADOS-OU-ORGANIZADOS>

</LIVROS-E-CAPITULOS

</PRODUCAO-BIBLIOGRAFICA>

- chapters

<CURRICULO-VITAE

<PRODUCAO-BIBLIOGRAFICA>

<LIVROS-E-CAPITULOS>

<CAPITULOS-DE-LIVROS-PUBLICADOS>

<CAPITULO-DE-LIVRO-PUBLICADO>

<DADOS-BASICOS-DO-CAPITULO />

<AUTORES />

</CAPITULO-DE-LIVRO-PUBLICADO

</CAPITULOS-DE-LIVROS-PUBLICADOS>

</LIVROS-E-CAPITULOS

</PRODUCAO-BIBLIOGRAFICA>

- advising finished

<CURRICULO-VITAE

<OUTRA-PRODUCAO>

<ORIENTACOES-CONCLUIDAS>

<ORIENTACOES-CONCLUIDAS-PARA-MESTRADO

</ORIENTACOES-CONCLUIDAS-PARA-MESTRADO>

<ORIENTACOES-CONCLUIDAS-PARA-DOUTORADO

</ORIENTACOES-CONCLUIDAS-PARA-DOUTORADO>

<ORIENTACOES-CONCLUIDAS-PARA-POS-DOUTORADO

</ORIENTACOES-CONCLUIDAS-PARA-POS-DOUTORADO>

<OUTRAS-ORIENTACOES-CONCLUIDAS

</OUTRAS-ORIENTACOES-CONCLUIDAS>

</ORIENTACOES-CONCLUIDAS

</OUTRA-PRODUCAO>

- advising running

<CURRICULO-VITAE

<DADOS-COMPLEMENTARES>

<ORIENTACOES-EM-ANDAMENTO>

<ORIENTACAO-EM-ANDAMENTO-DE-MESTRADO>

</ORIENTACAO-EM-ANDAMENTO-DE-MESTRADO>

<ORIENTACAO-EM-ANDAMENTO-DE-DOUTORADO>

</ORIENTACAO-EM-ANDAMENTO-DE-DOUTORADO>

<ORIENTACAO-EM-ANDAMENTO-DE-POS-DOUTORADO>

</ORIENTACAO-EM-ANDAMENTO-DE-POS-DOUTORADO>

<ORIENTACAO-EM-ANDAMENTO-DE-INICIACAO-CIENTIFICA>

</ORIENTACAO-EM-ANDAMENTO-DE-INICIACAO-CIENTIFICA>

<OUTRAS-ORIENTACOES-EM-ANDAMENTO>

</OUTRAS-ORIENTACOES-EM-ANDAMENTO>

</ORIENTACOES-EM-ANDAMENTO

</DADOS-COMPLEMENTARES>

</CURRICULUM-VITAE>

- teaching

<CURRICULO-VITAE

<ATUACOES-PROFISSIONAIS>

<ATUACAO-PROFISSIONAL

<ATIVIDADES-DE-ENSINO>

<ENSINO

<DISCIPLINA

</DISCIPLINA>

</ENSINO

</ATIVIDADES-DE-ENSINO>

</ATUACAO-PROFISSIONAL>

</ATUACOES-PROFISSIONAIS>

- courses

<CURRICULO-VITAE

<PRODUCAO-TECNICA>

<DEMAIS-TIPOS-DE-PRODUCAO-TECNICA>

<CURSO-DE-CURTA-DURACAO-MINISTRADO

</CURSO-DE-CURTA-DURACAO-MINISTRADO>

</DEMAIS-TIPOS-DE-PRODUCAO-TECNICA>

</PRODUCAO-TECNICA>

- papers

<CURRICULO-VITAE

<PRODUCAO-BIBLIOGRAFICA>

<ARTIGOS-PUBLICADOS

<ARTIGO-PUBLICADO>

<DADOS-BASICOS-DO-ARTIGO />

<AUTORES />

</ARTIGO-PUBLICADO>

</ARTIGOS-PUBLICADOS>

</PRODUCAO-BIBLIOGRAFICA>

- worksevents

<CURRICULO-VITAE

<PRODUCAO-BIBLIOGRAFICA>

<TRABALHOS-EM-EVENTOS>

<TRABALHO-EM-EVENTOS>

<DADOS-BASICOS-DO-EVENTO />

</TRABALHO-EM-EVENTOS>

<AUTORES />

</TRABALHOS-EM-EVENTOS>

</PRODUCAO-BIBLIOGRAFICA>