oom常见解决方式 g1详细方案

敖丙的:https://github.com/AobingJava/JavaFamily

书籍:

Java基础知识补充(Java、操作系统、网络):file:///C:/Users/Sun/Desktop/ssp/%E4%B8%80%E4%BA%9BPDF/java-programmers-interview-book.pdf

程序员面试金典:https://weread.qq.com/web/reader/bf93256071a122bebf98d95kc20321001cc20ad4d76f5ae

是什么https://www.cnblogs.com/suim1218/p/7699041.html

单点登录(Single Sign On),简称为 SSO,是目前比较流行的企业业务整合的解决方案之一。SSO的定义是在多个应用系统中,用户只需要登录一次就可以访问所有相互信任的应用系统。

主要实现方式:

- 后台共享Session不安全,所以后台共享SSO-token,他在多个整个server中是唯一的

- 前台呢,主要去存储1个SSO-token。

- 验证过程:每当一个用户要访问网站,如果没有登录,就引导到认证系统。如果有Token,就会带着token去访问,后台在根据SSO-token去验证,验证成功后,用户就可在在新的应用系统Server上,访问服务啦。

优点和缺点:

- 优点:程序员不用考虑用户系统,开发快;用户体验好;

- 缺点:不利于重构,涉及到系统太多了;

总结流程:

- add()直到满了,然后copy到一个新数组

- 当数组不在变动的时候,trimToSize()压缩多余空间

- 是否保证线程安全:

ArrayList和LinkedList都是不同步的,也就是不保证线程安全; - 底层数据结构:

Arraylist底层使用的是Object数组;LinkedList底层使用的是 双向链表 数据结构(JDK1.6 之前为循环链表,JDK1.7 取消了循环。注意双向链表和双向循环链表的区别,下面有介绍到!) - 插入和删除是否受元素位置的影响: ①

ArrayList采用数组存储,所以插入和删除元素的时间复杂度受元素位置的影响。 比如:执行add(E e)方法的时候,ArrayList会默认在将指定的元素追加到此列表的末尾,这种情况时间复杂度就是 O(1)。但是如果要在指定位置 i 插入和删除元素的话(add(int index, E element))时间复杂度就为 O(n-i)。因为在进行上述操作的时候集合中第 i 和第 i 个元素之后的(n-i)个元素都要执行向后位/向前移一位的操作。 ②LinkedList采用链表存储,所以对于add(E e)方法的插入,删除元素时间复杂度不受元素位置的影响,近似 O(1),如果是要在指定位置i插入和删除元素的话((add(int index, E element)) 时间复杂度近似为o(n))因为需要先移动到指定位置再插入。 - 是否支持快速随机访问:

LinkedList不支持高效的随机元素访问,而ArrayList支持。快速随机访问就是通过元素的序号快速获取元素对象(对应于get(int index)方法)。 - 内存空间占用:

ArrayList的空 间浪费主要体现在在 list 列表的结尾会预留一定的容量空间,而LinkedList的空间花费则体现在它的每一个元素都需要消耗比ArrayList更多的空间(因为要存放直接后继和直接前驱以及数据)。

Java为数据结构中的映射定义了一个接口java.util.Map,此接口主要有四个常用的实现类,分别是HashMap、Hashtable、LinkedHashMap和TreeMap,类继承关系如下图所示:

HashMap:它根据键的hash code值存储数据,大多数情况下可以直接定位到它的值,因而具有很快的访问速度,但遍历顺序却是不确定的。HashMap最多只允许一条记录的键为null,允许多条记录的值为null。HashMap非线程安全,即任一时刻可以有多个线程同时写HashMap,可能会导致数据的不一致。如果需要满足线程安全,可以用Collections的synchronizedMap方法使HashMap具有线程安全的能力,或者使用ConcurrentHashMap。

Hashtable:Hashtable是遗留类,很多映射的常用功能与HashMap类似,不同的是它承自Dictionary类,并且是线程安全的,任一时间只有一个线程能写Hashtable,并发性不如ConcurrentHashMap,因为ConcurrentHashMap引入了分段锁。Hashtable不建议在新代码中使用,不需要线程安全的场合可以用HashMap替换,需要线程安全的场合可以用ConcurrentHashMap替换。LinkedHashMap:LinkedHashMap是HashMap的一个子类,==保存了记录的插入顺序==,在用Iterator遍历LinkedHashMap时,先得到的记录肯定是先插入的,也可以在构造时带参数,按照访问次序排序。TreeMap:TreeMap实现SortedMap接口,能够把它保存的记录==根据键排序==,默认是按键值的升序排序,也可以指定排序的比较器,当用Iterator遍历TreeMap时,得到的记录是排过序的。如果使用排序的映射,建议使用TreeMap。在使用TreeMap时,key必须实现Comparable接口或者在构造TreeMap传入自定义的Comparator,否则会在运行时抛出java.lang.ClassCastException类型的异常。

总结:

- 结构上:数组 table + 链表 + 红黑树,其中加红黑树是为了提高拉链太长的参训效率

- 其他:

红黑树:是一种含有红黑结点并能自平衡的二叉查找树,详细讲解:https://www.jianshu.com/p/e136ec79235c

HashMap和ConcurrentMap详解:https://blog.csdn.net/weixin_44460333/article/details/86770169

总结:

重要结构:

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4;

static final int MAXIMUM_CAPACITY = 1 << 30;

- Node<K,V> table 简称hash数组:

- LoadFactor :loadFactor 太大导致查找元素效率低,太小导致数组的利用率低,存放的数据会很分散。loadFactor 的默认值为 0.75f 是官方给出的一个比较好的临界值。

- threshold = capacity \* loadFactor,当 Size>=threshold的时候,那么就要考虑对数组的扩增了,也就是说,这个的意思就是 衡量数组是否需要扩增的一个标准。

-

hashcode 方法:注意key不可变,可变的key会使得HashCode的值有变化,存储时利用Key计算获取的桶的位置,和获取时根据(变化后的Key)计算的Hashcode的值不一致,从而获取不到。

-

1.7和1.8put方法对比:

- 1.7:先遍历链表,如果不存在,再用头插法;如果存在,就直接替换。

- 1.8:采取尾插法的方式。

- 如果新增元素,链表>8且size>64要红黑树化,少语一定元素又退回链表;如果超过threshold要数组扩容resize()

-

get方法:

-

扩容resize:

- O(n):进行扩容,会伴随着一次重新 hash 分配,并且会遍历 hash 表中所有的元素,是非常耗时的。在编写程序中,要尽量避免 resize。

- 扩容和红黑树的好处:get,put的时间效率接近O(1),不会因为拉链太长,而降低时间复杂度。

-

什么时候转红黑树:当链表长度大于阈值(默认为 8)并且 HashMap 数组长度超过 64 的时候才会执行链表转红黑树的操作,否则就只是对数组扩容。

-

HashMap为什么不是线程安全的?

https://stackoverflow.com/questions/18542037/how-to-prove-that-hashmap-in-java-is-not-thread-safe

主要是在PUT操作是,两个并发的线程可能会造成如下问题:

- 线程A,B。A插入Table[i] = null,直接写入时,A阻塞。线程B的key.hashcode()与A一样,也写入这个Table[i]位置,会造成覆盖问题。

- 线程A在扩容resize()时,在还没有复制不完全时,线程B来get(key),在新数组还未完成copy时,get已存在的key,但值为null,

- 线程AB,都插入元素。AB都要扩容时,A先完成扩容,这是B可能会因为造成循环链表

put元素的流程?

说明:上图有两个小问题:

- 直接覆盖之后应该就会 return,不会有后续操作。参考 JDK8 HashMap.java 658 行(issue#608)。

- 当链表长度大于阈值(默认为 8)并且 HashMap 数组长度超过 64 的时候才会执行链表转红黑树的操作,否则就只是对数组扩容。参考 HashMap 的

treeifyBin()方法(issue#1087)。

资源:

- ConcurrentMap JavaGuide:https://snailclimb.gitee.io/javaguide/#/docs/java/collection/ConcurrentHashMap%E6%BA%90%E7%A0%81+%E5%BA%95%E5%B1%82%E6%95%B0%E6%8D%AE%E7%BB%93%E6%9E%84%E5%88%86%E6%9E%90

- 红黑树详解:https://www.jianshu.com/p/e136ec79235c

- HashMap和ConcurrentMap详解:https://blog.csdn.net/weixin_44460333/article/details/86770169

- HashMap的扩容机制:https://blog.csdn.net/lky5387/article/details/103042972

- HashMap为什么不是线程安全的:https://blog.csdn.net/weixin_43092168/article/details/89791106

video : https://www.bilibili.com/video/BV17i4y1x71z?from=search&seid=16806543830211878358

结构:1.7 Segment 数组 + HashEntry 数组 + 链表,用 concurrencyLevel 实现的分段锁,而1.8 是 Node 数组 + 链表 / 红黑树。

如何线程安全:1.7 是分段锁每一个 Segment 上同时只有一个线程可以操作,1.8是 Synchronized + CAS + 自旋保证安全的

| 类型 | 字节 |

|---|---|

| int | 4 |

| short | 2 |

| long | 8 |

| byte | 1 |

| char | 2 |

int最大值大约2*10^9

INT_MAX:0X7FFFFFFF

INT_MIN:0X7FFFFFFF+1 或 0X80000000

JAVA类型范围与机器无关,这是与C++的区别。

JAVA没有无符号数类型。

JAVA中0不能转false,所以不能写while(1)这种东西。

在Java中,只有基本类型不是对象,例如,数值、字符和布尔类型的值都不是对象。所有的数组类型,不管是对象数组还是基本类型的数组都扩展了Object类。

double x = 1.2;

int y = (int) x;Java字符串是不可变的。优点:字符串共享。缺点:更改效率低。

用equals方法检测两个字符串是否相等。因为==符号只能确定两个字符串是否放在同一个位置上。

如果要构建一个经常需要改变的字符串,应该使用StringBuilder类。StringBuffer类是线程安全的StringBuilder类。

BigInteger:任意精度的整数

BigDecimal:任意精度的浮点数

使用valueOf方法将普通数值转换为大数值:

BigInteger a = BigInteger.valueOf(100);大数值不能使用传统的运算符,而要使用add和multiply方法。

用final定义常量,习惯上将常量名全部大写。(const是关键字,但是目前并没有使用。)

用final定义的对象变量,只是表示该对象变量不会更改引用,但是这个对象本身是可以改变的。

用final定义的类,不允许被继承。

用final定义的方法,不允许被覆盖。

静态域:即使没有一个instance,静态域也存在,因为它属于类,而不属于任何独立的对象。

静态方法:静态方法是一种不能向对象实施操作的方法。

静态方法不使用任何instance,换句话说,没有隐式的参数。可以认为静态方法是没有this参数的方法。

静态方法不能访问实例域,因为它不能操作对象。但是,静态方法可以访问自身类中的静态域。

不需要使用对象调用静态方法。

public class Bark {

public static void main(String[] args) {

Father father = new Father();

Father fs = new Son();

Son son = new Son();

father.stcSay(); //static father

father.say(); //father

fs.stcSay(); //static father

fs.say(); //son

son.stcSay(); //static son

son.say(); //son

}

}

class Father {

public static void stcSay() {

System.out.println("static father");

}

public void say() {

System.out.println("father");

}

}

class Son extends Father {

public static void stcSay() {

System.out.println("static son");

}

public void say() {

System.out.println("Son");

}

}对于static修饰的变量,当子类与父类中存在相同的static变量时,是根据“静态引用”而不是根据“动态引用”来调用相应的变量的!换句话说,static是跟着类本身走的,而不是跟着实例走的。static修饰的内容只看你的声明是什么,而不管你的实现是什么。

总结:

- 子类是不继承父类的static变量和方法的。因为这是属于类本身的。但是子类是可以访问的。

- 子类和父类中同名的static变量和方法都是相互独立的,并不存在任何的重写的关系。

- Father f = new Son;f.staticMethod,是用的父类的方法

方法参数:JAVA永远使用值传递!

在一个类的声明中,可以包含多个代码块。只要构造类的对象,这些块就会被执行。

无论使用哪个构造器构造对象,域都在对象初始化块中被先初始化。

首先运行初始化块,然后才运行构造器的主体部分。

JAVA只有方法重载,没有操作符重载。

函数签名:函数名+参数类型。

重载一个方法,需要函数名相同,参数类型不同。与返回值无关。

抽象是从众多的事物中抽取出共同的、本质性的特征,而舍弃其非本质的特征。

抽象用 abstract 关键字来修饰,用 abstract 修饰类时,此类就不能被实例化,从这里可以看出,抽象类就是为了继承而存在的。

覆盖

JAVA中所有的继承都是公有继承,没有C++中的私有继承和保护继承。

**子类会继承父类的private域和方法,但是不能访问。**同样,子类也不能覆盖父类的private方法。

class Father{

private say(){

System.out.println("I'm father");

}

public f(){

say();

}

}

class Child extends Father{

//可以定义。并无覆盖。

private say(){

System.out.println("I'm child");

}

public c(){

say();

}

}

public class Test{

public static void main(String[] args){

Father father = new Father();

Child child = new Child();

father.f(); //I'm father

child.f(); //I'm father 表明子类中继承了父类的say方法

child.c(); //I'm child

}

}在覆盖一个方法的时候,子类不能低于父类的可见性。

使用super关键字指示编译器调用父类方法。int a = super.getSalary();

或者

使用super关键字表示调用父类的构造函数。

如果子类的构造函数没有显式地调用父类的构造函数,则将自动地调用父类默认(没有参数)的构造函数。

如果父类没有不带参数的构造函数,并且在子类的构造函数中又没有显式地调用父类的其他构造函数,则Java编译器将报告错误。

父类或接口定义的引用变量可以指向子类或具体实现类的实例对象。提高了程序的拓展性。

根据何时确定执行多态方法中的哪一个,多态分为两种情况:编译时多态和运行时多态。如果在编译时能够确定执行多态方法中的哪一个,称为编译时多态,否则称为运行时多态。

-

编译时多态

方法重载都是编译时多态。根据实际参数的数据类型、个数和次序,在编译时能够确定执行重载方法中的哪一个。

-

运行时多态

方法覆盖表现出两种多态性,当对象引用本类实例时,为编译时多态,否则为运行时多态。

父类型可以引用子类型,子类型不可以引用父类型。换句话说,不支持类的向下转型。

Son son = new Parent(); //不合法一个instance可以调用哪些方法,是由其声明类型决定的。而其调用的是哪个class的方法,是由其实际类型决定的。Father f = new Son();即使f实际是Son类的实例,但是只能在其上调用Father类定义的方法。但是调用某个方法之后,如果该方法被Son类覆盖过,那么实际调用的就是Son类的该方法。

总结:

- 封装:隐藏对象的属性和实现细节,仅对外提供公共访问方式,将变化隔离,便于使用,提高复用性和安全性。

- 继承:提高代码复用性;继承是多态的前提。

Object 是 Java 中所有类的基类,位于java.lang包。

Objects 是 Object 的工具类,位于java.util包。它从jdk1.7开始才出现,被final修饰不能被继承,拥有私有的构造函数。它由一些静态的实用方法组成,这些方法是空指针安全的,用于计算对象的hash code、返回对象的字符串表示形式、比较两个对象。

- 默认的equals方法只检测两个对象的地址是否相等。

- 需要自行覆盖,请看

public class Employee{

@Override // 为显式参数是Employee,并没有覆盖Object类的equals方法

public boolean equals(Object other){

if(getClass() != otherObject.getClass()) return false;

// other

}

}散列码(hash code)是由对象导出的一个整型值。

如果要将用户自定义类作为散列表的key值,必须重新定义equals方法和hashCode方法。

组合多个散列值时,可以调用Objects.hash并提供多个参数。这个方法会对各个参数调用Objects.hashCode,并组合这些散列值:

public class Employee{

public int hashCode(){

return Objects.hash(name, salary, hireDay);

}

}

Equals与hashCode的定义必须一致:

- 如果

x.equals(y)返回true,那么x.hashCode()就必须与y.hashCode()具有相同的值。 - 如果存在数组类型的域,那么可以使用静态的

Arrays.hashCode方法计算散列码。

只要对象与一个字符串通过操作符“+”连接起来,Java编译就会自动地调用toString方法,以便获得这个对象的字符串描述。

println方法会调用toString(),并打印输出得到的字符串。

Object类默认的toString方法,会打印对象所属的类名和散列码。

强烈建议为自定义的每一个类增加toString方法。这样做不仅自己受益,而且所有使用这个类的程序员也会从这个日志记录支持中受益匪浅。

基本数据类型:==比较的是值

引用数据类型:==比较的是内存地址

hashCode() 和 equals()

Object 的 hashcode 方法是本地方法,也就是用 c 语言或 c++ 实现的,该方法通常用来将对象的 内存地址 转换为整数之后返回.

public native int hashCode();

引用类型中,equals()相等 和 hashCode()相等情况比较:

- equas()等,是真的等

- hashCode相等:不一定是真的相等,毕竟是hash过来的。不过的值,可能有同一个Hash

Byte,Short,Integer,Long,Character,Boolean;前面 4 种包装类默认创建了数值[-128,127] 的相应类型的缓存数据,Character 创建了数值在[0,127]范围的缓存数据,Boolean 直接返回 True Or False

注意 基本类型中的真new 和 假 new问题

- Integer i1=40;Java 在编译的时候会直接将代码封装成 Integer i1=Integer.valueOf(40);,从而使用常量池中的对象。假new

Integer i1 = 40;

Integer i5 = new Integer(40);

Integer i6 = new Integer(0);

System.out.println("i4=i5+i6 " + (i4 == i5 + i6));

- Integer i1 = new Integer(40);这种情况下会创建新的对象。真new

(override)重写就是当子类继承自父类的相同方法,输入数据一样,但要做出有别于父类的响应时,你就要覆盖父类方法

(overload)重载就是同样的一个方法能够根据输入数据的不同,做出不同的处理

- 浅拷贝:对基本数据类型进行值传递,对引用数据类型进行引用传递般的拷贝,此为浅拷贝。

- 深拷贝:对基本数据类型进行值传递,对引用数据类型,创建一个新的对象,并复制其内容,此为深拷贝。

顾名思义,表示一个对象具有多种的状态。具体表现为父类的引用指向子类的实例。多态的特点:

- 对象类型和引用类型之间具有继承(类)/实现(接口)的关系;

- 引用类型变量发出的方法调用的到底是哪个类中的方法,必须在程序运行期间才能确定;

- 多态不能调用“只在子类存在但在父类不存在”的方法;

- 如果子类重写了父类的方法,真正执行的是子类覆盖的方法,如果子类没有覆盖父类的方法,执行的是父类的方法。

- 受检异常:除了RuntimeException以外的异常,都属于checkedException,它们都在java.lang库内部定义。Java编译器要求程序必须捕获或声明抛出这种异常。

- 非受检异常:ClassNotFoundException, NullPointerException等等

建议读码:***

教程:反射狂神

反射类型:

- 静态编译:在编译时确定类型,绑定对象

- 动态编译:运行时确定类型,绑定对象。比如反射机制

常用场景:

A. 在JDBC 的操作中,如果要想进行数据库的连接,Class.forName()加载数据库的驱动。

B. Spring 通过 XML 配置模式装载 Bean 的过程:

反射应用场景详细:

A. 在JDBC 的操作中,如果要想进行数据库的连接,则必须按照以上的几步完成

- 通过Class.forName()加载数据库的驱动程序 (通过反射加载,前提是引入相关了Jar包)

B. Spring 通过 XML 配置模式装载 Bean 的过程:

- 将程序内所有 XML 或 Properties 配置文件加载入内存中

- Java类里面解析xml或properties里面的内容,得到对应实体类的字节码字符串以及相关的属性信息

- 使用反射机制,根据这个字符串获得某个类的Class实例

- 动态配置实例的属性

Spring这样做的好处是:

- 不用每一次都要在代码里面去new或者做其他的事情

- 以后要改的话直接改配置文件,代码维护起来就很方便了

- 有时为了适应某些需求,Java类里面不一定能直接调用另外的方法,可以通过反射机制来实现

- 通过对象获得

- 通过Class.forname()

- 通过类名.class获得

用类加载过程来说明:

代码案例:

package com.reflection;

public class ClassLoaderTime {

public static void main(String[] args) {

// 1 主动引用的情况

// Son a = new Son();

// 反射也会主动引用,先加载父类,在加载之类

// Class aClass = Class.forName("com.reflection.ClassLoaderTime");

// 2 不会产生类的引用

// 访问父类的 静态域

// System.out.println(Son.b);

// 数组定义的类,不会引发类的引用

// Son[] son = new Son[5];

// 常量不会引起 类的引用

// System.out.println(Son.FINAL_N);

}

}

class Father{

static int b = 2;

static {

System.out.println("父类被加载!");

}

}

class Son extends Father{

static {

System.out.println("子类被加载 --- 链接阶段执行的");

m = 300;

}

static int m = 100;

static final int FINAL_N = 999;

public Son(){

System.out.println("A类 无参构造 初始化");

}

}反射调用:比较慢

反射调用:关闭权限检查 getName.setAccessible(true); 会好很多。

package com.reflection;

import org.springframework.context.support.ClassPathXmlApplicationContext;

import java.lang.reflect.InvocationTargetException;

import java.lang.reflect.Method;

public class ReflectionTime {

public static void test01(){

User user = new User();

long startTime = System.currentTimeMillis();

for (int i = 0; i < 10000000; i++) {

user.getName();

}

long endTime = System.currentTimeMillis();

System.out.println("普通 :" + (endTime - startTime) + "ms");

}

// 反射

public static void test02() throws InvocationTargetException, IllegalAccessException, NoSuchMethodException {

User user = new User();

Class c1 = user.getClass();

Method getName = c1.getDeclaredMethod("getName", null);

long startTime = System.currentTimeMillis();

for (int i = 0; i < 10000000; i++) {

getName.invoke(user, null);

}

long endTime = System.currentTimeMillis();

System.out.println("反射 :" + (endTime - startTime) + "ms");

}

// 反射 不检查权限

public static void test03() throws InvocationTargetException, IllegalAccessException, NoSuchMethodException {

User user = new User();

Class c1 = user.getClass();

Method getName = c1.getDeclaredMethod("getName", null);

getName.setAccessible(true); // 关不权限监测,就是getName如果是private,也是可以调用的

long startTime = System.currentTimeMillis();

for (int i = 0; i < 10000000; i++) {

getName.invoke(user, null);

}

long endTime = System.currentTimeMillis();

System.out.println("反射(不检查权限) :" + (endTime - startTime) + "ms");

}

public static void main(String[] args) throws IllegalAccessException, NoSuchMethodException, InvocationTargetException {

test01();

test02();

test03();

}

}

// 普通 :7ms

// 反射 :133ms

// 反射(不检查权限) :42mspackage com.reflection;

import java.lang.reflect.Method;

import java.lang.reflect.ParameterizedType;

import java.lang.reflect.Type;

import java.util.List;

import java.util.Map;

// 通过反射 获取泛型

public class GetTypeByReflection {

public void test01(Map<String, User> map, List<User> list){

System.out.println("test01");

}

public Map<String, User> test02(){

System.out.println("test02");

return null;

}

public static void main(String[] args) throws NoSuchMethodException {

Method method = GetTypeByReflection.class.getMethod("test01", Map.class, List.class);

// 获取泛型参数化类型

Type[] genericParameterTypes = method.getGenericParameterTypes();

for (Type genericParameterType : genericParameterTypes) {

System.out.println("# genericParameterType: " + genericParameterType);

// 对每一个参数,如果是参数化类型,就获取真实的类型

if(genericParameterType instanceof ParameterizedType){

Type[] actualTypeArguments = ((ParameterizedType) genericParameterType).getActualTypeArguments();

for (Type actualTypeArgument : actualTypeArguments) {

System.out.println("# actualTypeArgument: " +actualTypeArgument);

}

}

}

System.out.println(" =============================== ");

method = GetTypeByReflection.class.getMethod("test02", null);

Type genericReturnType = method.getGenericReturnType();

if(genericReturnType instanceof ParameterizedType){

Type[] actualTypeArguments = ((ParameterizedType) genericReturnType).getActualTypeArguments();

for (Type actualTypeArgument : actualTypeArguments) {

System.out.println("# actualTypeArgument: " +actualTypeArgument);

}

}

}

}

// # genericParameterType: java.util.Map<java.lang.String, com.reflection.User>

// # actualTypeArgument: class java.lang.String

// # actualTypeArgument: class com.reflection.User

// # genericParameterType: java.util.List<com.reflection.User>

// # actualTypeArgument: class com.reflection.User

// ===============================

// # actualTypeArgument: class java.lang.String

// # actualTypeArgument: class com.reflection.User参考代码:

高能预警,本文是我一个月前就开始写的,所以内容会非常长,当然也非常硬核,dubbo源码系列结束之后我就想着写一下netty系列的,但是netty的源码概念又非常多,所以才写到了现在。

我相信90%的读者都不会一口气看完的,因为实在太长了,长到我现在顶配的mbp打字编辑框都是卡的,但是我希望大家日后想看netty或者在面试前需要了解的朋友回头翻一下就够了,那我写这个文章的意义也就有了。

也不多BB,直接开整。

BIO:阻塞IO

NIO:非阻塞IO,client注册channel,channel注册到选择器,服务端的线程,通过selector来处理多个IO请求,而不必自己像阻塞IO一样阻塞、或者轮训去管理多个IO 请求,IO复用的方式提高了利用率。

todo: NIO 编程

BIO (Blocking I/O): 同步阻塞 I/O 模式,数据的读取写⼊必须阻塞在⼀个线程内等待其完成。在活动连接数不是特别⾼(⼩于单机 1000)的情况下,这种模型是⽐不错的,可以让每⼀个连接专注于⾃⼰的 I/O 并且编程模型简单,也不⽤过多考虑系统的过载、限流等问题。线程池本身就是⼀个天然的漏⽃,可以缓冲⼀些系统处理不了的连接或请求。但是,当⾯对⼗万甚⾄百万级连接的时候,传统的 BIO 模型是⽆能为⼒的。因此,我们需要⼀种更⾼效的 I/O 处理模型来应对更⾼的并发量。

NIO (Non-blocking/New I/O): NIO 是⼀种同步⾮阻塞的 I/O 模型,在 Java 1.4 中引⼊了NIO 框架,对应 java.nio 包,提供了 Channel , Selector,Buffer 等抽象。NIO 中的 N 可以理解为 Non-blocking,不单纯是 New。它⽀持⾯向缓冲的,基于通道的 I/O 操作⽅法。 NIO提供了与传统 BIO 模型中的 Socket 和 ServerSocket 相对应的 SocketChannel 和ServerSocketChannel 两种不同的套接字通道实现,两种通道都⽀持阻塞和⾮阻塞两种模式。阻塞模式使⽤就像传统中的⽀持⼀样,⽐简单,但是性能和可靠性都不好;⾮阻塞模式正好与之相反。对于低负载、低并发的应⽤程序,可以使⽤同步阻塞 I/O 来提升开发速率和更好的维护性;对于⾼负载、⾼并发的(⽹络)应⽤,应使⽤ NIO 的⾮阻塞模式来开发

AIO (Asynchronous I/O): AIO 也就是 NIO 2。在 Java 7 中引⼊了 NIO 的改进版 NIO 2,它是

异步⾮阻塞的 IO 模型。异步 IO 是基于事件和回调机制实现的,也就是应⽤操作之后会直接返回,不会堵塞在那⾥,当后台处理完成,操作系统会通知相应的线程进⾏后续的操作。AIO 是异步 IO 的缩写,虽然 NIO 在⽹络操作中,提供了⾮阻塞的⽅法,但是 NIO 的 IO ⾏为还是同步的。对于 NIO 来说,我们的业务线程是在 IO 操作准备好时,得到通知,接着就由这个线程⾃⾏进⾏ IO 操作,IO 操作本身是同步的。查阅⽹上相关资料,我发现就⽬前来说 AIO 的应⽤还不是很⼴泛,Netty 之前也尝试使⽤过 AIO,不过⼜放弃了。

参考:

Todo 敖丙肝了一个月的Netty知识点:https://mp.weixin.qq.com/s/I9PGsWo7-ykGf2diKklGtA

NIO听课:尚硅谷的NIO教程dddd

在C++中,通常在类的外面定义方法,如果在类的内部定义方法,这个方法将自动地成为内联(inline)方法。在Java中,所有的方法都必须在类的内部定义,但并不表示它们是内联方法。是否将某个方法设置为内联方法是Java虚拟机的任务。

Scanner in = new Scanner(System.in);

String s = in.nextLine(); //读取一行

String name = in.next(); //读取一个单词(以空白符作为分隔符)

int i = in.nextInt(); //读取一个整形System.out.printf("%8.2f",x); //宽度为8,保留小数点后两位

System.out.printf("Hello, %s, next year you will be %d", name, age); //可以使用多个参数//文件输入输出

Scanner in = new Scanner(Path.get("c:\\myfile.txt"),"UTF-8");

PrintWriter out = new PrintWriter("outfile.txt","UTF-8");

javac Helloworld.java

java Helloworldjavac是编译指令,文件名要带上.java后缀。将源码文件编译为字节码(.class文件)。

java是运行指令,不要带.class后缀,因为java命令指定是类名。将字节码文件交给jvm开始运行。

如果键入java Helloworld,而虚拟机没有找到Helloworld类,就应该检查一下是否有人设置了系统的CLASSPATH环境变量(不推荐)。

volatile 关键字主要作用:

- 除了防止 JVM 的指令重排

- 还有一个重要的作用就是保证变量的可见性。

sun:

为了获得最佳速度,允许线程保存共享成员变量的私有拷贝,而且只当线程进入或者离开同步代码块时才与共享成员变量的原始值对比。这样当多个线程同时与某个对象交互时,就必须要注意到要让线程及时的得到共享成员变量的变化。 而volatile关键字就是提示VM:对于这个成员变量不能保存它的私有拷贝,而应直接与共享成员变量交互

并发变成重要特性:

- 原子性 : 一个的操作或者多次操作,要么所有的操作全部都得到执行并且不会收到任何因素的干扰而中断,要么所有的操作都执行,要么都不执行。synchronized 可以保证代码片段的原子性。

- 可见性 :当一个变量对共享变量进行了修改,那么另外的线程都是立即可以看到修改后的最新值。volatile 关键字可以保证共享变量的可见性。

- 有序性 :代码在执行的过程中的先后顺序,Java 在编译器以及运行期间的优化,代码的执行顺序未必就是编写代码时候的顺序。volatile 关键字可以禁止指令进行重排序优化。

- 两者最主要的区别在于:sleep() 方法没有释放锁,而 wait() 方法释放了锁 。

- 两者都可以暂停线程的执行。

- wait() 通常被用于线程间交互/通信,sleep() 通常被用于暂停执行。

- wait() 方法被调用后,线程不会自动苏醒,需要别的线程调用同一个对象上的 notify() 或者 notifyAll() 方法。sleep() 方法执行完成后,线程会自动苏醒。或者可以使用 wait(long timeout) 超时后线程会自动苏醒。

阅读:Java6及以上版本对synchronized的优化 - 吴庆龙的技术轮子 - 博客园

JVM基于进入和退出Monitor对象来实现方法同步和代码块同步, 但是两者的实现细节不一样.

- 代码块同步: 通过使用monitorenter和monitorexit指令实现的.

- 同步方法: ACC_SYNCHRONIZED修饰

具体点:

- synchronized 同步语句块:实现使用的是 monitorenter 和 monitorexit 指令,其中 monitorenter 指令指向同步代码块的开始位置,monitorexit 指令则指明同步代码块的结束位置。当执行 monitorenter 指令时,线程试图获取锁也就是获取 对象监视器 monitor 的持有权。并且在 Java 虚拟机(HotSpot)中,Monitor 是基于 C++实现的,由ObjectMonitor实现的。每个对象中都内置了一个 **ObjectMonitor**对象。

- synchronized 修饰的方法:并没有 monitorenter 指令和 monitorexit 指令,取得代之的确实是 ACC_SYNCHRONIZED 标识,该标识指明了该方法是一个同步方法。

- 不过两者的本质都是对对象监视器 monitor 的获取。

ThreadLocalMap 中使用的 key 为 ThreadLocal 的弱引用,而 value 是强引用。所以,如果 ThreadLocal 没有被外部强引用的情况下,在垃圾回收的时候,key 会被清理掉,而 value 不会被清理掉。这样一来,ThreadLocalMap 中就会出现 key 为 null 的 Entry。假如我们不做任何措施的话,value 永远无法被 GC 回收,这个时候就可能会产生内存泄露。ThreadLocalMap 实现中已经考虑了这种情况,在调用 set()、get()、remove() 方法的时候,会清理掉 key 为 null 的记录。使用完 ThreadLocal方法后 最好手动调用remove()方法

Sun:

ThreadLocal.set()、get()一般和remove()一起使用

实现 Runnable 接口和 Callable 接口的区别

Runnable自 Java 1.0 以来一直存在,但Callable仅在 Java 1.5 中引入,目的就是为了来处理Runnable不支持的用例。Runnable 接口不会返回结果或抛出检查异常,但是Callable 接口可以。所以,如果任务不需要返回结果或抛出异常推荐使用 ****Runnable 接口,这样代码看起来会更加简洁

- Callable规定的方法是call(),而Runnable规定的方法是run()。

- Callable的任务执行后可返回值,而Runnable的任务是不能返回值的。

- call()方法可抛出异常,而run()方法是不能抛出异常的。

- 运行Callable任务可拿到一个Future对象, Future表示异步计算的结果。

- 它提供了检查计算是否完成的方法,以等待计算的完成,并检索计算的结果。

- 通过Future对象可了解任务执行情况,可取消任务的执行,还可获取任务执行的结果。

- Callable是类似于Runnable的接口,实现Callable接口的类和实现Runnable的类都是可被其它线程执行的任务。

FutureTask包装器是一种非常便利的机制,可将Callable转换成Future和Runnable,它同时实现二者的接口。

Callable<Integer> myComputation = ...;

FutureTask<Integer> task = new FutureTask<Integer>(myComputation);

Thread t = new Thread(task); //task既是Runnable

t.start();

Integer result = task.get(); //task也是Future建议读:JUC 中的 Atomic 原子类总结 - 不懒人 - 博客园

CAS + ABA:CAS 比较与交换,在原子类中使用较多。ABA 是 :A线程获取oldValue, B线程获取到oldValue,但改成newValue后,又改回oldValue。A线程是察觉不到这个问题的,compareAndSet(expect, newValue)就还是成功的。

如何解决ABA问题:

- AtomicStampedReference

- AtomicMarkedReference

JavaGuide AQS详细讲解:1 AQS 简单介绍

Java并发之AQS详解 - waterystone - 博客园

Java并发包基石-AQS详解 - dreamcatcher-cx - 博客园

AQS 是一个用来构建锁和同步器的框架,使用 AQS 能简单且高效地构造出应用广泛的大量的同步器,比如我们提到的 ReentrantLock,Semaphore,其他的诸如 ReentrantReadWriteLock,SynchronousQueue,FutureTask 等等皆是基于 AQS 的。当然,我们自己也能利用 AQS 非常轻松容易地构造出符合我们自己需求的同步器。

使用原子类的好处:

- 本身就是原子的加,原子的减法。就不必再单独对一个操作进行加锁了

CyclicBarrier 用法

当调用 CyclicBarrier 对象调用 await() 方法时,实际上调用的是dowait(false, 0L)方法。 await() 方法就像树立起一个栅栏的行为一样,将线程挡住了,当拦住的线程数量达到 parties 的值时,栅栏才会打开,线程才得以通过执行。

CyclicBarrier 和 CountDownLatch 的区别:

多线程CountDownLatch和CyclicBarrier的区别 以及举例_paul342的专栏-CSDN博客

- CountDownLatch : 一个线程(或者多个), 等待另外N个线程完成某个事情之后才能执行

- CyclicBarrier : N个线程相互等待,任何一个线程完成之前,所有的线程都必须等待,然后都可以做其他事情了。强调某时刻同步一个状态

AQS总结:AQS就是基于CLH队列,用volatile修饰共享变量state,线程通过CAS去改变状态符,成功则获取锁成功,失败则进入等待队列,等待被唤醒。

Java并发之AQS详解:https://blog.csdn.net/mulinsen77/article/details/84583716

可重入锁(递归锁)+LockSupport+AQS源码分析:https://blog.csdn.net/TZ845195485/article/details/109210263

- 调用 start() 方法方可启动线程并使线程进入就绪状态,直接执行 run() 方法的话不会以多线程的方式执行

- 修饰代码块 :指定加锁对象,对给定对象/类加锁。synchronized(this|object) 表示进入同步代码库前要获得给定对象的锁。synchronized(类.class) 表示进入同步代码前要获得 当前 class 的锁

String,StringBuffer,stringBuilder的区别

- string是常量,StringBuffer是线程安全的,StringBuilder是线程不安全的

- 单线程:可以用StringBuilder进行字符串操作,效率高

- 多线程:一定要用StringBuffer,这个线程安全。

final逸出

写 final 域的重排序规则可以确保:在引用变量为任意线程可见 之前,该引用变量指向的对象的 final 域已经在构造函数中被正确初始化过了。其 实要得到这个效果,还需要一个保证:在构造函数内部,不能让这个被构造对象的 引用为其他线程可见,也就是对象引用不能在构造函数中“逸出”。我们来看下面示例代码:

public class FinalReferenceEscapeExample {

final int i;

static FinalReferenceEscapeExample obj;

public FinalReferenceEscapeExample () {

i = 1; //1 写 final 域

obj = this; //2 this 引用在此“逸出”

}

public static void writer() {

new FinalReferenceEscapeExample ();

}

public static void reader {

if (obj != null) { //3 犹豫线程B,执行到这,可能会因为1,2的指令重排层2,1,提前读obj, obj.i不就没有初始化吗

int temp = obj.i; //4

}

}

}

说明:假设一个线程 A 执行 writer()方法,另一个线程 B 执行 reader()方法。这里的操作 2 使得对象还未完成构造前就为线程 B 可见。即使这里的操作 2 是构造函数的最后一步,且即使在程序中操作 2 排在操作 1 后面,执行 read()方法的线程仍然可能无 法看到 final 域被初始化后的值,因为这里的操作 1 和操作 2 之间可能被重排序。实际的执行时序可能如下图所示:

说明:在构造函数返回前,被构造对象的引用不能为其他线程可见,因为此时的 final 域可能还没有被初始化。在构造函数返回后,任意线程都将保证能看到 final 域正确初始化之后的值。

为什么 syschoronized 实例可以访问实例的锁,实例还可以访问对象锁。

因为访问静态 synchronized 方法占用的锁是当前类的锁,而访问非静态 synchronized 方法占用的锁是当前实例对象锁。(https://blog.csdn.net/lkforce/article/details/81128115?utm_source=copy)

- 修饰实例⽅法: 作⽤于当前对象实例加锁,进⼊同步代码前要获得当前对象实例的锁

- 修饰静态⽅法: 也就是给当前类加锁,会作⽤于类的所有对象实例,因为静态成员不属于任何⼀ 个实例对象,是类成员( static 表明这是该类的⼀个静态资源,不管new了多少个对象,只有 ⼀份)。

- 所以如果⼀个线程A调⽤⼀个实例对象的⾮静态 synchronized ⽅法,

- ⽽线程B需要调⽤ 这个实例对象所属类的静态 synchronized ⽅法,是允许的,不会发⽣互斥现象

- 因为访问静态 synchronized ⽅法占⽤的锁是当前类的锁,⽽访问⾮静态 synchronized ⽅法占⽤的锁是当前 实例对象锁。

- 修饰代码块: 指定加锁对象,对给定对象加锁,进⼊同步代码库前要获得给定对象的锁。 总结: synchronized 关键字加到 static 静态⽅法和 synchronized(class)代码块上都是是给 Class 类上锁。synchronized 关键字加到实例⽅法上是给对象实例上锁。尽量不要使⽤ synchronized(String a) 因为JVM中,字符串常量池具有缓存功能!

进程管理:[进程状态的切换](http://www.cyc2018.xyz/计算机基础/操作系统基础/计算机操作系统 - 进程管理.html#进程状态的切换)

线程的5种状态详解:https://blog.csdn.net/xingjing1226/article/details/81977129

线程相关状态图

-

新建(NEW):新创建了一个线程对象。

-

可运行(RUNNABLE):线程对象创建后,其他线程(比如main线程)调用了该对象的start()方法。该状态的线程位于可运行线程池中,等待被线程调度选中,获取cpu 的使用权 。

-

运行(RUNNING):可运行状态(runnable)的线程获得了cpu 时间片(timeslice) ,执行程序代码。

-

阻塞(BLOCKED):阻塞状态是指线程因为某种原因放弃了cpu 使用权,也即让出了cpu timeslice,暂时停止运行。直到线程进入可运行(runnable)状态,才有机会再次获得cpu timeslice 转到运行(running)状态。阻塞的情况分三种:

(一). 等待阻塞:运行(running)的线程执行o.wait()方法,JVM会把该线程放入等待队列(waitting queue)中。 (二). 同步阻塞:运行(running)的线程在获取对象的同步锁时,若该同步锁被别的线程占用,则JVM会把该线程放入锁池(lock pool)中。 (三). 其他阻塞:运行(running)的线程执行Thread.sleep(long ms)或t.join()方法,或者发出了I/O请求时,JVM会把该线程置为阻塞状态。当sleep()状态超时、join()等待线程终止或者超时、或者I/O处理完毕时,线程重新转入可运行(runnable)状态。

- 死亡(DEAD):线程run()、main() 方法执行结束,或者因异常退出了run()方法,则该线程结束生命周期。死亡的线程不可再次复生。

==线程之挂起、睡眠、阻塞、等待==

调用 Thread.sleep() 方法使线程进入限期等待状态时,常常用“使一个线程睡眠”进行描述。

调用 Object.wait() 方法使线程进入限期等待或者无限期等待时,常常用“挂起一个线程”进行描述。

睡眠和挂起是用来描述行为,而阻塞和等待用来描述状态。

推荐看:https://juejin.im/post/6844903923116048397#heading-0

是什么:不同的线程可以访问相同的资源,而不会暴露出错误的行为或产生不可预知的结果。

-

无状态。线程本地没有需要同步的内容

-

不可变实现。线程本地变量,是不可变的,String.

-

线程本地变量。用ThreadLocal实现的每个线程,有独立的本地变量

-

同步集合,同1时间内,只有被1个线程访问。

-

并发集合。同步块,具体方式不清楚

-

原子对象。Java有原子类,用原子类(AtomicInteger/AtomicLong)等可以线程安全,如addAndGet(int delta)

-

synchronized 同步方法(function),用synchronized 标记方法。

-

public synchronized void incrementCounter() {synchronized 同步语句,用synchornozied标记语句。

-

Volatile变量,确保给定线程可见的所有变量也将从主存中读取。虽然用一些办法同步了,但你千万别从CPU缓存读,而不从内存中读,那就尴尬。完全 volatile 可见性保证???

-

外部锁定,解决了内部锁定可能被DOS的问题

-

Reentrantlock 锁机制,考虑了线程等待时间的锁

-

读写锁,考虑了只要没有人写,可以多个读。

- 降低资源消耗。通过重复利用已创建的线程降低线程创建和销毁造成的消耗。

- 提高响应速度。当任务到达时,任务可以不需要的等到线程创建就能立即执行。

- 提高线程的可管理性。线程是稀缺资源,如果无限制的创建,不仅会消耗系统资源,还会降低系统的稳定性,使用线程池可以进行统一的分配,调优和监控。

ThreadPoolExecutor 饱和策略定义:【代码+示例}】:https://www.jianshu.com/p/9fec2424de54

AbortPolicy

ThreadPoolExecutor中默认的拒绝策略就是AbortPolicy。直接抛出异常。

private static final RejectedExecutionHandler defaultHandler =

new AbortPolicy();下面是他的实现:

public static class AbortPolicy implements RejectedExecutionHandler {

public AbortPolicy() { }

public void rejectedExecution(Runnable r, ThreadPoolExecutor e) {

throw new RejectedExecutionException("Task " + r.toString() +

" rejected from " +

e.toString());

}

}很简单粗暴,直接抛出个RejectedExecutionException异常,也不执行这个任务了。

测试

先自定义一个Runnable,给每个线程起个名字,下面都用这个Runnable

static class MyThread implements Runnable {

String name;

public MyThread(String name) {

this.name = name;

}

@Override

public void run() {

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("线程:"+Thread.currentThread().getName() +" 执行:"+name +" run");

}

}然后构造一个核心线程是1,最大线程数是2的线程池。拒绝策略是AbortPolicy

ThreadPoolExecutor executor = new ThreadPoolExecutor(1, 2, 0,

TimeUnit.MICROSECONDS,

new LinkedBlockingDeque<Runnable>(2),

new ThreadPoolExecutor.AbortPolicy());for (int i = 0; i < 6; i++) {

System.out.println("添加第"+i+"个任务");

executor.execute(new MyThread("线程"+i));

Iterator iterator = executor.getQueue().iterator();

while (iterator.hasNext()){

MyThread thread = (MyThread) iterator.next();

System.out.println("列表:"+thread.name);

}

}输出是:

分析一下过程。

- 添加第一个任务时,直接执行,任务列表为空。

- 添加第二个任务时,因为采用的LinkedBlockingDeque,,并且核心线程正在执行任务,所以会将第二个任务放在队列中,队列中有 线程2.

- 添加第三个任务时,也一样会放在队列中,队列中有 线程2,线程3.

- 添加第四个任务时,因为核心任务还在运行,而且任务队列已经满了,所以胡直接创建新线程执行第四个任务,。这时线程池中一共就有两个线程在运行了,达到了最大线程数。任务队列中还是有线程2, 线程3.

- 添加第五个任务时,再也没有地方能存放和执行这个任务了,就会被线程池拒绝添加,执行拒绝策略的rejectedExecution方法,这里就是执行AbortPolicy的rejectedExecution方法直接抛出异常。

- 最终,只有四个线程能完成运行。后面的都被拒绝了。

CallerRunsPolicy

CallerRunsPolicy在任务被拒绝添加后,会调用当前线程池的所在的线程去执行被拒绝的任务。

下面说他的实现:

public static class CallerRunsPolicy implements RejectedExecutionHandler {

public CallerRunsPolicy() { }

public void rejectedExecution(Runnable r, ThreadPoolExecutor e) {

if (!e.isShutdown()) {

r.run();

}

}

}也很简单,直接run。

测试

ThreadPoolExecutor executor = new ThreadPoolExecutor(1, 2, 30,

TimeUnit.SECONDS,

new LinkedBlockingDeque<Runnable>(2),

new ThreadPoolExecutor.AbortPolicy());按上面的运行,输出

注意在添加第五个任务,任务5 的时候,同样被线程池拒绝了,因此执行了CallerRunsPolicy的rejectedExecution方法,这个方法直接执行任务的run方法。因此可以看到任务5是在main线程中执行的。

从中也可以看出,因为第五个任务在主线程中运行,所以主线程就被阻塞了,以至于当第五个任务执行完,添加第六个任务时,前面两个任务已经执行完了,有了空闲线程,因此线程6又可以添加到线程池中执行了。

这个策略的缺点就是可能会阻塞主线程。

线程池-Demo 代码

import java.util.Date;

/**

* 这是⼀个简单的Runnable类,需要⼤约5秒钟来执⾏其任务。

* @author shuang.kou

*/

public class MyRunnable implements Runnable {

private String command;

public MyRunnable(String s) {

this.command = s;

}

@Override

public void run() {

System.out.println(Thread.currentThread().getName() + " Start.Time = " + new Date());

processCommand();

System.out.println(Thread.currentThread().getName() + " End.Time = " + newDate());

}

private void processCommand() {

try {

Thread.sleep(5000);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

@Override

public String toString() {

return this.command;

}

}import java.util.concurrent.ArrayBlockingQueue;

import java.util.concurrent.ThreadPoolExecutor;

import java.util.concurrent.TimeUnit;

public class ThreadPoolExecutorDemo {

private static final int CORE_POOL_SIZE = 5;

private static final int MAX_POOL_SIZE = 10;

private static final int QUEUE_CAPACITY = 100;

private static final Long KEEP_ALIVE_TIME = 1L;

public static void main(String[] args) {

//使⽤阿⾥巴巴推荐的创建线程池的⽅式

//通过ThreadPoolExecutor构造函数⾃定义参数创建

ThreadPoolExecutor executor = new ThreadPoolExecutor(

CORE_POOL_SIZE,

MAX_POOL_SIZE,

KEEP_ALIVE_TIME,

TimeUnit.SECONDS,

new ArrayBlockingQueue<>(QUEUE_CAPACITY),

new ThreadPoolExecutor.CallerRunsPolicy());

for (int i = 0; i < 10; i++) {

//创建WorkerThread对象(WorkerThread类实现了Runnable 接⼝)

Runnable worker = new MyRunnable("" + i);

//执⾏Runnable

executor.execute(worker);

}

//终⽌线程池

executor.shutdown();

while (!executor.isTerminated()) {

}

System.out.println("Finished all threads");

}

}-

并发:是执行不同的任务,使得程序能够提供不同的功能

-

并行:是执行相同的任务,通过多核CPU,能够提高同样任务的处理效率。

- 实现Runnable接口

Runnable r = ()->{task code;}

Thread t = new Thread(r);

t.start()- 继承Thread类

class MyThread extends Thread{

public void run(){

// task code;

}

}

MyThread t = new MyThread();

t.start(); - 实现Callable接口

Class MyCallble implements Callble<Integer>{

public Integer call(){

// task code;

}

}

MyCallble mc = new MyCallble();

Thread t = new Thread(mc);

t.start();构建一个新的线程是有一定代价的,因为涉及与操作系统的交互。如果程序中创建了大量的生命期很短的线程,应该使用线程池(thread pool)。

一个线程池中包含许多准备运行的空闲线程。将Runnable对象交给线程池,就会有一个线程调用run方法。当run方法退出时,线程不会死亡,而是在池中准备为下一个请求提供服务。

另一个使用线程池的理由是减少并发线程的数目。创建大量线程会大大降低性能甚至使虚拟机崩溃。如果有一个会创建许多线程的算法,应该使用一个线程数“固定的”线程池以限制并发线程的总数。

执行器(Executor)类有许多静态工厂方法用来构建线程池。

- newCachedThreadPool:构建了一个线程池,对于每个任务,如果有空闲线程可用,立即让它执行任务,如果没有可用的空闲线程,则创建一个新线程。

- newFixedThreadPool:构建一个具有固定大小的线程池。如果提交的任务数多于空闲的线程数,那么把得不到服务的任务放置到队列中。当其他任务完成以后再运行它们。

- newSingleThreadExecutor:是一个退化了的大小为1的线程池:由一个线程执行提交的任务,一个接着一个。

- newScheduledThreadPool:

- newSingleThreadScheduledExecutor:

前3个方法返回实现了ExecutorService接口的ThreadPoolExecutor类的对象。

可用下面的submit方法之一将一个Runnable对象或Callable对象提交给ExecutorService,调用submit时,会得到一个Future对象,可用来查询该任务的状态。

Future<?> submit(Runnable task)

Future<T> submit(Runnable task, T result)

Future<T> submit(Callable<T> task)-

Future<?> submit(Runnable task)这个submit方法返回一个奇怪样子的

Future<?>。可以使用这样一个对象来调用isDone、cancel或isCancelled。但是,get方法在完成的时候只是简单地返回null。 -

Future<T> submit(Runnable task, T result)这个版本的Submit也提交一个Runnable,并且Future的get方法在完成的时候返回指定的result对象。

-

Future<T> submit(Callable<T> task)这个版本的Submit提交一个Callable,并且返回的Future对象将在计算结果准备好的时候得到它。

当用完一个线程池的时候,调用shutdown。该方法启动该池的关闭序列。被关闭的执行器不再接受新的任务。当所有任务都完成以后,线程池中的线程死亡。另一种方法是调用shutdownNow。该池取消尚未开始的所有任务并试图中断正在运行的线程。

后两个方法将返回实现了Scheduled-ExecutorService接口的对象。ScheduledExecutorService接口具有为预定执行或重复执行任务而设计的方法。

可以预定Runnable或Callable在初始的延迟之后只运行一次。也可以预定一个Runnable对象周期性地运行。

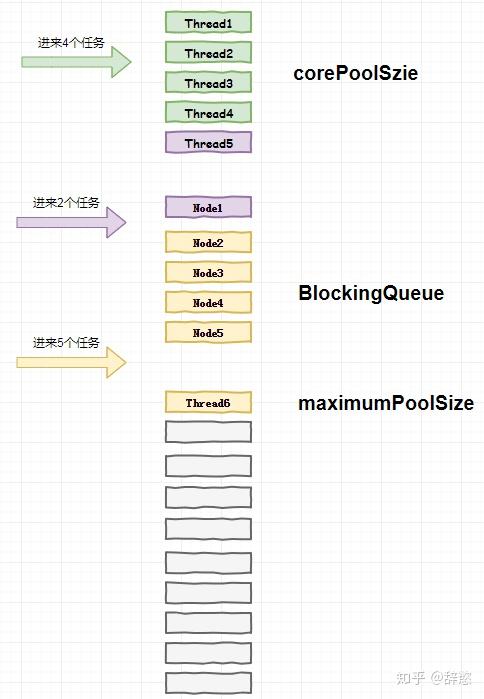

现有一个线程池,参数corePoolSize = 5,maximumPoolSize = 10,BlockingQueue阻塞队列长度为5,此时有4个任务同时进来,问:线程池会创建几条线程? 如果4个任务还没处理完,这时又同时进来2个任务,问:线程池又会创建几条线程还是不会创建? 如果前面6个任务还是没有处理完,这时又同时进来5个任务,问:线程池又会创建几条线程还是不会创建?

如果你此时一脸懵逼,请不要慌,问题不大。

创建线程池的构造方法的参数都有哪些?

要回答这个问题,我们需要从创建线程池的参数去找答案:

java.util.concurrent.ThreadPoolExecutor#ThreadPoolExecutor:

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue<Runnable> workQueue,

ThreadFactory threadFactory,

RejectedExecutionHandler handler) {

if (corePoolSize < 0 || maximumPoolSize <= 0 || maximumPoolSize < corePoolSize || keepAliveTime < 0)

throw new IllegalArgumentException();

if (workQueue == null || threadFactory == null || handler == null)

throw new NullPointerException();

this.acc = System.getSecurityManager() == null ? null : AccessController.getContext();

this.corePoolSize = corePoolSize;

this.maximumPoolSize = maximumPoolSize;

this.workQueue = workQueue;

this.keepAliveTime = unit.toNanos(keepAliveTime);

this.threadFactory = threadFactory;

this.handler = handler;

}创建线程池一共有7个参数,从源码可知,corePoolSize和maximumPoolSize都不能小于0,且核心线程数不能大于最大线程数。

下面我来解释一下这7个参数的用途:

- corePoolSize:线程池核心线程数量,核心线程不会被回收,即使没有任务执行,也会保持空闲状态。如果线程池中的线程少于此数目,则在执行任务时创建。

- maximumPoolSize:池允许最大的线程数,当线程数量达到corePoolSize,且workQueue队列塞满任务了之后,继续创建线程。

- keepAliveTime:超过corePoolSize之后的“临时线程”的存活时间。

- unit:keepAliveTime的单位。

- workQueue:当前线程数超过corePoolSize时,新的任务会处在等待状态,并存在workQueue中,BlockingQueue是一个先进先出的阻塞式队列实现,底层实现会涉及Java并发的AQS机制。

- threadFactory:创建线程的工厂类,通常我们会自定一个threadFactory设置线程的名称,这样我们就可以知道线程是由哪个工厂类创建的,可以快速定位。

- handler:线程池执行拒绝策略,当线数量达到maximumPoolSize大小,并且workQueue也已经塞满了任务的情况下,线程池会调用handler拒绝策略来处理请求。

系统默认的拒绝策略有以下几种:

- AbortPolicy:为线程池默认的拒绝策略,该策略直接抛异常处理。

- DiscardPolicy:直接抛弃不处理。

- DiscardOldestPolicy:丢弃队列中最老的任务。

- CallerRunsPolicy:将任务分配给当前执行execute方法线程来处理。

我们还可以自定义拒绝策略,只需要实现RejectedExecutionHandler接口即可,友好的拒绝策略实现有如下:

- 将数据保存到数据,待系统空闲时再进行处理

- 将数据用日志进行记录,后由人工处理

现在我们回到刚开始的问题就很好回答了:

线程池corePoolSize=5,线程初始化时不会自动创建线程,所以当有4个任务同时进来时,执行execute方法会新建【4】条线程来执行任务; 前面的4个任务都没完成,现在又进来2个队列,会新建【1】条线程来执行任务,这时poolSize=corePoolSize,还剩下1个任务,线程池会将剩下这个任务塞进阻塞队列中,等待空闲线程执行; 如果前面6个任务还是没有处理完,这时又同时进来了5个任务,此时还没有空闲线程来执行新来的任务,所以线程池继续将这5个任务塞进阻塞队列,但发现阻塞队列已经满了,核心线程也用完了,还剩下1个任务不知道如何是好,于是线程池只能创建【1】条“临时”线程来执行这个任务了; 这里创建的线程用“临时”来描述还是因为它们不会长期存在于线程池,它们的存活时间为keepAliveTime,此后线程池会维持最少corePoolSize数量的线程。

JDK为我们提供了Executors线程池工具类,里面有默认的线程池创建策略,大概有以下几种:

- FixedThreadPool:线程池线程数量固定,即corePoolSize和maximumPoolSize数量一样。

- SingleThreadPool:单个线程的线程池。

- CachedThreadPool:初始核心线程数量为0,最大线程数量为Integer.MAX_VALUE,线程空闲时存活时间为60秒,并且它的阻塞队列为SynchronousQueue,它的初始长度为0,这会导致任务每次进来都会创建线程来执行,在线程空闲时,存活时间到了又会释放线程资源。

- ScheduledThreadPool:创建一个定长的线程池,而且支持定时的以及周期性的任务执行,类似于Timer。

用Executors工具类虽然很方便,我依然不推荐大家使用以上默认的线程池创建策略,阿里巴巴开发手册也是强制不允许使用Executors来创建线程池,我们从JDK源码中寻找一波答案:

java.util.concurrent.Executors:

// FixedThreadPool

public static ExecutorService newFixedThreadPool(int nThreads) {

return new ThreadPoolExecutor(nThreads, nThreads,

0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>());

}

// SingleThreadPool

public static ExecutorService newSingleThreadExecutor() {

return new FinalizableDelegatedExecutorService

(new ThreadPoolExecutor(1, 1,

0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>()));

}

// CachedThreadPool

public static ExecutorService newCachedThreadPool() {

// 允许创建线程数为Integer.MAX_VALUE

return new ThreadPoolExecutor(0, Integer.MAX_VALUE,

60L, TimeUnit.SECONDS,

new SynchronousQueue<Runnable>());

}

// ScheduledThreadPool

public ScheduledThreadPoolExecutor(int corePoolSize) {

// 允许创建线程数为Integer.MAX_VALUE

super(corePoolSize, Integer.MAX_VALUE, 0, NANOSECONDS,

new DelayedWorkQueue());

}

public LinkedBlockingQueue() {

// 允许队列长度最大为Integer.MAX_VALUE

this(Integer.MAX_VALUE);

}从JDK源码可看出,Executors工具类无非是把一些特定参数进行了封装,并提供一些方法供我们调用而已,我们并不能灵活地填写参数,策略过于简单,不够友好。

CachedThreadPool和ScheduledThreadPool最大线程数为Integer.MAX_VALUE,如果线程无限地创建,会造成OOM异常。

LinkedBlockingQueue基于链表的FIFO队列,是无界的,默认大小是Integer.MAX_VALUE,因此FixedThreadPool和SingleThreadPool的阻塞队列长度为Integer.MAX_VALUE,如果此时队列被无限地堆积任务,会造成OOM异常。

当对一个线程调用interrupt方法时,线程的中断状态将被置位。这是每一个线程都具有的boolean标志。

要想弄清中断状态是否被置位,首先调用静态的Thread.currentThread()方法获得当前线程,然后调用isInterrupted()方法:

while(!Thread.currentThread().isInterrupted && more work){

do more work;

}如果线程被阻塞,就无法检测中断状态。

当在一个被阻塞的线程上调用interrupt()方法时,将会产生Interrupted Exception异常。

如果在中断状态被置位时调用sleep()方法,它不会休眠。相反,它将清除这一状态并抛出InterruptedException异常。

考虑到interrupt方法的线程设计:

Runnable r = ()->{

try{

do something;

while(!Thread.currentThread().isInterrupted() && more work){

do more work;

}

}

catch(InterruptedException e){

//处理异常

}finally{

//clean up

}

}对于catch内处理异常的问题,可以在catch子句中调用Thread.currentThread().interrupt()来设置中断状态。因为如果在中断状态被置位时调用sleep()方法,它将清除这一状态。

或者,更好的选择是,用throws InterruptedException标记你的方法,不采用try语句块捕获异常。这样调用者可以捕获这一异常:

void mySubTask() throws InterruptedException{

do something;

while(!Thread.currentThread().isInterrupted() && more work){

do more work;

}

}-

void join()

等待终止指定的线程。

-

void join(long millis)

等待指定的线程死亡或者经过指定的毫秒数。

public class JoinTest implements Runnable{

public void run() {

do something;

}

public static void main(String[] args) throws Exception {

Runnable r = new JoinTest();

Thread t = new Thread(r);

t.start();

t.join();//主线程会等待t线程结束之后再结束

}

} 每一个线程有一个优先级,默认继承它的父线程的优先级。

可以用setPriority方法为线程设置优先级。可以将优先级设置为在1与10之间的任何值,默认为5。

每当线程调度器有机会选择新线程时,它首先选择具有较高优先级的线程。但是,线程优先级是高度依赖于系统的。当虚拟机依赖于宿主机平台的线程实现机制时,Java线程的优先级被映射到宿主机平台的优先级上,优先级个数也许更多,也许更少。例如,Windows有7个优先级别。在Oracle为Linux提供的Java虚拟机中,线程的优先级被忽略——所有线程具有相同的优先级。

如果确实要使用优先级,应该避免使低优先级的线程完全饿死。

可以使用t.setDaemon(true)将线程转换为守护线程。

守护线程的唯一用途是为其他线程提供服务。当只剩下守护线程时,虚拟机就退出了,由于如果只剩下守护线程,就没必要继续运行程序了。

守护线程应该永远不去访问固有资源,如文件、数据库,因为它会在任何时候甚至在一个操作的中间发生中断。

线程进入临界区,却发现在某一条件满足之后它才能执行。要使用一个条件对象来管理那些已经获得了一个锁但是却不能做有用工作的线程。这时就要使用条件对象。

等待获得锁的线程和调用await方法的线程存在本质上的不同。一旦一个线程调用await方法,它进入该条件的等待集。即使锁可用时,该线程也不能马上解除阻塞,要等到另一个线程调用同一条件上的signalAll方法。

class Bank{

private Lock bankLock = new Reentrantlock();

private Condition sufficientFunds = bankLock.newCondition();

public void transfer(){

bankLock.lock();

try{

while(accounts[from]<amount) //注意不能使用if

sufficientFunds.await();

转移资金

sufficientFunds.signalAll();

}

}

}singalAll()重新激活因为这一条件而等待的所有线程。当这些线程从等待集当中移出时,它们将试图重新进入该对象。一旦锁成为可用的,它们中的某个将从await调用返回,重新获得该锁并从被阻塞的地方继续执行。此时,线程应该再次测试该条件。由于无法确保该条件被满足——signalAll方法仅仅是通知正在等待的线程此时有可能已经满足条件。

另一个方法signal,则是随机解除等待集中某个线程的阻塞状态。这比解除所有线程的阻塞更加有效,但也存在危险。如果随机选择的线程发现自己仍然不能运行,那么它再次被阻塞。如果没有其他线程再次调用signal,那么系统就死锁了。

await()方法也可以提供一个超时参数。

生产者线程向队列插入元素,消费者线程则取出它们。使用队列,可以安全地从一个线程向另一个线程传递数据。例如,考虑银行转账程序,转账线程将转账指令对象插入一个队列中,而不是直接访问银行对象。另一个线程从队列中取出指令执行转账。只有该线程可以访问该银行对象的内部。因此不需要同步。

当试图向队列添加元素而队列已满,或是想从队列移出元素而队列为空的时候,阻塞队列会将线程阻塞。

java.util.concurrent包提供了阻塞队列的几个变种:

-

LinkedBlockingQueue:默认的容量是没有上边界的,但是,也可以选择指定最大容量。

-

LinkedBlockingDeque:是一个双端的版本。

-

ArrayBlockingQueue:在构造时需要指定容量,并且有一个可选的参数来指定是否需要公平性。

-

PriorityBlockingQueue:是一个带优先级的队列,而不是先进先出队列。元素按照它们的优先级顺序被移出。

-

DelayQueue:包含实现Delayed接口的对象。

//getDelay方法返回对象的残留延迟。负值表示延迟已经结束。元素只有在延迟用完的情况下才能从DelayQueue移除。 //还必须实现compareTo方法。DelayQueue使用该方法对元素进行排序。 interface Delayed extends Comparable<Delayed>{ long getDelay(TimeUnit unit); }

java.util.concurrent包提供了映射、有序集和队列的高效实现:ConcurrentHashMap、ConcurrentSkipListMap、ConcurrentSkipListSet和ConcurrentLinkedQueue。

集合返回弱一致性(weakly consistent)的迭代器。这意味着迭代器不一定能反映出它们被构造之后的所有的修改,但是,它们不会将同一个值返回两次,也不会抛出Concurrent ModificationException异常。

synchronized和lock的区别(底层实现):https://www.jianshu.com/p/937a876372ff?utm_source=desktop&utm_medium=timeline

java 中的锁 -- 偏向锁、轻量级锁、自旋锁、重量级锁:https://blog.csdn.net/zqz_zqz/article/details/70233767

public class ReentrantLockTest {

public static void main(String[] args) throws InterruptedException {

ReentrantLock lock = new ReentrantLock();

for (int i = 1; i <= 3; i++) {

lock.lock();

}

for(int i=1;i<=3;i++){

try {

} finally {

lock.unlock();

}

}

}

}==与synchronized的对比==

- ReentrantLock可实现公平锁(先等待的线程先获得锁,默认是非公平的); synchronized不能,他默认也是非公平的。

- ReentrantLock可响应中断,就可以结束无意义的等待; synchronized不能

- ReentrantLock可实现获取锁子时 限时等待;synchronized不能

- ReentrantLock可实现 Object上的wait和notify方法可以实现线程间的等待通知机制,即用 Condition机制 ;synchronized不能

1.5. 谈谈 synchronized 和 ReentrantLock 的区别

“可重入锁” :指的是自己(sun:指的是当前线程)可以再次获取自己的内部锁。

相比synchronized,ReentrantLock增加了一些高级功能。主要来说主要有三点:

- 等待可中断 : ReentrantLock提供了一种能够中断等待锁的线程的机制,通过 lock.lockInterruptibly() 来实现这个机制。也就是说正在等待的线程可以选择放弃等待,改为处理其他事情。

- 可实现公平锁 : ReentrantLock可以指定是公平锁还是非公平锁。而synchronized只能是非公平锁。所谓的公平锁就是先等待的线程先获得锁。ReentrantLock默认情况是非公平的,可以通过 ReentrantLock类的ReentrantLock(boolean fair)构造方法来制定是否是公平的。

- 可实现选择性通知(锁可以绑定多个条件): synchronized关键字与wait()和notify()/notifyAll()方法相结合可以实现等待/通知机制。ReentrantLock类当然也可以实现,但是需要借助于Condition接口与newCondition()方法。

① 两者都是可重⼊锁

两者都是可重⼊锁。“可重⼊锁”概念是:⾃⼰可以再次获取⾃⼰的内部锁。⽐如⼀个线程获得了某个对

象的锁,此时这个对象锁还没有释放,当其再次想要获取这个对象的锁的时候还是可以获取的,如果不

可锁重⼊的话,就会造成死锁。同⼀个线程每次获取锁,锁的计数器都⾃增1,所以要等到锁的计数器

下降为0时才能释放锁。

② synchronized 依赖于 JVM ⽽ ReentrantLock 依赖于 API

synchronized 是依赖于 JVM 实现的,前⾯我们也讲到了 虚拟机团队在 JDK1.6 为 synchronized 关

键字进⾏了很多优化,但是这些优化都是在虚拟机层⾯实现的,并没有直接暴露给我们。

ReentrantLock 是 JDK 层⾯实现的(也就是 API 层⾯,需要 lock() 和 unlock() ⽅法配合

try/finally 语句块来完成),所以我们可以通过查看它的源代码,来看它是如何实现的。

③ ReentrantLock ⽐ synchronized 增加了⼀些⾼级功能

相⽐synchronized,ReentrantLock增加了⼀些⾼级功能。主要来说主要有三点:①等待可中断;②可

实现公平锁;③可实现选择性通知(锁可以绑定多个条件)

-

ReentrantLock提供了⼀种能够中断等待锁的线程的机制,通过lock.lockInterruptibly()来实现这个机制。也就是说正在等待的线程可以选择放弃等待,改为处理其他事情。

-

ReentrantLock可以指定是公平锁还是⾮公平锁。⽽synchronized只能是⾮公平锁。所谓的公平锁就是先等待的线程先获得锁。 ReentrantLock默认情况是⾮公平的,可以通过 ReentrantLock类的 ReentrantLock(boolean fair) 构造⽅法来制定是否是公平。

-

synchronized关键字与wait()和notify()/notifyAll()⽅法相结合可以实现等待/通知机制,ReentrantLock类当然也可以实现,但是需要借助于Condition接⼝与newCondition() ⽅法。Condition是JDK1.5之后才有的,它具有很好的灵活性,⽐如可以实现多路通知功能也就是在⼀个Lock对象中可以创建多个Condition实例(即对象监视器),线程对象可以注册在指定的Condition中,从⽽可以有选择性的进⾏线程通知,在调度线程上更加灵活。 在使⽤notify()/notifyAll()⽅法进⾏通知时,被通知的线程是由 JVM 选择的,⽤ReentrantLock类结合Condition实例可以实现**“选择性通知”** ,这个功能⾮常重要,⽽且是Condition接⼝默认提供的。⽽synchronized关键字就相当于整个Lock对象中只有⼀个Condition实例,所有的线程都注册在它⼀个身上。如果执⾏notifyAll()⽅法的话就会通知所有处于等待状态的线程这样会造成很⼤的效率问题,⽽Condition实例的signalAll()⽅法 只会唤醒注册在该Condition实例中的所有等待线程。

如果你想使⽤上述功能,那么选择ReentrantLock是⼀个不错的选择。

总结:

Volatile和 synchronized分别保证什么性质:volatile保证可见性,有序性;synchronized保证了三个性质(原子,可见,有序)

- volatile:通过内存屏障实现。在读时,特定行语句前后加上内存屏障,前面的内存屏障保证能从内存读取到最新的值,后面的屏障保证这条读语句,不要被后面的指令给重排序。

- synchronized:也要在代码块前后,加上内存屏障,作用和volatile的内存屏障是一样的

为什么不能保证原子性:比如 i++,实际上是3步指令执行,volatile虽然保证1条语句原子性,但不能保证3条都原子性。在并发的情况下回出现错误。

- volatile对那些可以保证原子性呢:比如简单的get,set可以保证简单的原子性,但getAndSet()这类是不保证原子性的。

volatile的作用:

- 发生修改后强制将当前处理器缓存行的数据写回到系统内存。

- 这个写回内存的操作 会使得在其他处理器缓存了该内存地址无效,重新从内存中读取。

建议看:Java6及以上版本对synchronized的优化 - 吴庆龙的技术轮子 - 博客园

Java的对象头和对象组成详解_lkforce-CSDN博客_java对象头

总结:

JVM一般是这样使用锁和Mark Word的:

1,当没有被当成锁时,这就是一个普通的对象,Mark Word记录对象的HashCode,锁标志位是01,是否偏向锁那一位是0。

2,当对象被当做同步锁并有一个线程A抢到了锁时,锁标志位还是01,但是否偏向锁那一位改成1,前23bit记录抢到锁的线程id,表示进入偏向锁状态。

3,当线程A再次试图来获得锁时,JVM发现同步锁对象的标志位是01,是否偏向锁是1,也就是偏向状态,Mark Word中记录的线程id就是线程A自己的id,表示线程A已经获得了这个偏向锁,可以执行同步锁的代码。

4,当线程B试图获得这个锁时,JVM发现同步锁处于偏向状态,但是Mark Word中的线程id记录的不是B,那么线程B会先用CAS操作试图获得锁,这里的获得锁操作是有可能成功的,因为线程A一般不会自动释放偏向锁。如果抢锁成功,就把Mark Word里的线程id改为线程B的id,代表线程B获得了这个偏向锁,可以执行同步锁代码。如果抢锁失败,则继续执行步骤5。

5,偏向锁状态抢锁失败,代表当前锁有一定的竞争,偏向锁将升级为轻量级锁。JVM会在当前线程A的线程栈中开辟一块单独的空间,里面保存指向对象锁Mark Word的指针,同时在对象锁Mark Word中保存指向这片空间的指针。上述两个保存操作都是CAS操作,如果保存成功,代表线程抢到了同步锁,就把Mark Word中的锁标志位改成00,可以执行同步锁代码。如果保存失败,表示抢锁失败,竞争太激烈,继续执行步骤6。

6,轻量级锁抢锁失败,JVM会使用自旋锁,自旋锁不是一个锁状态,只是代表不断的重试,尝试抢锁。从JDK1.7开始,自旋锁默认启用,自旋次数由JVM决定。如果抢锁成功则执行同步锁代码,如果失败则继续执行步骤7。

7,自旋锁重试之后如果抢锁依然失败,同步锁会升级至重量级锁,锁标志位改为10。在这个状态下,未抢到锁的线程都会被阻塞。

偏向锁

偏向锁是针对于一个线程而言的, 线程获得锁之后就不会再有解锁等操作了, 这样可以省略很多开销. 假如有两个线程来竞争该锁话, 那么偏向锁就失效了, 进而升级成轻量级锁了.

为什么要这样做呢? 因为经验表明, 其实大部分情况下, 都会是同一个线程进入同一块同步代码块的. 这也是为什么会有偏向锁出现的原因.

在Jdk1.6中, 偏向锁的开关是默认开启的, 适用于只有一个线程访问同步块的场景.

偏向锁的加锁

当一个线程访问同步块并获取锁时, 会在锁对象的对象头和栈帧中的锁记录里存储锁偏向的线程ID, 以后该线程进入和退出同步块时不需要进行CAS操作来加锁和解锁, 只需要简单的测试一下锁对象的对象头的MarkWord里是否存储着指向当前线程的偏向锁(线程ID是当前线程), 如果测试成功, 表示线程已经获得了锁; 如果测试失败, 则需要再测试一下MarkWord中偏向锁的标识是否设置成1(表示当前是偏向锁), 如果没有设置, 则使用CAS竞争锁, 如果设置了, 则尝试使用CAS将锁对象的对象头的偏向锁指向当前线程.

偏向锁的撤销

偏向锁使用了一种等到竞争出现才释放锁的机制, 所以当其他线程尝试竞争偏向锁时, 持有偏向锁的线程才会释放锁. 偏向锁的撤销需要等到全局安全点(在这个时间点上没有正在执行的字节码). 首先会暂停持有偏向锁的线程, 然后检查持有偏向锁的线程是否存活, 如果线程不处于活动状态, 则将锁对象的对象头设置为无锁状态; 如果线程仍然活着, 则锁对象的对象头中的MarkWord和栈中的锁记录要么重新偏向于其它线程要么恢复到无锁状态, 最后唤醒暂停的线程(释放偏向锁的线程).

偏向锁在Java6及更高版本中是默认启用的, 但是它在程序启动几秒钟后才激活. 可以使用-XX:BiasedLockingStartupDelay=0来关闭偏向锁的启动延迟, 也可以使用-XX:-UseBiasedLocking=false来关闭偏向锁, 那么程序会直接进入轻量级锁状态.

6-2.轻量级锁

当出现有两个线程来竞争锁的话, 那么偏向锁就失效了, 此时锁就会膨胀, 升级为轻量级锁.

轻量级锁加锁

线程在执行同步块之前, JVM会先在当前线程的栈帧中创建用户存储锁记录的空间, 并将对象头中的MarkWord复制到锁记录中. 然后线程尝试使用CAS将对象头中的MarkWord替换为指向锁记录的指针. 如果成功, 当前线程获得锁; 如果失败, 表示其它线程竞争锁, 当前线程便尝试使用自旋来获取锁, 之后再来的线程, 发现是轻量级锁, 就开始进行自旋.

轻量级锁解锁

轻量级锁解锁时, 会使用原子的CAS操作将当前线程的锁记录替换回到对象头, 如果成功, 表示没有竞争发生; 如果失败, 表示当前锁存在竞争, 锁就会膨胀成重量级锁.

总结

总结一下加锁解锁过程, 有线程A和线程B来竞争对象c的锁(如: synchronized(c){} ), 这时线程A和线程B同时将对象c的MarkWord复制到自己的锁记录中, 两者竞争去获取锁, 假设线程A成功获取锁, 并将对象c的对象头中的线程ID(MarkWord中)修改为指向自己的锁记录的指针, 这时线程B仍旧通过CAS去获取对象c的锁, 因为对象c的MarkWord中的内容已经被线程A改了, 所以获取失败. 此时为了提高获取锁的效率, 线程B会循环去获取锁, 这个循环是有次数限制的, 如果在循环结束之前CAS操作成功, 那么线程B就获取到锁, 如果循环结束依然获取不到锁, 则获取锁失败, 对象c的MarkWord中的记录会被修改为重量级锁, 然后线程B就会被挂起, 之后有线程C来获取锁时, 看到对象c的MarkWord中的是重量级锁的指针, 说明竞争激烈, 直接挂起.

解锁时, 线程A尝试使用CAS将对象c的MarkWord改回自己栈中复制的那个MarkWord, 因为对象c中的MarkWord已经被指向为重量级锁了, 所以CAS失败. 线程A会释放锁并唤起等待的线程, 进行新一轮的竞争.

6.锁的比较

锁优点缺点适用场景偏向锁加锁和解锁不需要额外的消耗, 和执行非同步代码方法的性能相差无几.如果线程间存在锁竞争, 会带来额外的锁撤销的消耗.适用于只有一个线程访问的同步场景轻量级锁竞争的线程不会阻塞, 提高了程序的响应速度如果始终得不到锁竞争的线程, 使用自旋会消耗CPU追求响应时间, 同步快执行速度非常快重量级锁线程竞争不适用自旋, 不会消耗CPU线程堵塞, 响应时间缓慢追求吞吐量, 同步快执行时间速度较长

7.总结

首先要明确一点是引入这些锁是为了提高获取锁的效率, 要明白每种锁的使用场景, 比如偏向锁适合一个线程对一个锁的多次获取的情况; 轻量级锁适合锁执行体比较简单(即减少锁粒度或时间), 自旋一会儿就可以成功获取锁的情况.

要明白MarkWord中的内容表示的含义.

java.util.concurrent.locks包定义了两个锁类,ReentrantLock类和ReentrantReadWriteLock类。如果很多线程从一个数据结构读取数据而很少线程修改其中数据的话,读写锁是十分有用的。

private ReentrantReadWriteLock rwl = new ReentrantReadWriteLock();

private Lock readLock = rwl.readLock(); //抽取读锁

private Lock writeLock = rwl.writeLock(); //抽取写锁

//对所有获取方法加读锁

public void getSomething(){

readLock.lock();

try{...}

finally{readLock.unlock();}

}

//对所有修改方法加写锁

public void transfer(){

writeLock.lock();

try{...}

finally{writeLock.unlock();}

}读锁可以被多个读操作共用,但会排斥所有写操作。写锁,排斥所有其他的读操作和写操作。

自旋锁的定义:当一个线程尝试去获取某一把锁的时候,如果这个锁此时已经被别人获取(占用),那么此线程就无法获取到这把锁,该线程将会等待,间隔一段时间后会再次尝试获取。这种采用循环加锁 -> 等待的机制被称为自旋锁(spinlock)

自旋锁避免了操作系统进程调度和线程切换,所以自旋锁通常适用在时间比较短的情况下。

- 适合自旋锁:适合锁的竞争不激烈,且占用锁时间非常短的代码块来说性能能大幅度的提升,通常会设置自旋的时间。

- 不适合自旋锁:如果锁的竞争激烈,或者持有锁的线程需要长时间占用锁执行同步块,这时候就不适合使用自旋锁了。

如果自旋锁的获取不公平(申请者是否FIFO的得到锁)怎么办:

可以用CLHLock和MCSLock、TicketLock 等等一些锁。

两种锁各有优缺点,不可认为一种好于另一种。

乐观锁适用于写比较少的情况下(多读场景),即冲突真的很少发生的时候,这样可以省去了锁的开销,加大了系统的整个吞吐量。但如果是多写的情况,一般会经常产生冲突,这就会导致上层应用会不断的进行retry,这样反倒是降低了性能,所以一般多写的场景下用悲观锁就比较合适。

悲观锁:

总是假设最坏的情况,每次去拿数据的时候都认为别人会修改,所以每次在拿数据的时候都会上锁,这样别人想拿这个数据就会阻塞直到它拿到锁(共享资源每次只给一个线程使用,其它线程阻塞,用完后再把资源转让给其它线程)。

传统的关系型数据库里边就用到了很多这种锁机制,比如行锁,表锁等,读锁,写锁等,都是在做操作之前先上锁。

Java中synchronized和ReentrantLock等独占锁就是悲观锁思想的实现。

乐观锁:

总是假设最好的情况,每次去拿数据的时候都认为别人不会修改,所以不会上锁,但是在更新的时候会判断一下在此期间别人有没有去更新这个数据,可以使用版本号机制和CAS算法实现。

乐观锁适用于多读的应用类型,这样可以提高吞吐量,像数据库提供的类似于write_condition机制,其实都是提供的乐观锁。

在Java中java.util.concurrent.atomic包下面的原子变量类就是使用了乐观锁的一种实现方式CAS实现的。

缺点:

-

ABA 问题

如果一个变量V初次读取的时候是A值,并且在准备赋值的时候检查到它仍然是A值,那我们就能说明它的值没有被其他线程修改过了吗?很明显是不能的,因为在这段时间它的值可能被改为其他值,然后又改回A,那CAS操作就会误认为它从来没有被修改过。这个问题被称为CAS操作的 "ABA"问题。

JDK 1.5 以后的

AtomicStampedReference 类就提供了此种能力,其中的compareAndSet 方法就是首先检查当前引用是否等于预期引用,并且当前标志是否等于预期标志,如果全部相等,则以原子方式将该引用和该标志的值设置为给定的更新值。 -

循环时间长开销大

自旋CAS(也就是不成功就一直循环执行直到成功)如果长时间不成功,会给CPU带来非常大的执行开销。

-

只能保证一个共享变量的原子操作

CAS 只对单个共享变量有效,当操作涉及跨多个共享变量时 CAS 无效。但是从 JDK 1.5开始,提供了

AtomicReference类来保证引用对象之间的原子性,你可以把多个变量放在一个对象里来进行 CAS 操作.所以我们可以使用锁或者利用AtomicReference类把多个共享变量合并成一个共享变量来操作。

乐观锁一般会使用版本号机制或CAS算法实现

一般是在数据表中加上一个数据版本号version字段,表示数据被修改的次数,当数据被修改时,version值会加一。当线程A要更新数据值时,在读取数据的同时也会读取version值,在提交更新时,若刚才读取到的version值为当前数据库中的version值相等时才更新,否则重试更新操作,直到更新成功。

即compare and swap(比较与交换),是一种有名的无锁算法。

无锁编程,即不使用锁的情况下实现多线程之间的变量同步,也就是在没有线程被阻塞的情况下实现变量的同步,所以也叫非阻塞同步。CAS算法涉及到三个操作数

- 需要读写的内存值 V

- 进行比较的值 A

- 拟写入的新值 B

当且仅当 V 的值等于 A时,CAS通过原子方式用新值B来更新V的值,否则不会执行任何操作(比较和替换是一个原子操作)。一般情况下是一个自旋操作,即不断的重试。

锁消除是指对于被检测出不可能存在竞争的共享数据的锁进行消除。

public static String concatString(String s1, String s2, String s3) {

StringBuffer sb = new StringBuffer();

sb.append(s1);

sb.append(s2);

sb.append(s3);

return sb.toString();

}eg:消除concaString()是,就算转换为StringBuffer进行拼接需要对对象进行加锁,但因为JVM发现sb逃逸不出去,故而可以把这个concatString()的对象锁给去掉。

建议看:java字面量和符号引用_彻底弄懂java中的常量池_从夏的博客-CSDN博客

建议看2:Java常量池理解与总结

class文件里常量池里大部分数据会被加载到“运行时常量池”,包括String的字面量;但同时“Hello”字符串的一个引用会被存到同样在“非堆”区域的“字符串常量池”中。1.8以后在元空间中,元空间在本地内存中,而"Hello"本体还是和所有对象一样,创建在Java堆中。

常量池主要存放两大常量:字面量和符号引用。字面量比较接近于 Java 语言层面的的常量概念,如文本字符串、声明为 final 的常量值等。而符号引用则属于编译原理方面的概念。包括下面三类常量:

- 类和接口的全限定名

- 字段的名称和描述符

- 方法的名称和描述符

这个收集器是一个单线程的收集器,但它的“单线程”的意义并不仅仅说明它只会使用一个CPU或一条收集线程去完成垃圾收集工作,更重要的是在它进行垃圾收集时,必须暂停其他所有的工作线程,直到它收集结束。

实际上到现在为止,它依然是虚拟机运行在Client模式下的默认新生代收集器。它也有着优于其他收集器的地方:简单而高效(与其他收集器的单线程比),对于限定单个CPU的环境来说,Serial收集器由于没有线程交互的开销,专心做垃圾收集自然可以获得最高的单线程收集效率。在用户的桌面应用场景中,分配给虚拟机管理的内存一般来说不会很大,收集几十兆甚至一两百兆的新生代,停顿时间完全可以控制在几十毫秒最多一百多毫秒以内,只要不是频繁发生,这点停顿是可以接受的。所以,Serial收集器对于运行在Client模式下的虚拟机来说是一个很好的选择。

ParNew收集器其实就是Serial收集器的多线程版本。

ParNew收集器除了多线程收集之外,其他与Serial收集器相比并没有太多创新之处,但它却是许多运行在Server模式下的虚拟机中首选的新生代收集器,其中有一个与性能无关但很重要的原因是,除了Serial收集器外,目前只有它能与CMS收集器配合工作。

Parallel Scavenge收集器是一个新生代收集器,它也是使用复制算法的收集器,又是并行的多线程收集器。

Parallel Scavenge收集器的特点是它的关注点与其他收集器不同,其它收集器的关注点是尽可能地缩短垃圾收集时用户线程的停顿时间,而Parallel Scavenge收集器的目标则是达到一个可控制的吞吐量。所谓吞吐量就是CPU用于运行用户代码的时间与CPU总消耗时间的比值。

Serial Old是Serial收集器的老年代版本,它同样是一个单线程收集器,使用“标记-整理”算法。这个收集器的主要意义也是在于给Client模式下的虚拟机使用。

Parallel Old是Parallel Scavenge收集器的老年代版本,使用多线程和“标记-整理”算法。在注重吞吐量以及CPU资源敏感的场合,都可以优先考虑Parallel Scavenge加Parallel Old收集器。

CMS(Concurrent Mark Sweep)收集器是一种以获取最短回收停顿时间为目标的收集器。目前很大一部分的Java应用集中在互联网站或者B/S系统的服务端上,这类应用尤其重视服务的响应速度,希望系统停顿时间最短,以给用户带来较好的体验。CMS收集器就非常符合这类应用的需求。

CMS收集器是基于“标记—清除”算法实现的,它的运作过程相对于前面几种收集器来说更复杂一些,整个过程分为4个步骤,包括:

-

初始标记:标记一下GC Roots能直接关联到的对象。

-

并发标记:进行GCRoots Tracing的过程。

-

重新标记:为了修正并发标记期间因用户程序继续运作而导致标记产生变动的那一部分对象的标记记录。

-

并发清除:

其中,初始标记、重新标记这两个步骤仍然需要“Stop The World”。初始标记仅仅只是标记一下GC Roots能直接关联到的对象,速度很快,并发标记阶段就是进行GCRoots Tracing的过程,而重新标记阶段则是为了修正并发标记期间因用户程序继续运作而导致标记产生变动的那一部分对象的标记记录,这个阶段的停顿时间一般会比初始标记阶段稍长一些,但远比并发标记的时间短。

由于整个过程中耗时最长的并发标记和并发清除过程收集器线程都可以与用户线程一起工作,所以,从总体上来说,CMS收集器的内存回收过程是与用户线程一起并发执行的。

- 调用 System.gc()

- 老年代空间不足。太大的对象进入老年代,但进入不了

- 空间分配担保失败

- Concurrent Mode Failure

总结:

- stop the world:CMS是第1,3阶段,G1是,1,3,4都是stop。stop的意思是,让应用停下来,JVM要执行全力执行 GC垃圾回收线程。

- 描述CMS和G1:执行步骤,是否stop,优缺点,对比,清楚的算法,主要特色

原文:https://www.cnblogs.com/aspirant/p/8663897.html

CMS收集算法 参考:图解 CMS 垃圾回收机制原理,-阿里面试题

G1收集算法 参考:G1 垃圾收集器入门

首先要知道 Stop the world的含义(网易面试):不管选择哪种GC算法,stop-the-world都是不可避免的。Stop-the-world意味着从应用中停下来并进入到GC执行过程中去。一旦Stop-the-world发生,除了GC所需的线程外,其他线程都将停止工作,中断了的线程直到GC任务结束才继续它们的任务。GC调优通常就是为了改善stop-the-world的时间

CMS收集器是一种以获取最短回收停顿时间为目标的收集器,CMS收集器是基于“”标记--清除”(Mark-Sweep)算法实现的,整个过程分为四个步骤:

1. 初始标记 (Stop the World事件 CPU停顿, 很短) 初始标记仅标记一下GC Roots能直接关联到的对象,速度很快;

2. 并发标记 (收集垃圾跟用户线程一起执行) 初始标记和重新标记任然需要“stop the world”,并发标记过程就是进行GC Roots Tracing的过程;

3. 重新标记 (Stop the World事件 CPU停顿,比初始标记稍微长,远比并发标记短)修正并发标记期间因用户程序继续运作而导致标记产生变动的那一部分对象的标记记录,这个阶段的停顿时间一般会比初始标记阶段稍长一些,但远比并发标记时间短

4. 并发清理 -清除算法;

整个过程中耗时最长的并发标记和并发清除过程收集器线程都可以与用户线程一起工作,所以,从总体上来说,CMS收集器的内存回收过程是与用户线程一起并发执行的。

初始标记:仅仅是标记一下GC roots 能直接关联的对象,速度很快 (何为GC roots :

在Java语言中,可作为GC Roots的对象包括4种情况:

a) 虚拟机栈中引用的对象(栈帧中的本地变量表);

b) 方法区中类静态属性引用的对象;

c) 方法区中常量引用的对象;

d) 本地方法栈中JNI(Native方法)引用的对象。

具体参考:JVM的垃圾回收机制 总结(垃圾收集、回收算法、垃圾回收器))

CMS是一款优秀的收集器,它的主要优点是:并发收集、低停顿,但他有以下3个明显的缺点:

优点:并发收集,低停顿

理由: 由于在整个过程和中最耗时的并发标记和 并发清除过程收集器程序都可以和用户线程一起工作,所以总体来说,Cms收集器的内存回收过程是与用户线程一起并发执行的

缺点:

1.CMS收集器对CPU资源非常敏感

在并发阶段,虽然不会导致用户线程停顿,但是会因为占用了一部分线程使应用程序变慢,总吞吐量会降低,为了解决这种情况,虚拟机提供了一种“增量式并发收集器”

的CMS收集器变种, 就是在并发标记和并发清除的时候让GC线程和用户线程交替运行,尽量减少GC 线程独占资源的时间,这样整个垃圾收集的过程会变长,但是对用户程序的影响会减少。(效果不明显,不推荐)

- CMS处理器无法处理浮动垃圾

CMS在并发清理阶段线程还在运行, 伴随着程序的运行自然也会产生新的垃圾,这一部分垃圾产生在标记过程之后,CMS无法再当次过程中处理,所以只有等到下次gc时候在清理掉,这一部分垃圾就称作“浮动垃圾” ,

- CMS是基于“标记--清除”算法实现的,所以在收集结束的时候会有大量的空间碎片产生。空间碎片太多的时候,将会给大对象的分配带来很大的麻烦,往往会出现老年代还有很大的空间剩余,但是无法找到足够大的连续空间来分配当前对象的,只能提前触发 full gc。

为了解决这个问题,CMS提供了一个开关参数,用于在CMS顶不住要进行full gc的时候开启内存碎片的合并整理过程,内存整理的过程是无法并发的,空间碎片没有了,但是停顿的时间变长了

美团技术团队文章:Java Hotspot G1 GC的一些关键技术

建议读:https://www.jianshu.com/p/7340becc027c

1) G1堆内存结构

堆内存会被切分成为很多个固定大小区域(Region),每个是连续范围的虚拟内存。

堆内存中一个区域(Region)的大小可以通过-XX:G1HeapRegionSize参数指定,大小区间最小1M、最大32M,总之是2的幂次方。

默认把堆内存按照2048份均分。

2) G1堆内存分配

每个Region被标记了E、S、O和H,这些区域在逻辑上被映射为Eden,Survivor和老年代。

存活的对象从一个区域转移(即复制或移动)到另一个区域。区域被设计为并行收集垃圾,可能会暂停所有应用线程。

如上图所示,区域可以分配到Eden,survivor和老年代。此外,还有第四种类型,被称为巨型区域(Humongous Region)。Humongous区域是为了那些存储超过50%标准region大小的对象而设计的,它用来专门存放巨型对象。如果一个H区装不下一个巨型对象,那么G1会寻找连续的H分区来存储。为了能找到连续的H区,有时候不得不启动Full GC。

G1回收流程

在执行垃圾收集时,G1以类似于CMS收集器的方式运行。

- G1收集器的阶段分以下几个步骤:

1)G1执行的第一阶段:初始标记(Initial Marking )

这个阶段是STW(Stop the World )的,所有应用线程会被暂停,标记出从GC Root开始直接可达的对象。

2)G1执行的第二阶段:并发标记

从GC Roots开始对堆中对象进行可达性分析,找出存活对象,耗时较长。当并发标记完成后,开始最终标记(Final Marking )阶段

3)最终标记

标记那些在并发标记阶段发生变化的对象,将被回收。

4)筛选回收

首先对各个Regin的回收价值和成本进行排序,根据用户所期待的GC停顿时间指定回收计划,回收一部分Region。

最后,G1中提供了两种模式垃圾回收模式,Young GC和Mixed GC,两种都是Stop The World(STW)的。

详细的使用方案:

G1作为JDK9之后的服务端默认收集器,不再区分年轻代和老年代进行垃圾回收,G1默认把堆内存分为N个分区,每个1~32M(总是2的幂次方)。并且提供了四种不同Region标签 Eden 、 Survivor 、 Old 、 Humongous 。H区可以认为是Old区中一种特别专门用来存储大数据的,关于H区数据存储类型一般符合下面条件:

当 0.5 Region <= 当对象大小 <= 1 Region 时候将数据存储到 H区

当对象大小 > 1 Region 存储到连续的H区。

同时G1中引入了 RememberSets 、 CollectionSets 帮助更好的执行GC 。

1、 RememberSets : RSet 记录了其他Region中的对象引用本Region中对象的关系,属于points-into结构(谁引用了我的对象)

2、 CollectionSets : Csets 是一次GC中需要被清理的regions集合,注意G1每次GC不是全部region都参与的,可能只清理少数几个,这几个就被叫做Csets。在GC的时候,对于old -> young 和old -> old的跨代对象引用,只要扫描对应的 CSet 中的 RSet 即可。

G1进行GC的时候一般分为 Yang GC 跟 Mixed GC 。

Young GC : CSet 就是所有年轻代里面的Region

Mixed GC : CSet 是所有年轻代里的Region + 在全局并发标记阶段标记出来的收益高的Region

标准的年轻代GC算法,整体思路跟CMS中类似。

5.4.2、Mixed GC

G1中是 没 有Old GC的,有一个把老年代跟新生代同时GC的 Mixed GC,它的 回收流程 :

1、 初始标记 : 是STW事件 ,其完成工作是标记GC ROOTS 直接可达的对象。标记位RootRegion。

2、 根区域扫描 : 不是STW事件 ,拿来RootRegion,扫描整个Old区所有Region,看每个Region的 Rset 中是否有RootRegion。有则标识出来。

3、 并发标记 : 同CMS并发标记 不需要STW ,遍历范围减少,在此只需要遍历 第二步 被标记到引用老年代的对象 RSet。

4、 最终标记 : 同 CMS 重新标记 会STW ,用的 SATB 操作,速度更快。

5、 清除 : STW操作 ,用 复制清理算法 ,清点出有存活对象的Region和没有存活对象的Region(Empty Region),更新Rset。把Empty Region收集起来到可分配Region队列。

回收总结:

1、经过global concurrent marking,collector就知道哪些Region有存活的对象。并将那些完全可回收的Region(没有存活对象)收集起来加入到可分配Region队列,实现对该部分内存的回收。对于有存活对象的Region,G1会根据统计模型找出收益最高、开销不超过用户指定的上限的若干Region进行对象回收。这些选中被回收的Region组成的集合就叫做collection set 简称Cset!

2、在MIX GC中的Cset = 所有年轻代里的region + 根据global concurrent marking统计得出收集收益高的若干old region 。

3、在YGC中的Cset = 所有年轻代里的region + 通过控制年轻代的region个数来控制young GC的开销 。

4、YGC 与 MIXGC 都是采用多线程复制清理,整个过程会STW。 G1的 低延迟原理 在于其回收的区域变得精确并且范围变小了。

G1提速点:

1 重新标记 使X区域直接删除。

2 Rset 降低了扫描的范围,上题中两点。

3 重新标记阶段使用 SATB 速度比CMS快。

4 清理过程为选取部分存活率低的Region进行清理,不是全部,提高了清理的效率。

总结:

就像你妈让你把自己卧室打扫干净,你可能只把显眼而比较大的垃圾打扫了,犄角旮旯的你没打扫。关于G1 还有很多细节其实没看到也。一句话总结G1思维: 每次选择性的清理大部分垃圾来保证时效性跟系统的正常运行 。

什么时候用G1 ?

如果应用程序使用CMS或ParallelOld垃圾回收器具有一个或多个以下特征,将有利于切换到G1:

- Full GC持续时间太长或太频繁

- 对象分配率或年轻代升级老年代很频繁

- 不期望的很长的垃圾收集时间或压缩暂停(超过0.5至1秒)

注意:如果你正在使用CMS或ParallelOld收集器,并且你的应用程序没有遇到长时间的垃圾收集暂停,则保持与您的当前收集器是很好的,升级JDK并不必要更新收集器为G1。

-

引用计数法:会存在循环引用的问题,Java不用

-

可达性分析算法:GC Roots,一般GC Roots包括:

- 虚拟机栈中局部变量表中引用的对象

- 本地方法栈中 JNI 中引用的对象

- 方法区中类静态属性引用的对象

- 方法区中的常量引用的对象

-

方法区的回收:对常量池的回收和对类的卸载。

-

finalize():

-

对象优先在 Eden分配。

-

大对象直接进入老年代。

-

长期存活对象进入老年代。大于 PretenureSizeThreshold 就可以进入老年代

-

动态对象判定机制。不是一定要到了指定年龄,才能进入老年代

-

空间分配担保。如果老年代剩余空间,不足以支撑新生代的处理方式。

98%的对象,第一轮就死掉了。所以90%是空的,10%是survivor的。

java中堆的分区:https://blog.csdn.net/qq_41700030/article/details/99310305

简单写个main函数,说下其在jvm中的生命周期

public class A{

public int i=1;

public static void mian(String args[]){

A a=new A();

}

}

123456

- 加载class文件到class内容区域,加载静态方法和静态变量到静态区(同时加载的)

- 调用main方法到栈内存

- 在栈内存中为a变量(A对象的引用)开辟空间 4. 在堆内存为A对象申请空间 5. 给成员变量进行默认初始化(此时 i=0),同时有一个方法标记,在方法区中创建一个A的方法区,将A的方法区的地址0x01给方法标记 6. 给成员变量进行显示初始化(此时 i=1)

- 将A对象的地址值给变量a

1.既然有GC机制,为什么还会有内存泄露的情况?

理论上Java 因为有垃圾回收机制(GC)不会存在内存泄露问题(这也是 Java 被广泛使用于服务器端编程的一个重要原因)。然而在实际开发中,可能会存在无用但可达的对象,这些对象不能被 GC 回收,因此也会导致内存泄露的发生。

例如 hibernate 的 Session(一级缓存)中的对象属于持久态,垃圾回收器是不会回收这些对象的,然而这些对象中可能存在无用的垃圾对象,如果不及时关闭(close)或清空(flush)一级缓存就可能导致内存泄露。

下面例子中的代码也会导致内存泄露。

import java.util.Arrays;

import java.util.EmptyStackException;

public class MyStack<T> {

private T[] elements;

private int size = 0;

private static final int INIT_CAPACITY = 16;

public MyStack() {

elements = (T[]) new Object[INIT_CAPACITY];

}

public void push(T elem) {

ensureCapacity();

elements[size++] = elem;

}

public T pop() {

if (size == 0)

throw new EmptyStackException();

return elements[--size];

}

private void ensureCapacity() {

if (elements.length == size) {

elements = Arrays.copyOf(elements, 2 * size + 1);

}

}

}上面的代码实现了一个栈(先进后出(FILO))结构,乍看之下似乎没有什么明显的问题,它甚至可以通过你编写的各种单元测试。然而其中的 pop 方法却存在内存泄露的问题,当我们用 pop 方法弹出栈中的对象时,该对象不会被当作垃圾回收,即使使用栈的程序不再引用这些对象,因为栈内部维护着对这些对象的过期引用(obsolete reference)。在支持垃圾回收的语言中,内存泄露是很隐蔽的,这种内存泄露其实就是无意识的对象保持。如果一个对象引用被无意识的保留起来了,那么垃圾回收器不会处理这个对象,也不会处理该对象引用的其他对象,即使这样的对象只有少数几个,也可能会导致很多的对象被排除在垃圾回收之外,从而对性能造成重大影响,极端情况下会引发 Disk Paging (物理内存与硬盘的虚拟内存交换数据),甚至造成 OutOfMemoryError。

2. Java中为什么会有GC机制呢?

安全性考虑;-- for security.

减少内存泄露;-- erase memory leak in some degree.

减少程序员工作量。-- Programmers don't worry about memory releasing.

- 对于Java的GC哪些内存需要回收?

内存运行时JVM会有一个运行时数据区来管理内存。它主要包括5大部分:程序计数器(Program Counter Register)、虚拟机栈(VM Stack)、本地方法栈(Native Method Stack)、方法区(Method Area)、堆(Heap).

而其中程序计数器、虚拟机栈、本地方法栈是每个线程私有的内存空间,随线程而生,随线程而亡。例如栈中每一个栈帧中分配多少内存基本上在类结构确定是哪个时就已知了,因此这3个区域的内存分配和回收都是确定的,无需考虑内存回收的问题。

但方法区和堆就不同了,一个接口的多个实现类需要的内存可能不一样,我们只有在程序运行期间才会知道会创建哪些对象,这部分内存的分配和回收都是动态的,GC主要关注的是这部分内存。

总而言之,GC主要进行回收的内存是JVM中的方法区和堆;

4. Java的GC什么时候回收垃圾?

在面试中经常会碰到这样一个问题(事实上笔者也碰到过):如何判断一个对象已经死去?

很容易想到的一个答案是:对一个对象添加引用计数器。每当有地方引用它时,计数器值加1;当引用失效时,计数器值减1.而当计数器的值为0时这个对象就不会再被使用,判断为已死。是不是简单又直观。然而,很遗憾。这种做法是错误的!为什么是错的呢?事实上,用引用计数法确实在大部分情况下是一个不错的解决方案,而在实际的应用中也有不少案例,但它却无法解决对象之间的循环引用问题。比如对象A中有一个字段指向了对象B,而对象B中也有一个字段指向了对象A,而事实上他们俩都不再使用,但计数器的值永远都不可能为0,也就不会被回收,然后就发生了内存泄露。

所以,正确的做法应该是怎样呢? 在Java,C#等语言中,比较主流的判定一个对象已死的方法是:可达性分析(Reachability Analysis).所有生成的对象都是一个称为"GC Roots"的根的子树。从GC Roots开始向下搜索,搜索所经过的路径称为引用链(Reference Chain),当一个对象到GC Roots没有任何引用链可以到达时,就称这个对象是不可达的(不可引用的),也就是可以被GC回收了。

无论是引用计数器还是可达性分析,判定对象是否存活都与引用有关!那么,如何定义对象的引用呢?

我们希望给出这样一类描述:当内存空间还够时,能够保存在内存中;如果进行了垃圾回收之后内存空间仍旧非常紧张,则可以抛弃这些对象。所以根据不同的需求,给出如下四种引用,根据引用类型的不同,GC回收时也会有不同的操作:

1)强引用(Strong Reference):Object obj = new Object();只要强引用还存在,GC永远不会回收掉被引用的对象。

2)软引用(Soft Reference):描述一些还有用但非必需的对象。在系统将会发生内存溢出之前,会把这些对象列入回收范围进行二次回收(即系统将会发生内存溢出了,才会对他们进行回收。)

3)弱引用(Weak Reference):程度比软引用还要弱一些。这些对象只能生存到下次GC之前。当GC工作时,无论内存是否足够都会将其回收(即只要进行GC,就会对他们进行回收。)

4)虚引用(Phantom Reference):一个对象是否存在虚引用,完全不会对其生存时间构成影响。

关于方法区中需要回收的是一些废弃的常量和无用的类。

1.废弃的常量的回收。这里看引用计数就可以了。没有对象引用该常量就可以放心的回收了。

2.无用的类的回收。什么是无用的类呢?

A.该类所有的实例都已经被回收。也就是Java堆中不存在该类的任何实例;

B.加载该类的ClassLoader已经被回收;

C.该类对应的java.lang.Class对象没有任何地方被引用,无法在任何地方通过反射访问该类的方法。

总而言之:

对于堆中的对象,主要用可达性分析判断一个对象是否还存在引用,如果该对象没有任何引用就应该被回收。而根据我们实际对引用的不同需求,又分成了4中引用,每种引用的回收机制也是不同的。

对于方法区中的常量和类,当一个常量没有任何对象引用它,它就可以被回收了。而对于类,如果可以判定它为无用类,就可以被回收了。

4.在开发中遇到过内存溢出么?原因有哪些?解决方法有哪些?

引起内存溢出的原因有很多种,常见的有以下几种:

1.内存中加载的数据量过于庞大,如一次从数据库取出过多数据;

2.集合类中有对对象的引用,使用完后未清空,使得JVM不能回收;

3.代码中存在死循环或循环产生过多重复的对象实体;

4.使用的第三方软件中的BUG;

5.启动参数内存值设定的过小;

内存溢出的解决方案:

第一步,修改JVM启动参数,直接增加内存。(-Xms,-Xmx参数一定不要忘记加。)

第二步,检查错误日志,查看“OutOfMemory”错误前是否有其它异常或错误。

第三步,对代码进行走查和分析,找出可能发生内存溢出的位置。

重点排查以下几点:

1.检查对数据库查询中,是否有一次获得全部数据的查询。一般来说,如果一次取十万条记录到内存,就可能引起内存溢出。这个问题比较隐蔽,在上线前,数据库中数据较少,不容易出问题,上线后,数据库中数据多了,一次查询就有可能引起内存溢出。因此对于数据库查询尽量采用分页的方式查询。

2.检查代码中是否有死循环或递归调用。

3.检查是否有大循环重复产生新对象实体。

4.检查对数据库查询中,是否有一次获得全部数据的查询。一般来说,如果一次取十万条记录到内存,就可能引起内存溢出。这个问题比较隐蔽,在上线前,数据库中 数据较少,不容易出问题,上线后,数据库中数据多了,一次查询就有可能引起内存溢出。因此对于数据库查询尽量采用分页的方式查询。

5.检查List、MAP等集合对象是否有使用完后,未清除的问题。List、MAP等集合对象会始终存有对对象的引用,使得这些对象不能被GC回收。

第四步,使用内存查看工具动态查看内存使用情况。

方法区、堆、虚拟机栈、本地方法栈、程序计数器。其中,方法区和堆是为所有线程所共享的,其它三个是线程隔离的。

程序计数器是一块较小的内存空间,它可以看作是当前线程所执行的字节码的行号指示器。在虚拟机的概念模型里,字节码解释器工作时就是通过改变这个计数器的值来选取下一条需要执行的字节码指令。分支、循环、跳转、异常处理、线程恢复等基础功能都需要依赖这个计数器来完成。

由于Java虚拟机的多线程是通过线程轮流切换并分配处理器执行时间的方式来实现的,在任何一个确定的时刻,一个处理器(对于多核处理器来说是一个内核)都只会执行一条线程中的指令。因此,为了线程切换后能恢复到正确的执行位置,每条线程都需要有一个独立的程序计数器,各条线程之间计数器互不影响,独立存储。

如果线程正在执行的是一个Java方法,这个计数器记录的是正在执行的虚拟机字节码指令的地址;

==如果正在执行的是Native方法,这个计数器值则为空(Undefined)。==

此内存区域是唯一一个在Java虚拟机规范中没有规定任何OutOfMemoryError情况的区域。

Java虚拟机栈的生命周期与线程相同。虚拟机栈描述的是Java方法执行的内存模型:每个方法在执行的同时都会创建一个栈帧用于存储局部变量表、操作数栈、动态链接、方法出口等信息。每一个方法从调用直至执行完成的过程,就对应着一个栈帧在虚拟机栈中入栈到出栈的过程。局部变量表存放了编译期可知的各种基本数据类型、对象引用和returnAddress类型。

局部变量表所需的内存空间在编译期间完成分配,当进入一个方法时,这个方法需要在帧中分配多大的局部变量空间是完全确定的,在方法运行期间不会改变局部变量表的大小。

如果线程请求的栈深度大于虚拟机所允许的深度,将抛出StackOverflowError异常。

本地方法栈与虚拟机栈所发挥的作用是非常相似的,它们之间的区别不过是虚拟机栈为虚拟机执行Java方法服务,而本地方法栈则为虚拟机使用到的Native方法服务。本地方法栈区域也会抛出StackOverflowError异常。

对于大多数应用来说,Java堆是Java虚拟机所管理的内存中最大的一块。Java堆是被所有线程共享的一块内存区域,在虚拟机启动时创建。此内存区域的唯一目的就是存放对象实例,几乎所有的对象实例都在这里分配内存。

Java堆是垃圾收集器管理的主要区域。从内存回收的角度来看,由于现在收集器基本都采用分代收集算法,所以Java堆中还可以细分为:新生代和老年代。

根据Java虚拟机规范的规定,Java堆可以处于物理上不连续的内存空间中,只要逻辑上是连续的即可,就像我们的磁盘空间一样。在实现时,既可以实现成固定大小的,也可以是可扩展的,不过当前主流的虚拟机都是按照可扩展来实现的。如果在堆中没有内存完成实例分配,并且堆也无法再扩展时,将会抛出OutOfMemoryError异常。

方法区与Java堆一样,是各个线程共享的内存区域,它用于存储已被虚拟机加载的类信息、常量、静态变量、即时编译器编译后的代码等数据。

Java虚拟机规范对方法区的限制非常宽松,除了和Java堆一样不需要连续的内存和可以选择固定大小或者可扩展外,还可以选择不实现垃圾收集。相对而言,垃圾收集行为在这个区域是比较少出现的,但并非数据进入了方法区就如永久代的名字一样“永久”存在了。这区域的内存回收目标主要是针对常量池的回收和对类型的卸载,一般来说,这个区域的回收“成绩”比较难以令人满意,尤其是类型的卸载,条件相当苛刻,但是这部分区域的回收确实是必要的。

根据Java虚拟机规范的规定,当方法区无法满足内存分配需求时,将抛出OutOfMemoryError异常。

运行时常量池是方法区的一部分。Class文件中除了有类的版本、字段、方法、接口等描述信息外,还有一项信息是常量池,用于存放编译期生成的各种字面量和符号引用,这部分内容将在类加载后进入方法区的运行时常量池中存放。当常量池无法再申请到内存时会抛出OutOfMemoryError异常。

直接内存并不是虚拟机运行时数据区的一部分,也不是Java虚拟机规范中定义的内存区域。但是这部分内存也被频繁地使用,而且也可能导致OutOfMemoryError异常出现,所以我们放到这里一起讲解。在JDK 1.4中新加入了NIO(New Input/Output)类,引入了一种基于通道(Channel)与缓冲区(Buffer)的I/O方式,它可以使用Native函数库直接分配堆外内存,然后通过一个存储在Java堆中的DirectByteBuffer对象作为这块内存的引用进行操作。这样能在一些场景中显著提高性能,因为避免了在Java堆和Native堆中来回复制数据。显然,本机直接内存的分配不会受到Java堆大小的限制,但是,既然是内存,肯定还是会受到本机总内存(包括RAM以及SWAP区或者分页文件)大小以及处理器寻址空间的限制。服务器管理员在配置虚拟机参数时,会根据实际内存设置-Xmx等参数信息,但经常忽略直接内存,使得各个内存区域总和大于物理内存限制(包括物理的和操作系统级的限制),从而导致动态扩展时出现OutOfMemoryError异常。

给对象中添加一个引用计数器,每当有一个地方引用它时,计数器值就加1;当引用失效时,计数器值就减1;任何时刻计数器为0的对象就是不可能再被使用的。

引用计数算法的实现简单,判定效率也很高,在大部分情况下它都是一个不错的算法。但是,主流的Java虚拟机里面没有选用引用计数算法来管理内存,其中最主要的原因是它很难解决对象之间相互循环引用的问题。

这个算法的基本思路就是通过一系列的称为“GC Roots”的对象作为起始点,从这些节点开始向下搜索,搜索所走过的路径称为引用链,当一个对象到GC Roots没有任何引用链相连时,则证明此对象是不可用的。

在Java语言中,可作为GC Roots的对象包括下面几种:

- 虚拟机栈(栈帧中的本地变量表)中引用的对象。

- 方法区中类静态属性引用的对象。

- 方法区中常量引用的对象。

- 本地方法栈中JNI(即一般说的Native方法)引用的对象。

即使在可达性分析算法中不可达的对象,也并非是“非死不可”的,这时候它们暂时处于“缓刑”阶段,要真正宣告一个对象死亡,至少要经历两次标记过程:如果对象在进行可达性分析后发现没有与GC Roots相连接的引用链,那它将会被第一次标记并且进行一次筛选,筛选的条件是此对象是否有必要执行finalize()方法。当对象没有覆盖finalize()方法,或者finalize()方法已经被虚拟机调用过,虚拟机将这两种情况都视为“没有必要执行”。

如果这个对象被判定为有必要执行finalize()方法,那么这个对象将会放置在一个叫做F-Queue的队列之中,并在稍后由一个由虚拟机自动建立的、低优先级的Finalizer线程去执行它。这里所谓的“执行”是指虚拟机会触发这个方法,但并不承诺会等待它运行结束,这样做的原因是,如果一个对象在finalize()方法中执行缓慢,或者发生了死循环(更极端的情况),将很可能会导致F-Queue队列中其他对象永久处于等待,甚至导致整个内存回收系统崩溃。finalize()方法是对象逃脱死亡命运的最后一次机会,稍后GC将对F-Queue中的对象进行第二次小规模的标记,如果对象要在finalize()中成功拯救自己——只要重新与引用链上的任何一个对象建立关联即可,譬如把自己(this关键字)赋值给某个类变量或者对象的成员变量,那在第二次标记时它将被移除出“即将回收”的集合;如果对象这时候还没有逃脱,那基本上它就真的被回收了。

最基础的收集算法是“标记-清除”算法,如同它的名字一样,算法分为“标记”和“清除”两个阶段:首先标记出所有需要回收的对象,在标记完成后统一回收所有被标记的对象。

它的主要不足有两个:一个是效率问题,标记和清除两个过程的效率都不高;另一个是空间问题,标记清除之后会产生大量不连续的内存碎片,空间碎片太多可能会导致以后在程序运行过程中需要分配较大对象时,无法找到足够的连续内存而不得不提前触发另一次垃圾收集动作。

为了解决效率问题,一种称为“复制”的收集算法出现了,它将可用内存按容量划分为大小相等的两块,每次只使用其中的一块。当这一块的内存用完了,就将还存活着的对象复制到另外一块上面,然后再把已使用过的内存空间一次清理掉。这样使得每次都是对整个半区进行内存回收,内存分配时也就不用考虑内存碎片等复杂情况,只要移动堆顶指针,按顺序分配内存即可,实现简单,运行高效。只是这种算法的代价是将内存缩小为了原来的一半,未免太高了一点。

现在的商业虚拟机都采用这种收集算法来回收新生代,IBM公司的专门研究表明,新生代中的对象98%是“朝生夕死”的,所以并不需要按照1∶1的比例来划分内存空间,而是将内存分为一块较大的Eden空间和两块较小的Survivor空间,每次使用Eden和其中一块Survivor。当回收时,将Eden和Survivor中还存活着的对象一次性地复制到另外一块Survivor空间上,最后清理掉Eden和刚才用过的Survivor空间。HotSpot虚拟机默认Eden和Survivor的大小比例是8∶1,也就是每次新生代中可用内存空间为整个新生代容量的90% (80%+10%),只有10%的内存会被“浪费”。当然,98%的对象可回收只是一般场景下的数据,我们没有办法保证每次回收都只有不多于10%的对象存活,当Survivor空间不够用时,需要依赖其他内存(这里指老年代)进行分配担保。

复制收集算法在对象存活率较高时就要进行较多的复制操作,效率将会变低。更关键的是,如果不想浪费50%的空间,就需要有额外的空间进行分配担保,以应对被使用的内存中所有对象都100%存活的极端情况,所以在老年代一般不能直接选用这种算法。

根据老年代的特点,有人提出了另外一种“标记-整理”(Mark-Compact)算法,标记过程仍然与“标记-清除”算法一样,但后续步骤不是直接对可回收对象进行清理,而是让所有存活的对象都向一端移动,然后直接清理掉端边界以外的内存。

建议看:javap查看java字节码_dengyu的专栏-CSDN博客_javap 字节码

javap -c -s -v -l 查看字节码

在聊 Java 类加载机制之前,需要先了解一下 Java 字节码,因为它和类加载机制息息相关。

计算机只认识 0 和 1,所以任何语言编写的程序都需要编译成机器码才能被计算机理解,然后执行,Java 也不例外。

Java 在诞生的时候喊出了一个非常牛逼的口号:“Write Once, Run Anywhere”,为了达成这个目的,Sun 公司发布了许多可以在不同平台(Windows、Linux)上运行的 Java 虚拟机(JVM)——负责载入和执行 Java 编译后的字节码。

到底 Java 字节码是什么样子,我们借助一段简单的代码来看一看。

源码如下:

package com.cmower.java_demo;

public class Test {

public static void main(String[] args) {

System.out.println("沉默王二");

}

}

代码编译通过后,通过 xxd Test.class 命令查看一下这个字节码文件。

xxd Test.class

00000000: cafe babe 0000 0034 0022 0700 0201 0019 .......4."......

00000010: 636f 6d2f 636d 6f77 6572 2f6a 6176 615f com/cmower/java_

00000020: 6465 6d6f 2f54 6573 7407 0004 0100 106a demo/Test......j

00000030: 6176 612f 6c61 6e67 2f4f 626a 6563 7401 ava/lang/Object.

00000040: 0006 3c69 6e69 743e 0100 0328 2956 0100 ..<init>...()V..

00000050: 0443 6f64 650a 0003 0009 0c00 0500 0601 .Code...........

00000060: 000f 4c69 6e65 4e75 6d62 6572 5461 626c ..LineNumberTabl

感觉有点懵逼,对不对?

懵就对了。

这段字节码中的 cafe babe 被称为“魔数”,是 JVM 识别 .class 文件的标志。文件格式的定制者可以自由选择魔数值(只要没用过),比如说 .png 文件的魔数是 8950 4e47。

至于其他内容嘛,可以选择忘记了。

类加载的过程:JavaGuide

准备:我们定义了public static int value=111 ,那么 value 变量在准备阶段的初始值就是 0 而不是111(初始化阶段才会赋值)。特殊情况:比如给 value 变量加上了 fianl 关键字public static final int value=111 ,那么准备阶段 value 的值就被赋值为 111

解析动作:主要针对类或接口、字段、类方法、接口方法、方法类型、方法句柄和调用限定符7类符号引用进行。符号引用就是一组符号来描述目标,可以是任何字面量

了解了 Java 字节码后,我们来聊聊 Java 的类加载过程。

Java 的类加载过程可以分为 5 个阶段:载入、验证、准备、解析和初始化。这 5 个阶段一般是顺序发生的,但在动态绑定的情况下,解析阶段发生在初始化阶段之后。

-

Loading(载入)

JVM 在该阶段的主要目的是将字节码从不同的数据源(可能是 class 文件、也可能是 jar 包,甚至网络)转化为二进制字节流加载到内存中,并生成一个代表该类的

java.lang.Class对象。 -

Verification(验证)

JVM 会在该阶段对二进制字节流进行校验,只有符合 JVM 字节码规范的才能被 JVM 正确执行。该阶段是保证 JVM 安全的重要屏障,下面是一些主要的检查。

- 确保二进制字节流格式符合预期(比如说是否以

cafe bene开头)。 - 是否所有方法都遵守访问控制关键字的限定。

- 方法调用的参数个数和类型是否正确。

- 确保变量在使用之前被正确初始化了。

- 检查变量是否被赋予恰当类型的值。

- 确保二进制字节流格式符合预期(比如说是否以

-

Preparation(准备)

JVM 会在该阶段对类变量(也称为静态变量,

static关键字修饰的)分配内存并初始化(对应数据类型的默认初始值,如 0、0L、null、false 等)。也就是说,假如有这样一段代码:

public String chenmo = "沉默"; public static String wanger = "王二"; public static final String cmower = "沉默王二";

chenmo 不会被分配内存,而 wanger 会;但 wanger 的初始值不是“王二”而是

null。需要注意的是,

static final修饰的变量被称作为常量,和类变量不同。常量一旦赋值就不会改变了,所以 cmower 在准备阶段的值为“沉默王二”而不是null。 -

Resolution(解析)

该阶段将常量池中的符号引用转化为直接引用。

what?符号引用,直接引用?

符号引用以一组符号(任何形式的字面量,只要在使用时能够无歧义的定位到目标即可)来描述所引用的目标。

在编译时,Java 类并不知道所引用的类的实际地址,因此只能使用符号引用来代替。比如

com.Wanger类引用了com.Chenmo类,编译时 Wanger 类并不知道 Chenmo 类的实际内存地址,因此只能使用符号com.Chenmo。直接引用通过对符号引用进行解析,找到引用的实际内存地址。

-

Initialization(初始化)

该阶段是类加载过程的最后一步。在准备阶段,类变量已经被赋过默认初始值,而在初始化阶段,类变量将被赋值为代码期望赋的值。换句话说,初始化阶段是执行类构造器方法的过程。

oh,no,上面这段话说得很抽象,不好理解,对不对,我来举个例子。

String cmower = new String("沉默王二");

上面这段代码使用了

new关键字来实例化一个字符串对象,那么这时候,就会调用 String 类的构造方法对 cmower 进行实例化。

聊完类加载过程,就不得不聊聊类加载器。

一般来说,Java 程序员并不需要直接同类加载器进行交互。JVM 默认的行为就已经足够满足大多数情况的需求了。不过,如果遇到了需要和类加载器进行交互的情况,而对类加载器的机制又不是很了解的话,就不得不花大量的时间去调试

ClassNotFoundException 和 NoClassDefFoundError 等异常。

对于任意一个类,都需要由它的类加载器和这个类本身一同确定其在 JVM 中的唯一性。也就是说,如果两个类的加载器不同,即使两个类来源于同一个字节码文件,那这两个类就必定不相等(比如两个类的 Class 对象不 equals)。

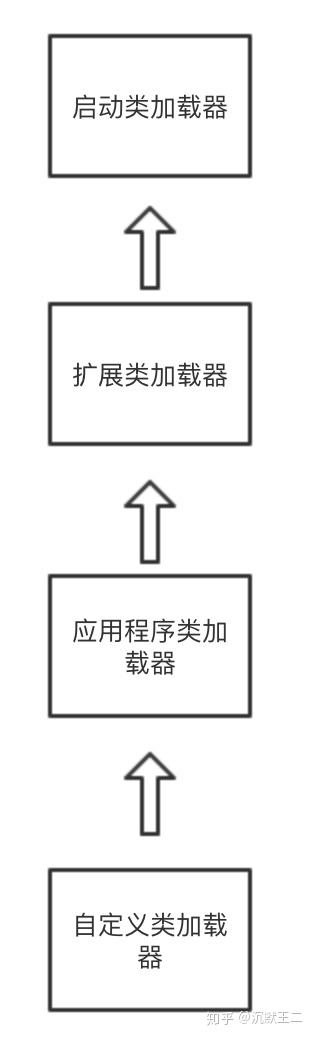

站在程序员的角度来看,Java 类加载器可以分为三种。

-

启动类加载器(Bootstrap Class-Loader),加载

jre/lib包下面的 jar 文件,比如说常见的 rt.jar。 -

扩展类加载器(Extension or Ext Class-Loader),加载

jre/lib/ext包下面的 jar 文件。 -

应用类加载器(Application or App Clas-Loader),根据程序的类路径(classpath)来加载 Java 类。

来来来,通过一段简单的代码了解下。

public class Test {

public static void main(String[] args) {

ClassLoader loader = Test.class.getClassLoader();

while (loader != null) {

System.out.println(loader.toString());

loader = loader.getParent();

}

}

}每个 Java 类都维护着一个指向定义它的类加载器的引用,通过 类名.class.getClassLoader() 可以获取到此引用;然后通过 loader.getParent() 可以获取类加载器的上层类加载器。

这段代码的输出结果如下:

sun.misc.Launcher$AppClassLoader@73d16e93

sun.misc.Launcher$ExtClassLoader@15db9742

第一行输出为 Test 的类加载器,即应用类加载器,它是 sun.misc.Launcher$AppClassLoader 类的实例;第二行输出为扩展类加载器,是 sun.misc.Launcher$ExtClassLoader 类的实例。那启动类加载器呢?

按理说,扩展类加载器的上层类加载器是启动类加载器,但在我这个版本的 JDK 中, 扩展类加载器的 getParent() 返回 null。所以没有输出。

如果以上三种类加载器不能满足要求的话,程序员还可以自定义类加载器(继承 java.lang.ClassLoader 类),它们之间的层级关系如下图所示。

这种层次关系被称作为双亲委派模型:如果一个类加载器收到了加载类的请求,它会先把请求委托给上层加载器去完成,上层加载器又会委托上上层加载器,一直到最顶层的类加载器;如果上层加载器无法完成类的加载工作时,当前类加载器才会尝试自己去加载这个类。

PS:双亲委派模型突然让我联想到朱元璋同志,这个同志当上了皇帝之后连宰相都不要了,所有的事情都亲力亲为,只有自己没精力没时间做的事才交给大臣们去干。

使用双亲委派模型有一个很明显的好处,那就是 Java 类随着它的类加载器一起具备了一种带有优先级的层次关系,这对于保证 Java 程序的稳定运作很重要。

上文中曾提到,如果两个类的加载器不同,即使两个类来源于同一个字节码文件,那这两个类就必定不相等——双亲委派模型能够保证同一个类最终会被特定的类加载器加载。

操作数栈:后进先出(Last-In-First-Out)的操作数栈,也可以称之为表达式栈(Expression Stack)。

栈是线程私有的,每个线程都是自己的栈,每个线程中的每个方法在执行的同时会创建一个栈帧用于存局部变量表、操作数栈、动态链接、方法返回地址等信息。每一个方法从调用到执行完毕的过程,就对应着一个栈帧在虚拟机栈中从入栈到出栈的过程。其中局部变量表,存放基本类型(boolean、byte、char、short、int、float)、对象的引用等等,对象的引用不是对象实例本身,而是指向对象实例的一个指针。

堆是线程共享的,所有的对象的实例和数组都存放在堆中,任何线程都可以访问。Java的垃圾自动回收机制就是运用这个区域的。

方法区也是线程共享的,用于存放 类信息(包括类的名称、方法信息、字段信息)、常量、静态变量以及即时编译器编译后的代码 等等。

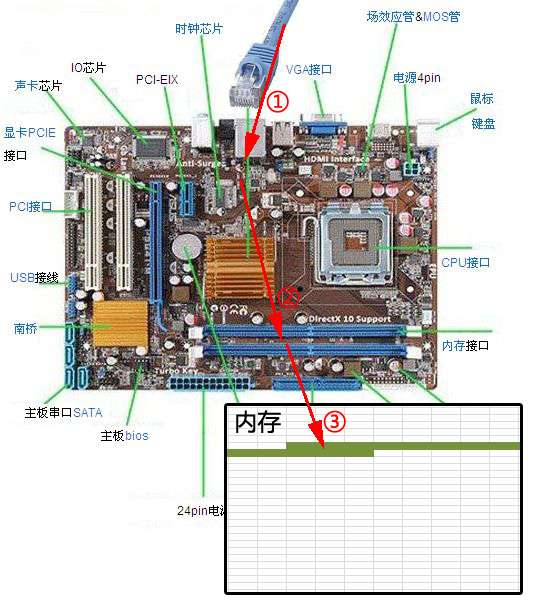

这么讲比较抽象,写段代码:

当程序执行到箭头指向那一个行代码的时候,

入参i和局部变量j都是基本类型,直接存放在栈中。

入参str和oneMoreStudy是对象类型,在栈中只存放对象的引用。

如下图:

对象加载过程中发生了什么:https://blog.csdn.net/weixin_43392489/article/details/102746109

下图便是 Java 对象的创建过程,我建议最好是能默写出来,并且要掌握每一步在做什么。

①类加载检查: 虚拟机遇到一条 new 指令时,首先将去检查这个指令的参数是否能在常量池中定位到这个类的符号引用,并且检查这个符号引用代表的类是否已被加载过、解析和初始化过。如果没有,那必须先执行相应的类加载过程。

②分配内存: 在类加载检查通过后,接下来虚拟机将为新生对象分配内存。对象所需的内存大小在类加载完成后便可确定,为对象分配空间的任务等同于把一块确定大小的内存从 Java 堆中划分出来。分配方式有 “指针碰撞” 和 “空闲列表” 两种,选择那种分配方式由 Java 堆是否规整决定,而Java堆是否规整又由所采用的垃圾收集器是否带有压缩整理功能决定。

内存分配的两种方式:(补充内容,需要掌握)

选择以上两种方式中的哪一种,取决于 Java 堆内存是否规整。而 Java 堆内存是否规整,取决于 GC 收集器的算法是"标记-清除",还是"标记-整理"(也称作"标记-压缩"),值得注意的是,复制算法内存也是规整的

内存分配并发问题(补充内容,需要掌握)

在创建对象的时候有一个很重要的问题,就是线程安全,因为在实际开发过程中,创建对象是很频繁的事情,作为虚拟机来说,必须要保证线程是安全的,通常来讲,虚拟机采用两种方式来保证线程安全:

- CAS+失败重试: CAS 是乐观锁的一种实现方式。所谓乐观锁就是,每次不加锁而是假设没有冲突而去完成某项操作,如果因为冲突失败就重试,直到成功为止。虚拟机采用 CAS 配上失败重试的方式保证更新操作的原子性。

- TLAB: 为每一个线程预先在Eden区分配一块儿内存,JVM在给线程中的对象分配内存时,首先在TLAB分配,当对象大于TLAB中的剩余内存或TLAB的内存已用尽时,再采用上述的CAS进行内存分配

③初始化零值: 内存分配完成后,虚拟机需要将分配到的内存空间都初始化为零值(不包括对象头),这一步操作保证了对象的实例字段在 Java 代码中可以不赋初始值就直接使用,程序能访问到这些字段的数据类型所对应的零值。

④设置对象头: 初始化零值完成之后,虚拟机要对对象进行必要的设置,例如这个对象是那个类的实例、如何才能找到类的元数据信息、对象的哈希吗、对象的 GC 分代年龄等信息。 这些信息存放在对象头中。 另外,根据虚拟机当前运行状态的不同,如是否启用偏向锁等,对象头会有不同的设置方式。

⑤执行 init 方法: 在上面工作都完成之后,从虚拟机的视角来看,一个新的对象已经产生了,但从 Java 程序的视角来看,对象创建才刚开始,<init> 方法还没有执行,所有的字段都还为零。所以一般来说,执行 new 指令之后会接着执行 <init> 方法,把对象按照程序员的意愿进行初始化,这样一个真正可用的对象才算完全产生出来。

1 String 对象的两种创建方式:

String str1 = "abcd";

String str2 = new String("abcd");

System.out.println(str1==str2);//false

这两种不同的创建方法是有差别的,第一种方式是在常量池中拿对象,第二种方式是直接在堆内存空间创建一个新的对象。 记住:只要使用new方法,便需要创建新的对象。

2 String 类型的常量池比较特殊。它的主要使用方法有两种:

- 直接使用双引号声明出来的 String 对象会直接存储在常量池中。

- 如果不是用双引号声明的 String 对象,可以使用 String 提供的 intern 方法。String.intern() 是一个 Native 方法,它的作用是:如果运行时常量池中已经包含一个等于此 String 对象内容的字符串,则返回常量池中该字符串的引用;如果没有,则在常量池中创建与此 String 内容相同的字符串,并返回常量池中创建的字符串的引用。

String s1 = new String("计算机");

String s2 = s1.intern();

String s3 = "计算机";

System.out.println(s2);//计算机

System.out.println(s1 == s2);//false,因为一个是堆内存中的String对象一个是常量池中的String对象,

System.out.println(s3 == s2);//true,因为两个都是常量池中的String对象

3 String 字符串拼接

String str1 = "str";

String str2 = "ing";

String str3 = "str" + "ing";//常量池中的对象

String str4 = str1 + str2; //在堆上创建的新的对象

String str5 = "string";//常量池中的对象

System.out.println(str3 == str4);//false

System.out.println(str3 == str5);//true

System.out.println(str4 == str5);//false

尽量避免多个字符串拼接,因为这样会重新创建对象。如果需要改变字符串的话,可以使用 StringBuilder 或者 StringBuffer。

创建了两个对象。

验证:

String s1 = new String("abc");// 堆内存的地址值

String s2 = "abc";

System.out.println(s1 == s2);// 输出false,因为一个是堆内存,一个是常量池的内存,故两者是不同的。

System.out.println(s1.equals(s2));// 输出true

结果:

false

true

解释:

先有字符串"abc"放入常量池,然后 new 了一份字符串"abc"放入Java堆(字符串常量"abc"在编译期就已经确定放入常量池,而 Java 堆上的"abc"是在运行期初始化阶段才确定),然后 Java 栈的 str1 指向Java堆上的"abc"。

- Java 基本类型的包装类的大部分都实现了常量池技术,即Byte,Short,Integer,Long,Character,Boolean;这5种包装类默认创建了数值[-128,127]的相应类型的缓存数据,但是超出此范围仍然会去创建新的对象。

- 两种浮点数类型的包装类 Float,Double 并没有实现常量池技术。

Integer i1 = 33;

Integer i2 = 33;

System.out.println(i1 == i2);// 输出true

Integer i11 = 333;

Integer i22 = 333;

System.out.println(i11 == i22);// 输出false

Double i3 = 1.2;

Double i4 = 1.2;

System.out.println(i3 == i4);// 输出false

Integer 缓存源代码:

/**

*此方法将始终缓存-128到127(包括端点)范围内的值,并可以缓存此范围之外的其他值。

*/

public static Integer valueOf(int i) {

if (i >= IntegerCache.low && i <= IntegerCache.high)

return IntegerCache.cache[i + (-IntegerCache.low)];

return new Integer(i);

}

应用场景:

- Integer i1=40;Java 在编译的时候会直接将代码封装成Integer i1=Integer.valueOf(40);,从而使用常量池中的对象。

- Integer i1 = new Integer(40);这种情况下会创建新的对象。

Integer i1 = 40;

Integer i2 = new Integer(40);

System.out.println(i1==i2);//输出false

Integer比较更丰富的一个例子:

Integer i1 = 40;

Integer i2 = 40;

Integer i3 = 0;

Integer i4 = new Integer(40);

Integer i5 = new Integer(40);

Integer i6 = new Integer(0);

System.out.println("i1=i2 " + (i1 == i2));

System.out.println("i1=i2+i3 " + (i1 == i2 + i3));

System.out.println("i1=i4 " + (i1 == i4));

System.out.println("i4=i5 " + (i4 == i5));

// i4 == i5 + i6,因为+这个操作符不适用于Integer对象,首先i5和i6进行自动拆箱操作,进行数值相加,即i4 == 40

System.out.println("i4=i5+i6 " + (i4 == i5 + i6));

System.out.println("40=i5+i6 " + (40 == i5 + i6));

结果:

i1=i2 true

i1=i2+i3 true

i1=i4 false

i4=i5 false

i4=i5+i6 true